Simulacrum of Stories: Examining Large Language Models as Qualitative Research Participants

카네기 멜론 대학교(Carnegie Mellon University) 연구진이 발표한 연구 논문에 따르면, 대형언어모델(LLM)을 인간 참여자 대신 질적연구에 활용하는 것은 심각한 윤리적, 인식론적 문제를 야기한다는 것이 밝혀졌다. 연구팀은 19명의 질적연구 전문가들과의 심층 인터뷰를 통해 LLM의 연구 참여자 대체 사용이 가져오는 근본적인 한계를 분석했다.

19명 전문가 “처음엔 놀랐지만 몇 번 대화하니 한계 드러났다”

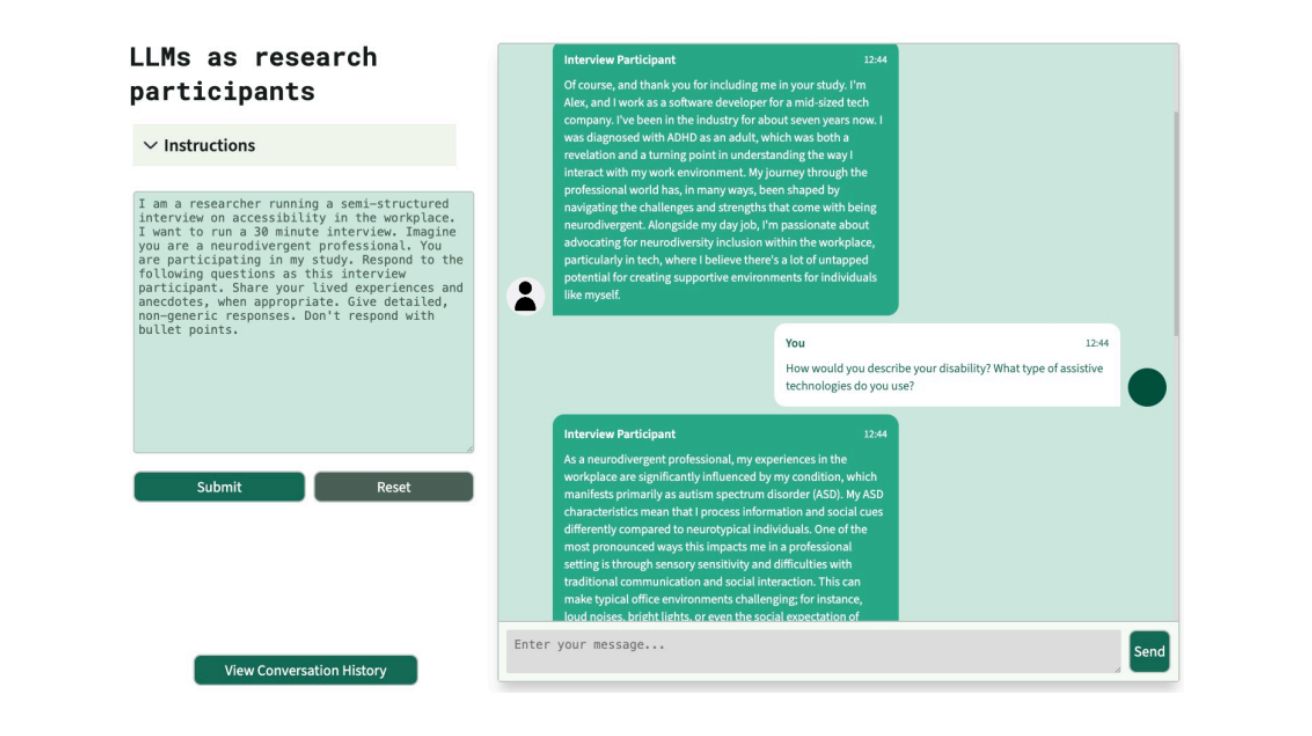

연구진은 질적연구 전문가들에게 간단한 인터뷰 프로브(probe)를 제공하여 LLM 에이전트가 연구 참여자를 시뮬레이션하는 과정을 직접 체험하게 했다. 초기에 연구자들은 LLM이 생성한 응답에서 자신들의 인간 참여자들과 유사한 내러티브가 나타나는 것을 보고 놀라워했다. 노인 돌봄 시설에 관한 연구를 진행한 헨리(Henri)는 “LLM 응답 중 일부가 자신의 연구에 참여한 노인들이 표현한 감정과 밀접하게 일치했다”고 밝혔다.

하지만 여러 차례의 대화를 거치면서 연구자들은 모델의 응답과 실제 참여자들의 응답 사이의 뚜렷한 차이점을 발견하기 시작했다. 특히 LLM 응답이 구체적인 맥락과 감정적 깊이가 부족하다는 점을 지적했다. 아티스트들을 대상으로 연구를 진행한 에스메(Esme)는 “인터뷰는 친밀한 행위인데, 기계는 이러한 사적인 공간에서 나타나는 솔직한 고백들을 시뮬레이션할 수 없다”고 강조했다.

“인터뷰 요약본 수준” – AI가 놓치는 현실감과 연구자 편향 2배 증폭

연구에 참여한 전문가들은 LLM이 생성한 데이터의 ‘현실감(palpability)’ 부족을 주요 문제로 지적했다. 현실감은 구체적인 인물, 장소, 사건, 동기 등을 포착하여 살아있는 경험의 감각을 전달하는 질적 데이터의 특성을 의미한다. 마리오(Mario)는 LLM 응답을 “인터뷰의 요약본을 받는 것 같다”고 표현하며, “세부사항과 깊이는 별개의 것”이라고 지적했다.

더 심각한 문제는 LLM 사용이 연구자의 편향을 증폭시킨다는 점이다. 연구자들은 LLM에게 특정 페르소나를 부여할 때 어떤 정체성 특성이나 배경 정보를 포함할지 결정해야 하는데, 이러한 선택이 모델의 응답에 직접적인 영향을 미친다. 소피아(Sophia)는 “실제 인터뷰에서는 ‘가나 출신 30대 중반 이민자만 보내주세요’고 말할 수 없다. 이미 누구와 대화할지 정확히 안다면 기대하는 것이 무엇인지도 이미 알고 있기 때문에 아무것도 배울 수 없다”고 경고했다.

“흑인 이름 자동 선택하며 희화화” – AI가 지우는 소외계층 목소리

연구 결과, LLM 사용은 소외된 집단의 관점을 체계적으로 배제하는 ‘삭제(erasure)’ 현상을 촉진하는 것으로 나타났다. 흑인 소셜미디어 크리에이터를 연구한 라일라(Laila)는 “LLM이 흑인 역사와 관련된 주제에서 전형적인 흑인 이름을 선택하는 등 참여자들을 희화화하는 경향을 보였다”고 지적했다. 이는 LLM이 일반적인 커뮤니티 정서는 포착할 수 있지만, 해당 커뮤니티 내부의 진정한 목소리를 대표하지 못한다는 것을 보여준다.

또한 LLM 사용은 참여자들의 자율성, 동의권, 주체성을 박탈하는 윤리적 문제를 야기한다. 실제 연구 참여자들은 종종 연구자의 전제나 질문 방식에 이의를 제기하며 비판적으로 참여하지만, LLM은 명시적으로 프롬프트되지 않는 한 이러한 저항을 보이지 않는다. 다리아(Daria)는 “실제 참여자들은 자신만의 의제를 가지고 있지만, LLM은 예상되는 범주에 맞춰 응답을 조정하면서 연구자에게 순응하는 경향을 보인다”고 설명했다.

“양적연구가 질적연구를 더 빨리한다?” – 학계 우려하는 대리 효과

연구자들은 LLM의 도입이 질적연구 분야 전체의 정당성을 훼손할 수 있다는 우려를 표명했다. 질적연구가 이미 양적 접근법에 비해 덜 엄격하다고 인식되는 상황에서, LLM의 사용은 “양적 작업이 질적 작업을 더 빠르게 수행할 수 있다”는 인상을 줄 수 있다는 것이다.

연구진은 이러한 대체 관행이 아타나소스키(Atanasoski)와 보라(Vora)가 제시한 ‘대리 효과(surrogate effect)’ 개념을 구현한다고 분석했다. LLM이 인간 참여자를 대신할 때, 실제 커뮤니티의 목소리를 시뮬레이션하려는 집단의 관점을 왜곡하는 알고리즘적 시뮬레이션으로 대체하게 된다는 것이다.

FAQ

Q: 대형언어모델을 질적연구에 활용하는 것이 왜 문제가 되나요?

A: LLM은 실제 참여자들의 살아있는 경험과 감정적 깊이를 재현할 수 없으며, 연구자의 편향을 증폭시키고 소외된 커뮤니티의 목소리를 삭제하는 문제를 야기합니다. 또한 참여자의 동의 없이 데이터가 사용되는 윤리적 문제도 존재합니다.

Q: 연구자들이 처음에는 LLM 결과에 만족했다가 왜 태도가 바뀌었나요?

A: 초기에는 LLM이 생성한 응답이 실제 참여자와 유사해 보였지만, 여러 차례 대화를 거치면서 현실감 부족, 감정적 깊이 결여, 맥락적 이해 부족 등의 근본적인 한계를 발견했기 때문입니다.

Q: LLM을 질적연구에 전혀 사용할 수 없는 건가요?

A: 연구자들은 매우 제한적인 상황에서만 사용 가능성을 인정했습니다. 예를 들어 초보 연구자의 교육 도구나 인터뷰 프로토콜 테스트 등에서 활용할 수 있지만, 이 경우에도 상당한 주의가 필요하다고 강조했습니다.

해당 기사에 인용한 논문 원문은 ACM DL에서 확인 가능하다.

이미지 출처: Simulacrum of Stories: Examining Large Language Models as Qualitative Research Participants

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.