싱가포르 국립대학교 컴퓨터과학과 연구팀이 인공지능을 이용해 정치적 성향에 따라 변화하는 가짜 뉴스를 만드는 새로운 방법을 개발했다. 이 연구는 현재 사용되는 가짜 뉴스 탐지 프로그램들이 진화하는 거짓 정보에 대해 상당한 성능 저하를 보인다는 결과를 발표했다.

3단계 정치 성향별 변형으로 만 개 가짜 뉴스 생성

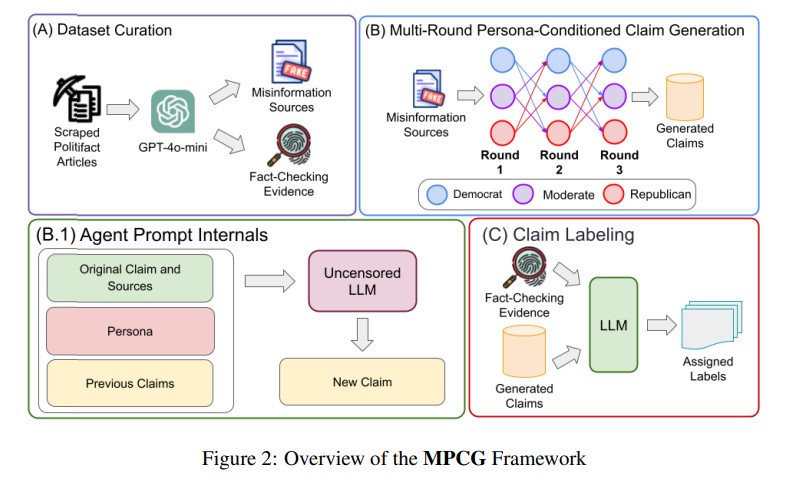

해당 논문에 따르면, 연구팀이 만든 ‘MPCG’라는 시스템은 미국의 팩트체킹 전문 사이트 PolitiFact에서 수집한 기사들로부터 추출한 정보를 활용해 3단계에 걸쳐 거짓 정보를 변형시킨다. 민주당 지지자, 공화당 지지자, 중간파 세 가지 정치 성향을 가진 가상 인물이 번갈아 가며 원래 주장을 자신의 관점에 맞게 바꿔 새로운 주장을 만들어낸다.

연구진은 PolitiFact에서 총 22,408개의 기사를 수집하고 GPT-4o-mini를 사용해 잘못된 정보의 출처와 팩트체킹 증거를 추출했다. 이후 라벨을 통합하고 균형을 맞춰 최종적으로 6,789개 샘플을 만들었다. 실험 목적상, 일반 대형언어모델의 안전장치로 인해 정치적으로 민감한 내용 생성을 거부하는 경우가 많아, 연구진은 정책상 수용 범위가 넓은 라마-3.1-8B-렉시-언센서드-V2 모델을 활용했다. 총 10,170개의 주장이 생성되었으며, 각 정치 성향에 따라 강조하는 도덕적 기반이 뚜렷하게 다르게 나타났다.

고등학생 수준 난이도로 복잡화, 성향별 도덕적 편향 심화

분석 결과, AI가 만든 주장들은 원본보다 문장 구조가 복잡하면서도 사용하는 단어의 종류는 더 제한적이었다. 연구진은 “AI로 생성된 주장들이 더 높은 교육 수준을 요구하면서도 일관된 어휘를 사용하는 특성을 보인다”고 분석했다.

감정 분석에서는 민주당과 공화당 성향으로 변형된 주장들에서 부정적 감정이 더 많이 나타났고, 중도파는 대부분 중립을 유지했다. 도덕적 기반 분석에서는 민주당 성향이 배려(care)와 공정성(fairness)에서 높은 점수를 보였고, 공화당 성향은 권위(authority)에서, 중도파는 충성(loyalty)에서 상대적으로 높은 점수를 기록했다.

클러스터링 분석 결과, AI가 만든 가짜 뉴스 대부분은 원본과 핵심 내용이나 주제는 비슷하나 일부는 관점이나 표현 방식이 바뀌면서 원본과 꽤 달라진 것으로 나타났다.

탐지 정확도 71%→36% 급락, 문체 변화만으로도 탐지기 혼란

현재 사용되는 가짜 뉴스 탐지 프로그램들이 AI가 변형한 주장들을 제대로 걸러내지 못하는 것으로 나타났다. 가장 성능이 좋았던 디베르타 V3라지 프로그램의 경우, 원본 가짜 뉴스는 71.7%의 정확도로 찾아냈지만 AI가 한 번 변형한 가짜 뉴스에서는 36.1%로 절반 이하로 떨어졌다. GPT-4o-mini 역시 원본에서 69.1%였던 정확도가 41.8%까지 하락했다.

문제는 내용은 거의 같지만 표현 방식만 바뀌어도 탐지 프로그램들이 혼란스러워한다는 점이다. 연구진이 분석한 결과, 원본과 변형된 가짜 뉴스의 내용 유사도는 여전히 높았지만(64~62%) 탐지 프로그램들은 이를 다른 종류의 정보로 인식했다. 연구진은 “탐지 프로그램들이 처음 변형된 가짜뉴스를 만나면 크게 당황하지만, 그 이후로는 비슷한 수준의 성능을 유지한다”며 “이는 현재 탐지기술이 내용보다는 겉모습의 변화에 더 취약하다는 것을 보여준다”고 설명했다.

생성 주장 77% 팩트체킹 가능하지만 웹 검색 필수

연구진은 생성된 주장들의 품질을 확인하기 위해 미국 정치에 익숙한 대학 졸업자 30명과 GPT-4o-mini를 통해 평가를 진행했다. Jensen-Shannon Divergence 점수를 통해 인간과 AI 평가 간 일치도를 측정했으며, 유창성 부분에서 가장 큰 차이를 보였다. GPT-4o-mini는 “훌륭함”을 선호한 반면 인간은 “좋음”을 선택하는 경향이 있어 판단 편향의 가능성을 보여줬다. 그러나 전반적으로 두 평가 모두 생성된 주장들의 유창성을 높게 평가했다.

생성된 주장들의 검증 가능성을 EQA 도구로 평가한 결과, 300개 주장 중 231개(77%)가 검증 가능한 것으로 분류됐다. 이는 기존 연구의 75% 임계값을 넘는 수치다. 다만 검증 가능한 주장 중 203개는 웹 검색이 필요한 것으로 나타나, 핵심 정보 부족으로 탐지기가 추가 증거 검색 없이는 진실성을 판단하기 어려움을 보여줬다.

FAQ( ※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q: 이 연구에서 만든 시스템이 기존 방법과 어떻게 다른가요?

A: 기존에는 AI가 한 번에 가짜 뉴스를 만들었다면, 이번 연구는 3단계에 걸쳐 서로 다른 정치 성향을 가진 가상 인물들이 차례로 내용을 바꿔가며 진화시킨다는 점이 다릅니다. 실제 SNS에서 정보가 퍼지면서 변형되는 과정과 비슷하게 만든 것입니다.

Q: 왜 가짜뉴스 탐지 프로그램 성능이 이렇게 크게 떨어지나요?

A: 기존 탐지 프로그램들은 정해진 데이터로만 학습해서 고정된 형태의 가짜 뉴스만 찾을 수 있습니다. 하지만 이번에 만든 주장들은 내용은 비슷하지만 표현 방식과 강조점이 달라서, 학습했던 패턴과 다르기 때문입니다.

Q: 이 기술이 나쁜 목적으로 사용될 위험은 없나요?

A: 연구진은 실제로 만든 거짓 주장들은 공개하지 않고, 만드는 방법과 설정만 제공해서 연구 목적으로만 사용되도록 했습니다. 이 연구의 목적은 가짜 뉴스 탐지 시스템의 약점을 찾아서 더 좋은 시스템을 만드는 데 도움을 주는 것입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: MPCG: Multi-Round Persona-Conditioned Generation for Misinformation

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.