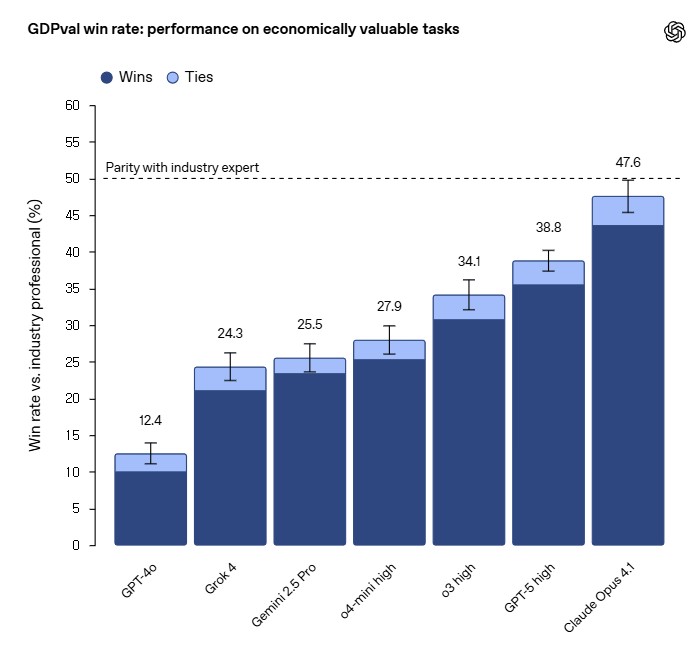

오픈AI가 발표한 새로운 연구에 따르면, 최신 AI 모델들이 실제 경제적 가치를 창출하는 업무에서 인간 전문가에 근접한 성능을 보이는 것으로 나타났다. 이 연구는 미국 GDP의 상위 9개 부문에서 44개 직업의 실제 업무를 대상으로 한 새로운 벤치마크 ‘GDPval’을 통해 AI의 경제적 영향력을 직접 측정했다.

1,320개 실무 과제로 검증한 AI 성능, Claude Opus 4.1이 최고 기록

연구진은 전체 1,320개 과제와 220개의 골드 서브셋을 구성해 대규모 평가를 실시했다. 각 과제는 평균 14년 경력의 업계 전문가들이 실제 업무를 바탕으로 작성했으며, 과제당 평균 5회의 인간 전문가 검토(최소 3회)를 거쳐 품질을 보장했다.

인간 전문가와의 일대일 비교에서 Claude Opus 4.1이 전체적으로 최고 성능을 보였으며, 47.6%의 경우 인간 전문가보다 우수하거나 동등한(승리+무승부) 결과를 달성했다. 순수 승률(승리만)로는 GPT-5가 38.8%, o3가 34.1%, Gemini 2.5 Pro가 27.9%, Grok 4가 25.5%, o4-mini가 24.3%, GPT-4o가 12.4%를 기록했다.

Claude는 미적 요소, GPT-5는 정확성에서 각각 강점 발휘

모델별 특성을 분석한 결과 흥미로운 차이점이 드러났다. Claude Opus 4.1은 문서 서식, 슬라이드 레이아웃 등 미적 요소에서 뛰어난 성능을 보인 반면, GPT-5는 지시 사항을 주의 깊게 따르고 정확한 계산을 수행하는 정확성 측면에서 우수했다. 또한 Claude는 PDF, Excel, PowerPoint 등 멀티모달 파일 처리에서 더 나은 시각적 및 미적 능력을 보였고, GPT-5는 순수 텍스트 작업에서 더 나은 성과를 보였다.

실패 유형을 분석한 결과, 모든 모델에서 지시 사항 미준수가 가장 큰 실패 원인으로 나타났다. Claude, Grok, Gemini는 주로 지시 사항 미준수로 인해 실패했고, GPT-5는 서식 오류가 가장 적은 지시 사항 미준수 문제를 보였다. Gemini와 Grok은 결과물을 제공하겠다고 약속했지만 실제로는 제공하지 않거나, 참조 데이터를 무시하거나, 잘못된 형식을 사용하는 경우가 빈번했다.

AI 도입 시 상당한 시간·비용 절약 효과 확인

연구진은 여러 시나리오를 분석해 AI 모델을 전문가 워크플로우에 통합할 때의 잠재적 시간 및 비용 절약 효과를 측정했다. ‘모델을 먼저 시도하고, 여전히 불만족스러우면 직접 수정하는’ 방식에서 전문가는 상당한 시간과 비용을 절약할 수 있는 것으로 나타났다.

각 과제는 전문가가 완료하는 데 평균 7시간이 소요되며, 일부 과제는 최대 여러 주에 걸친 작업을 필요로 했다. 골드 서브셋에서 각 비교를 채점하는 데는 평균 1시간 이상이 걸렸다. 연구진이 GPT-5에 대해 더 철저한 검증을 요구하는 프롬프트를 적용한 결과 성능이 크게 향상되었다. 이전에 생성된 PDF의 절반 이상에 영향을 미쳤던 검은 사각형 아티팩트가 완전히 제거되었고, PowerPoint 파일의 심각한 서식 오류가 86%에서 64%로 감소했다.

3조 달러 규모 전문직 시장 대상 실제 업무 환경 재현

GDPval은 기존 AI 평가와 달리 실제 업무 환경과 매우 유사한 조건을 제공한다. 연구는 미국 노동통계청의 작업 활동 분류를 기반으로 연간 3조 달러를 벌어들이는 44개 직업군을 선정했다. 과제들은 CAD 설계 파일, 사진, 비디오, 오디오, 소셜미디어 게시물, 다이어그램, 슬라이드, 스프레드시트, 고객 지원 대화 등 다양한 형태의 파일을 다뤄야 한다. 골드 서브셋에서는 최대 17개, 전체 세트에서는 최대 38개의 참조 파일을 처리해야 하는 복잡한 작업들로 구성되어 있다.

연구진은 220개 과제의 골드 서브셋을 오픈소스로 공개하고 evals.openai.com에서 실험적 자동 채점 서비스를 제공한다고 밝혔다. 이 자동화 채점기는 인간 전문가 채점자와 66%의 일치율을 보였는데, 이는 인간 전문가 간 일치율 71%보다 단 5% 낮은 수준이다.

AI 도입의 현실적 과제와 신중한 접근 필요성

이번 연구 결과는 분명 주목할 만한 성과지만, 실제 업무 현장에서의 AI 도입에는 여전히 신중한 접근이 필요하다. 연구에서 확인된 AI의 38.8% 승률은 역설적으로 인간 전문가가 61.2%의 경우에서 여전히 우수한 성과를 보인다는 의미이기도 하다.

특히 연구진이 지적한 AI의 주요 실패 요인들 – 지시 사항 미준수, 맥락 파악 부족, 서식 오류 등은 실제 업무에서 심각한 문제를 야기할 수 있다. 법률 문서의 오타나 의료 진단의 오류처럼 전문직 영역에서는 작은 실수도 큰 책임 문제로 이어질 수 있기 때문이다. 연구에서도 GPT-5 실패 사례 중 약 3%가 실제 사용 시 재앙적 결과를 초래할 수 있는 ‘심각한 오류’로 분류되었다.

더욱이 이 연구는 상대적으로 제한된 조건에서 수행되었다. 실제 업무 환경에서는 고객과의 실시간 상호작용, 예상치 못한 변수 대응, 윤리적 판단 등 AI가 처리하기 어려운 요소들이 많다. 따라서 당분간은 AI를 보조 도구로 활용하면서 인간 전문가의 최종 검토와 승인을 거치는 하이브리드 접근방식이 가장 현실적일 것으로 보인다.

결국 AI 기술의 발전 속도가 빨라도, 전문직 분야에서의 실질적 활용은 안전성 검증, 법적 책임 문제, 윤리적 가이드라인 정립 등을 충분히 고려한 후 점진적으로 확대되어야 할 것이다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. GDPval이 기존 AI 평가 방법과 다른 점은 무엇인가요?

A1. GDPval은 학술적 테스트가 아닌 실제 업계 전문가들의 업무를 바탕으로 만들어진 과제들로 구성되어 있습니다. 또한 다양한 파일 형식을 다뤄야 하며, 정확성뿐만 아니라 구조, 스타일, 형식, 미적 요소, 관련성 등 주관적 요소도 평가에 포함됩니다.

Q2. AI 모델이 인간 전문가를 완전히 대체할 수 있을까요?

A2. 현재 연구 결과로는 완전한 대체보다는 보완적 역할이 더 적절해 보입니다. 최고 성능의 AI 모델도 인간 전문가가 더 나은 결과를 보이는 경우가 절반 이상이며, 특히 지시 사항을 완전히 따르지 못하는 경우가 빈번합니다.

Q3. 어떤 유형의 업무에서 AI 성능이 두드러지나요?

A3. 연구 결과 Claude는 시각적 요소와 미적 측면에서, GPT-5는 정확성과 지시사항 준수에서 각각 강점을 보였습니다. 하지만 모든 모델이 때로는 데이터를 환각하거나 계산을 잘못하는 등의 정확성 오류를 보이기도 했습니다.

해당 기사에 인용된 논문 원문은 오픈AI 뉴스룸에서 확인 가능하다.

논문명: GDPVAL: EVALUATING AI MODEL PERFORMANCE ON REAL-WORLD ECONOMICALLY VALUABLE TASKS

이미지 출처: 오픈AI

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.