구글 리서치가 현재 인공지능의 근본적인 문제점을 지적하며, 이를 해결할 새로운 학습 방법 ‘중첩 학습(Nested Learning)’을 제안했다. 이 연구는 챗GPT 같은 대규모 언어모델이 왜 대화 중에 배운 내용을 영구적으로 저장하지 못하는지, 그리고 어떻게 하면 지속적으로 학습할 수 있는지에 대한 답을 제시한다.

현재 AI는 대화 중 배운 걸 영구 저장하지 못한다

구글 연구팀은 현재의 대규모 언어모델을 ‘전향성 기억상실증’ 환자에 비유했다. 전향성 기억상실증은 뇌 손상 이후 새로운 장기 기억을 만들지 못하는 질환이다. 과거 기억은 그대로 있지만, 새로운 정보는 장기 기억으로 저장되지 않는다. 환자는 지금 이 순간과 먼 옛날 기억에만 의존하며, 매 순간을 처음 경험하는 것처럼 느낀다.

챗GPT 같은 AI도 비슷한 상황이다. 모델 내부의 설정값(파라미터)은 대화 중에 실시간으로 바뀌지 않는다. AI의 지식은 두 가지로 제한된다. 첫째는 대화창에 보이는 내용이고, 둘째는 AI를 만들 때 미리 학습시킨 지식이다. 대화 중에 새로운 예시를 보고 즉시 따라 하는 능력(인컨텍스트 학습)은 있지만, 대화가 끝나면 그 내용을 영구적으로 기억하지는 못한다. 일부 연구에서는 이를 해결하려는 시도가 있지만, 여전히 근본적인 한계가 있다.

연구팀은 인간의 뇌가 어떻게 기억을 만드는지 연구하며 해법을 찾았다. 인간의 뇌는 새로운 정보를 장기 기억으로 만들 때 두 단계를 거친다. 첫 번째는 배우는 즉시 일어나는 ‘빠른 기억 고정’ 단계다. 이때 새로운 기억이 안정화되며 임시 기억에서 영구 기억으로 옮겨가기 시작한다. 두 번째는 주로 잠잘 때 일어나는 ‘느린 기억 고정’ 단계다. 뇌의 해마에서 대뇌피질로 기억이 전달되면서 반복 재생되고 강화된다.

현재 AI는 특히 첫 번째 단계에 문제가 있다. 대화에서 들어온 정보가 AI의 영구 저장 공간에 영향을 주지 못한다. 정보가 임시 저장 공간에만 있으면 대화 범위를 벗어나면 사라진다.

뇌의 기억 방식에서 힌트 얻은 ‘중첩 학습’

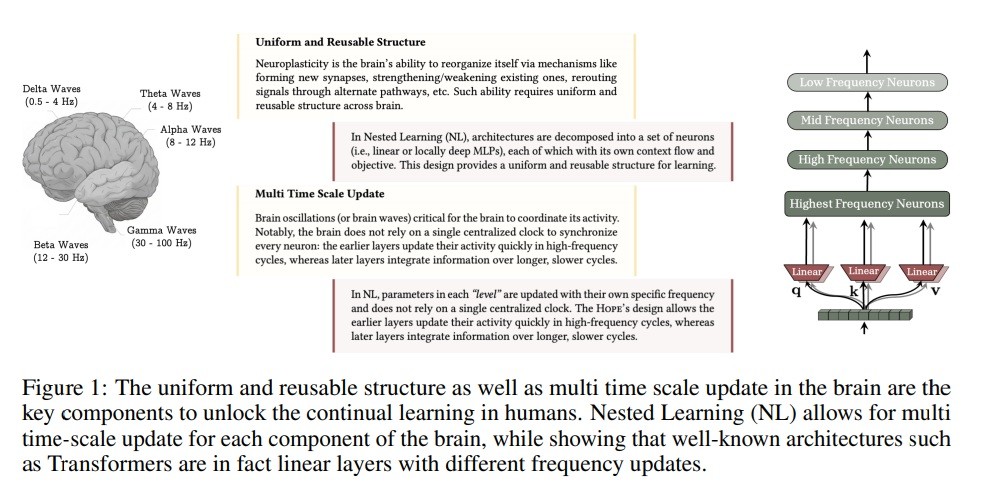

중첩 학습은 AI 모델을 완전히 새로운 방식으로 바라본다. 기존에는 AI를 단순히 여러 층을 쌓은 구조로 봤다면, 중첩 학습은 AI를 여러 단계의 학습 과정이 겹친 시스템으로 본다. 각 단계는 자신만의 정보 흐름과 업데이트 속도를 가진다. 논문은 AI의 부분마다 다른 속도로 정보를 업데이트하는 구조가 필요하다고 강조한다. 이는 인간 뇌가 여러 단계에 걸쳐 기억을 고정하는 과정과 비슷하다. 빠르게 업데이트되는 부분은 지금 들어오는 정보에 즉시 반응하고, 느리게 업데이트되는 부분은 오랜 시간에 걸친 패턴을 배운다.

연구팀은 기존 AI가 데이터를 배울 때 실제로는 정보를 압축해서 저장한다는 것을 밝혀냈다. 이 과정을 여러 단계로 나누어 각각 다른 속도로 작동하게 만들면, 더 효과적으로 학습할 수 있다.

학습 알고리즘도 사실은 ‘정보 압축 장치’

중첩 학습의 흥미로운 발견 중 하나는 우리가 흔히 쓰는 학습 알고리즘들을 새로운 관점에서 볼 수 있다는 점이다. 논문은 SGD, Adam 같은 학습 알고리즘이 과거의 학습 정보를 압축해서 보관한다고 설명한다.

예를 들어, ‘모멘텀’이라는 기법은 과거의 학습 방향을 기억해서 활용한다. 이를 정보를 압축해 저장하는 장치로 볼 수 있다. 다만 논문은 기존 방식의 한계도 지적한다. 기본 모멘텀은 단순한 구조라 저장할 수 있는 정보가 제한적이다.

연구팀은 이를 개선하는 방법들을 제안했다. 예를 들어 기본 모멘텀을 더 복잡한 신경망 구조로 바꾸면 더 많은 정보를 담을 수 있다. 이를 ‘깊은 모멘텀 학습법’이라고 부른다.

HOPE: 여러 단계 기억 창고를 가진 새로운 AI

중첩 학습 아이디어를 실제로 만든 것이 HOPE라는 새로운 AI 모델이다. 기존 AI는 크게 두 부분으로 나뉜다. 첫째는 문장 전체 정보를 합치는 임시 기억 공간, 둘째는 학습한 지식을 담는 영구 기억 공간이다.

연구팀이 제안한 ‘연속체 기억 시스템’은 여러 개의 기억 블록을 연결한 구조다. 각 블록은 서로 다른 업데이트 주기를 가진다. 어떤 블록은 매번 업데이트되고, 어떤 블록은 수백 번에 한 번씩만 업데이트된다. 빠른 블록은 즉각적인 패턴을, 느린 블록은 추상적인 장기 지식을 담당한다.

기존 Transformer는 이 시스템의 가장 단순한 형태로, 하나의 단계만 가진다. HOPE는 이를 여러 단계로 확장했다. 또한 HOPE는 들어오는 내용에 따라 정보 처리 방식을 스스로 바꿀 수 있다.

일부 테스트에서 기존 모델보다 좋은 결과

연구팀은 언어 이해와 상식 추론 작업으로 HOPE의 성능을 측정했다. 7억 6천만 개 설정값으로 만든 HOPE는 WikiText 테스트에서 26.05 점수를 기록했다. 이 점수는 낮을수록 좋으며, AI가 다음 단어를 얼마나 잘 예측하는지 보여준다.

13억 개 설정값으로 만든 HOPE는 WikiText에서 15.11 점수, LM Benchmark에서 11.63 점수를 받았다. 상식 추론 테스트에서는 평균 57.23%의 정확도를 기록했다.

HOPE는 실험한 일부 테스트에서 Transformer, Gated DeltaNet, Titans 같은 기존 모델들보다 나은 점수를 받았다. 다만 실험 조건과 일부 테스트에서는 결과 차이가 있을 수 있다. 전체적으로 보면, 입력 내용에 따라 처리 방식을 바꾸고 여러 단계 기억 구조를 사용하는 것이 일부 작업에서 더 효과적임을 보여준다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. 중첩 학습이 기존 방식과 어떻게 다른가요?

기존에는 AI를 여러 층을 쌓은 건물처럼 봤다면, 중첩 학습은 AI를 서로 다른 속도로 업데이트되는 여러 학습 과정이 겹친 시스템으로 본다. 인간 뇌가 여러 단계에 걸쳐 기억을 만드는 방식에서 영감을 받아, 각 부분이 자신만의 속도로 정보를 처리하도록 설계한다.

Q2. 챗GPT는 왜 대화 내용을 영구적으로 기억하지 못하나요?

챗GPT 같은 AI는 대화 중에 내부 설정값이 실시간으로 바뀌지 않는다. 대화창의 내용을 보고 즉시 따라 하는 능력은 있지만, 대화에서 들어온 정보가 영구 저장 공간에 영향을 주지 못해 대화가 끝나면 배운 내용이 남지 않는다. 일부 연구에서 이를 해결하려 하지만 여전히 근본적인 한계가 있다.

Q3. HOPE 모델의 특별한 점은 무엇인가요?

HOPE는 여러 단계의 기억 시스템을 가지고 있어서 각 업데이트 주기마다 별도의 기억 공간을 운영한다. 또한 들어오는 내용에 따라 정보 처리 방식을 스스로 조정한다. 실험 결과 일부 언어 이해와 추론 테스트에서 기존 모델들보다 좋은 성능을 보였다.

해당 기사에 인용된 논문 원문은 구글 블로그에서 확인 가능하다.

논문명: Nested Learning: The Illusion of Deep Learning Architectures

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.