싱가포르 공과디자인대학교와 캐나다 토론토대학교 연구진이 인터넷 밈(meme)의 유머를 알아채고 스스로 학습하는 AI 시스템을 만들었다. 이 논문에 따르면, ‘FLoReNce(플로렌스)’라는 이름의 이 시스템은 기존 AI와 달리 자신의 판단이 틀렸을 때 그 이유를 배워서 다음번엔 더 잘 판단한다.

“이게 왜 웃겨?”… 아이러니와 풍자의 미묘한 충돌을 AI는 모른다

인터넷 밈은 사진과 글이 합쳐진 콘텐츠로, 보통 아이러니나 풍자로 사회 이슈를 비꼬거나 재미있게 표현한다. 현재 소셜미디어에서 여론을 형성하고 문화 트렌드를 만드는 데 큰 역할을 한다. 그런데 밈의 유머는 단순히 사진이나 글자 자체가 웃긴 게 아니다. 사진과 글이 만나 생기는 미묘한 의미 충돌에서 웃음이 나온다. 기존 AI는 사진과 글의 겉모습만 보고 판단했기 때문에 이런 깊은 의미를 제대로 파악하지 못했다.

최근 몇 년간 연구자들은 대형 AI 모델에게 “왜 이게 웃긴지 설명해봐”라고 물어보는 방식을 시도했다. AI가 자기 생각을 단계별로 설명하게 하거나, 여러 AI끼리 토론하게 만드는 방법들이 나왔다. 하지만 이 방법들의 문제는 AI가 한 번 잘못 판단하면 그걸로 끝이라는 점이다. 틀렸다는 걸 알려주고 고칠 방법이 없었다. 사람은 누군가 “그게 아니라 이런 의미야”라고 알려주면 다음부터는 비슷한 상황을 더 잘 이해하는데, 기존 AI는 그게 불가능했다.

추론·심사·조절·기억… 피드백 받고 기억하는 새로운 AI 시스템

FLoReNce는 ‘피드백을 받아 계속 개선하는 추론기’라는 뜻을 담은 이름이다. 이 시스템은 밈을 이해하는 과정을 단순한 분류 작업이 아니라, 계속 개선되는 학습 과정으로 만들었다.

FLoReNce는 네 가지 부분으로 이뤄져 있다.

첫째, ‘추론 담당 AI’가 밈을 보고 웃긴지 아닌지 판단하면서 그 이유를 설명한다.

둘째, ‘심사위원 AI’가 정답과 비교하며 추론 담당 AI의 판단을 평가하고 조언한다.

셋째, ‘조절 장치’가 얼마나 틀렸는지 계산해서 다음번에 어떻게 고칠지 신호를 만든다.

넷째, ‘경험 저장소’가 이런 경험들을 모두 기억해둔다.

이 네 부분이 함께 작동하면서 FLoReNce는 새로운 밈을 볼 때마다 과거의 비슷한 경험을 떠올려 더 나은 판단을 내린다. 중요한 건, AI 모델 자체를 다시 학습시키지 않는다는 점이다. 그냥 과거 경험을 참고해서 질문하는 방식만 바꾼다. 이렇게 하면 컴퓨팅 비용도 적게 들고 빠르게 적응할 수 있다

학습할 땐 피드백, 실전에선 기억 활용

FLoReNce는 두 가지 방식으로 작동한다.

학습할 때는 ‘피드백 모드’로 계속 조언을 받는다. 추론 담당 AI가 밈을 보고 판단하면, 심사위원 AI가 정답을 알려주며 뭐가 잘못됐는지 구체적으로 설명한다. 예를 들어 “이 밈은 아이러니가 포인트인데 네가 그걸 못 봤어” 같은 식이다. 이 조언은 숫자 신호로도 변환돼서, 얼마나 틀렸는지 정확히 측정된다. 그리고 이 모든 경험이 경험 저장소에 차곡차곡 쌓인다.

경험 저장소는 단순히 밈만 저장하는 게 아니다. 그 밈을 봤을 때 AI가 뭐라고 판단했는지, 심사위원이 뭐라고 지적했는지까지 함께 저장한다. 그래서 나중에 비슷한 밈을 만나면 “아, 전에 이런 비슷한 밈에서 실수했었지”라고 기억해낼 수 있다.

실전에서는 ‘기억 모드’로 작동한다. 이제 심사위원 AI는 없다. 대신 새로운 밈을 보면 경험 저장소에서 비슷한 밈들을 찾아본다. 과거에 비슷한 밈에서 어떤 실수를 했고 어떤 조언을 받았는지 확인한다. 그 기억을 바탕으로 질문 방식을 조정한다. 예를 들어 “이번엔 풍자 요소를 꼭 확인해봐”처럼 스스로에게 주의를 준다. 이렇게 과거 경험을 활용해서 정답 없이도 더 정확한 판단을 내린다.

5,000개 밈 테스트, 77% 정확도 달성

연구진은 LGBTQ+ 관련 밈 5,063개로 FLoReNce를 시험했다. 이 밈들은 2020년부터 2024년까지 페이스북, 트위터, 레딧에서 모은 것이다. 각 밈마다 사진 속 글자를 추출하고 웃긴지 아닌지 레이블을 붙였다. 전체의 85%로 학습하고, 5%로 조정하고, 10%로 최종 테스트했다.

결과는 놀라웠다. 과거 경험을 3개만 참고해도 정확도 73.73%, F1 점수 77.36%를 기록했다. F1 점수는 정확도보다 더 엄격한 평가 기준인데, 이 점수가 더 높게 나왔다는 건 어려운 케이스도 잘 맞혔다는 의미다. 특히 경험을 1개만 참고하든 10개를 참고하든 성능이 비슷했다. 이는 경험 저장소에 쌓인 피드백의 질이 좋아서 적은 경험만으로도 충분히 학습할 수 있다는 뜻이다.

기존 AI들과 비교해도 뒤지지 않았다. 사진이나 글만 보는 단순 AI는 60%대 정확도에 머물렀고, 사진과 글을 함께 보는 AI들은 70%대 초중반 정확도를 보였다. FLoReNce는 이들과 비슷하거나 약간 나은 수준이면서도, 자기 판단의 이유를 설명할 수 있고 스스로 개선할 수 있다는 장점이 있다.

맞히기도 하고 틀리기도… AI의 학습 과정

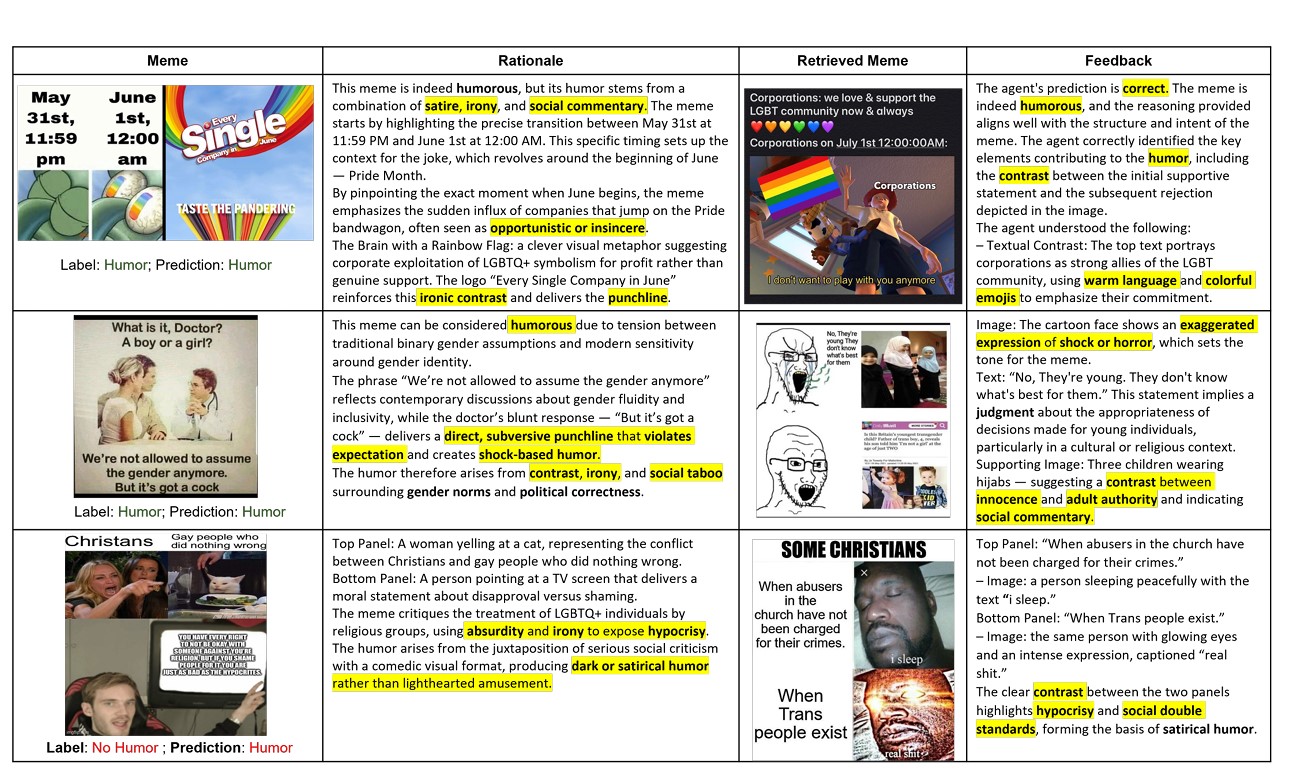

연구진은 세 가지 실제 사례를 보여줬다.

첫 번째 밈은 기업들이 성소수자 자긍심의 달에만 갑자기 관심을 보이는 걸 비꼬는 내용이다. FLoReNce는 경험 저장소에서 “기업의 위선”과 “대조” 같은 키워드가 있는 과거 피드백을 찾아내 정확히 풍자를 파악했다.

두 번째 ‘의사/성별’ 밈도 충격적인 유머와 사회적 금기를 다룬 과거 경험을 참고해서 이게 진짜 편견이 아니라 의도적인 아이러니라는 걸 알아챘다.

하지만, ‘기독교인 vs 성소수자’ 밈에서는 실수했다. 이 밈은 사실 웃긴 게 아니라 조롱하는 내용이었는데, FLoReNce는 웃긴 밈이라고 판단했다. 비슷한 종교 관련 밈들의 과거 경험에서 “부조리”와 “아이러니”를 너무 강조한 나머지, 이번 밈이 실제로는 소수자를 공격하는 내용이라는 걸 놓친 것이다. 이 사례는 권력자를 비판하는 풍자와 약자를 조롱하는 내용을 구분하는 게 얼마나 어려운지 보여준다.

연구진은 각 부분의 역할을 확인하기 위해 하나씩 빼가며 테스트했다. 기본 AI만 쓰면 성능이 중간 수준이었다. 경험 저장소만 추가해도 꽤 좋아졌고, 조절 장치만 추가해도 개선됐다. 하지만 심사위원의 구체적인 조언을 빼면 성능이 떨어졌다. 세 가지가 모두 있을 때 가장 좋은 결과가 나왔다. 이는 숫자로 계산되는 오차, 과거 경험, 구체적인 조언이 모두 필요하다는 걸 증명한다.

혐오와 유머 구분부터 여론 분석까지… 실수하고 배우는 AI 시대

FLoReNce가 중요한 이유는 단순히 밈을 분석하는 것을 넘어선다. 이 기술은 AI가 자기 판단에 대해 피드백을 받고 그걸 기억해서 다음번에 활용하는 새로운 방식을 보여준다. 기존 AI는 한 번 판단하면 끝이지만, FLoReNce는 마치 사람처럼 과거 경험을 떠올리며 판단한다. 게다가 모델을 다시 학습시키지 않아도 되니 비용도 적게 든다.

이런 기술은 소셜미디어의 콘텐츠 관리, 감정 분석, 문화 트렌드 파악 등 여러 분야에 쓰일 수 있다. 특히 혐오 표현과 유머를 구분하거나, 비판과 조롱을 가려내는 등 미묘한 차이를 포착해야 하는 곳에서 유용하다. 다만 연구진도 인정했듯이, 힘 있는 사람을 비판하는 풍자와 약한 사람을 괴롭히는 조롱을 구분하는 건 여전히 어려운 과제다.

연구진은 FLoReNce를 “비판을 받아 스스로 조절하는 AI의 기본 설계도”라고 설명했다. 이 방식은 밈 분석뿐 아니라 주관적인 판단이 필요한 다른 문제들에도 적용할 수 있다. 특히 요즘 같은 대형 AI 시대에 AI가 자기 판단을 돌아보고 개선할 수 있다는 건 AI의 신뢰성을 높이는 중요한 발전이다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. FLoReNce가 기존 AI와 다른 점은 뭔가요?

A. FLoReNce는 자기 판단이 틀렸을 때 그 이유를 배워서 다음번엔 더 잘한다는 점이 가장 큰 차이다. 기존 AI는 한 번 답을 내면 끝이지만, FLoReNce는 심사위원 역할의 AI로부터 조언을 받고 이를 경험 저장소에 기억해 뒀다가 나중에 비슷한 상황에서 활용한다. 마치 사람이 실수를 통해 배우는 것과 비슷하다.

Q2. 인터넷 밈의 유머를 AI가 이해하기 어려운 이유는 뭔가요?

A. 밈의 유머는 사진이나 글 자체보다는 둘이 만나서 생기는 의미의 충돌에서 나온다. 아이러니, 풍자, 반전 같은 복잡한 의미를 파악해야 하는데, 기존 AI는 겉모습만 보고 판단했기 때문에 이런 깊은 의미를 못 잡았다. 게다가 문화적 배경이나 사회적 맥락을 알아야 하는 경우가 많아서 더 어렵다.

Q3. 이 기술은 어디에 쓰일 수 있나요?

A. 소셜미디어에서 부적절한 콘텐츠를 걸러내는 데 가장 먼저 활용될 수 있다. 유머와 혐오 표현을 구분하거나, 비판적 풍자와 악의적 조롱을 가려내는 데 도움을 준다. 또 온라인 감정 분석, 문화 트렌드 파악, 여론 조사 등에도 쓰일 수 있다. 더 나아가 주관적 판단이 필요한 여러 AI 분야에서 모델의 추론 능력을 높이는 데 기여할 수 있다.

기사에 인용된 논문 원문은 arXiv에서 확인 가능하다.

논문명: Yes FLoReNce, I Will Do Better Next Time! Agentic Feedback Reasoning for Humorous Meme Detection

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.