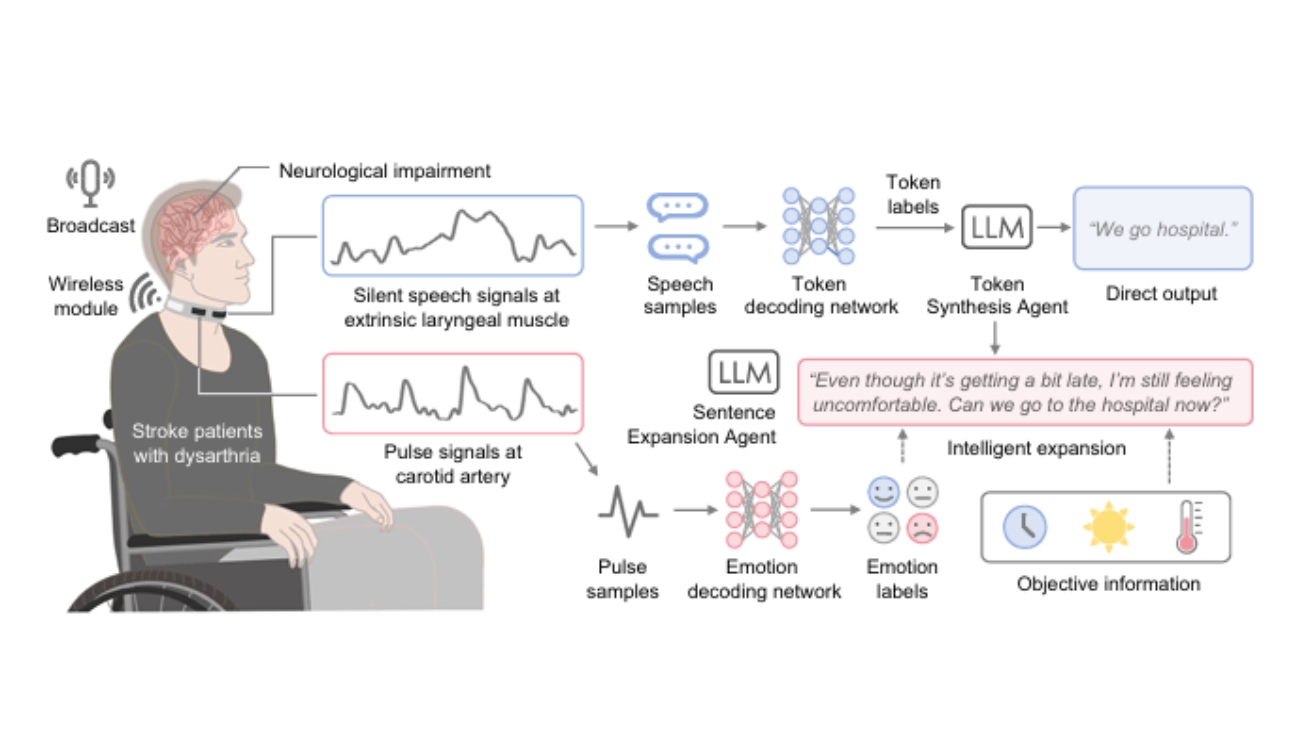

뇌졸중으로 말을 제대로 하지 못하는 환자들이 목에 착용하는 센서와 AI 기술로 다시 자연스럽게 의사소통할 수 있게 됐다. 해당 논문에 따르면, 케임브리지대학교와 중국 베이항대학교 공동 연구팀이 개발한 ‘지능형 목 장치(IT 시스템)’는 입 모양만으로도 말을 알아듣고, 심지어 감정까지 파악해 자연스러운 문장으로 만들어준다고 밝혔다. 이 획기적인 연구 결과는 세계적인 과학저널 네이처 커뮤니케이션즈(Nature Communications)에 실렸다.

목에 두르는 초민감 센서가 입 모양의 미세한 움직임 포착

IT 시스템은 목걸이처럼 목에 두르는 장치다. 이 장치에는 특수 섬유로 만든 초민감 센서가 달려 있어 사용자가 소리 내지 않고 입 모양만 만들어도 목 근육의 아주 미세한 떨림을 감지한다. 센서의 핵심 재료는 그래핀이라는 물질인데, 0.1% 수준의 작은 변형도 잡아낼 만큼 민감하다. 연구진은 센서 주변에 특수 보호층을 입혀서 두 개의 센서가 서로 간섭하지 않도록 설계했다.

이 장치는 두 가지 신호를 동시에 읽는다.

첫째는 목 근육의 진동으로 사용자가 무슨 말을 하려는지 파악한다.

둘째는 목의 경동맥 맥박으로 지금 기분이 어떤지 알아낸다. 무선 통신 장치가 내장돼 있어 배터리 한 번 충전으로 하루 종일 쓸 수 있으며, 무게도 가벼워 착용감이 편하다.

0.1초 단위로 쪼개 분석해 자연스러운 대화 가능

기존 기술은 단어 하나를 인식하는 데 1~3초씩 걸려서 사용자가 말할 때마다 멈춰야 했다. 하지만 IT 시스템은 음성 신호를 0.144초(144밀리초)라는 아주 짧은 단위로 잘게 쪼개서 분석한다. 이를 ‘토큰’이라고 부르는데, 마치 퍼즐 조각처럼 여러 토큰을 이어 붙여 완전한 단어와 문장을 만든다.

시스템은 먼저 건강한 사람 10명의 데이터로 기본 학습을 한 뒤, 실제 뇌졸중 환자 5명의 데이터로 추가 학습을 했다. 놀랍게도 환자마다 단어당 50번만 반복 연습시켰는데도 92.2%의 정확도로 말을 알아들었다. 처음부터 환자 데이터만으로 학습한 시스템보다 12% 이상 성능이 좋았다. 더 큰 AI 모델에서 지식을 옮겨오는 ‘지식 증류’라는 기법을 써서 계산량은 75% 이상 줄이면서도 정확도는 91.3%로 유지했다.

AI가 오류 고치고 감정까지 담아 완성된 문장으로 만들어

IT 시스템의 진짜 비밀은 챗GPT와 같은 대형 언어모델 AI를 활용한다는 점이다. 두 개의 똑똑한 AI가 협력해서 작동한다.

첫 번째 AI는 ‘토큰 합성 담당’으로, 센서가 잡아낸 신호를 단어로 바꾸고 문장으로 연결한다. 이때 센서가 잘못 읽은 부분이 있으면 앞뒤 문맥을 보고 자동으로 고쳐준다. 두 번째 AI는 ‘문장 확장 담당’으로, 짧고 단순한 문장을 자연스럽고 감정이 담긴 완전한 문장으로 만든다.

예를 들어 환자가 “우리 병원 가”라고만 입 모양을 만들면, 시스템은 맥박을 분석해 환자가 지금 불안해한다는 걸 알아차린다. 그리고 지금 시간, 날씨 같은 정보까지 더해서 “지금 시간이 좀 늦어지고 있는데, 여전히 불편해. 지금 병원에 갈 수 있을까?”라는 자연스러운 문장으로 바꿔준다.

맥박으로 감정을 읽는 기술도 흥미롭다. 경동맥 맥박을 5초 단위로 분석해서 ‘평온함’, ‘안도감’, ‘좌절감’ 세 가지 감정을 83.2% 정확도로 구분한다. 연구진이 여러 조건에서 실험한 결과, 첫 번째 AI는 단어 오류율 4.2%, 문장 오류율 2.9%라는 뛰어난 성적을 거뒀다. 두 번째 AI가 문장을 확장하자 환자 만족도가 55%나 올라갔다.

뇌졸중 환자 5명 테스트, 6개월 뒤에도 성능 유지

연구진은 평균 나이 43세의 뇌졸중 언어장애 환자 5명에게 직접 시스템을 써보게 했다. 환자들은 일상에서 자주 쓰는 중국어 단어 47개와 문장 20개를 소리 없이 입 모양만 만들어 표현했다.

각 단어를 50번씩만 연습했는데도 시스템이 92.2% 정확도로 알아들었다. 환자가 말을 마치면 약 1초 만에 완성된 문장이 음성으로 나와서 실제 대화처럼 자연스러웠다. 발음이 비슷해서 헷갈리기 쉬운 단어들(예: ‘book’과 ‘look’, ‘dessert’와 ‘desert’)도 96.3% 정확도로 구별했고, 틀릴 확률은 8%도 안 됐다.

환자들은 착용감, 무게, 재질 등에 대해 5점 만점에 평균 4점을 줬다. 6개월 뒤 다시 검사했을 때는 신경과 근육 상태가 변해서 정확도가 조금 떨어졌지만, 단어당 5번만 다시 연습시키자 원래 성능으로 돌아왔다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. 어떻게 소리 없이 말하는 것을 알아듣나요?

A. 목에 착용하는 센서가 입 모양을 만들 때 목 근육이 미세하게 떨리는 것을 감지합니다. 그래핀이라는 특수 물질로 만든 센서는 0.1% 수준의 아주 작은 움직임도 포착할 수 있어서 소리를 내지 않아도 무슨 말을 하려는지 정확히 알아냅니다.

Q2. AI는 이 시스템에서 어떤 일을 하나요?

A. 두 개의 AI가 협력합니다. 첫 번째 AI는 센서가 읽은 신호를 단어로 바꾸고 잘못 읽은 부분을 고칩니다. 두 번째 AI는 맥박에서 읽은 감정 정보와 시간, 날씨 같은 상황을 고려해 짧은 표현을 자연스럽고 감정이 담긴 완전한 문장으로 만들어줍니다.

Q3. 일반 사람들도 살 수 있는 제품이 나오나요?

A. 아직은 연구 단계지만 상용화를 목표로 개발 중입니다. 앞으로 더 가볍고 편한 재질로 만들고, 여러 언어를 지원하며, 크기를 줄여서 일상생활에서 편하게 쓸 수 있는 제품으로 발전시킬 계획입니다.

기사에 인용된 리포트 원문은 Nature Communications에서 확인 가능하다.

리포트명: Wearable intelligent throat enables natural speech in stroke patients with dysarthria

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.

![[AI 시네마 설명회] 제 8화 한국 AI 시네마를 위한 제언](https://aimatters.co.kr/wp-content/uploads/2026/01/AI-매터스-기사-썸네일-prom.jpg)