레이밴 메타 스마트 글래스(Ray-Ban Meta Glasses)로 촬영한 수십 시간 분량의 영상 속에서 “지난주 쇼핑하러 갈 때 택시에서 옆자리에 앉았던 사람이 누구였지?”라는 질문에 정확히 답할 수 있는 AI가 등장했다. 해당 논문에 따르면, 메타의 연구팀과 위스콘신 대학교가 공동 개발한 ‘EGAgent’는 최대 일주일 분량의 긴 영상을 분석해서 복잡한 질문에 답할 수 있다고 밝혔다. 스마트 글래스를 통한 진정한 AI 비서 시대가 열릴 것으로 기대를 모으고 있다.

50시간 영상도 척척… 기존 AI가 못하던 일을 해냈다

레이밴 메타 글래스, 아마존 에코 프레임(Amazon Echo Frames), 스냅챗 스펙터클(Snapchat Spectacles) 같은 안경형 기기들이 속속 나오면서, AI 비서가 우리 일상을 계속 관찰하고 기록하는 시대가 열리고 있다. 하지만 지금까지의 AI는 몇 분에서 길어야 한 시간 정도의 영상만 이해할 수 있었다. 일주일이나 한 달 같은 긴 기간의 영상을 이해하는 건 불가능했다. 메타 연구팀이 만든 EGAgent는 이런 문제를 해결하기 위해 개발됐으며, 최대 50시간에 달하는 1인칭 시점의 연속 영상을 분석할 수 있다.

기존의 AI 시스템들은 한 번에 처리할 수 있는 정보량이 제한되어 있어서 긴 영상을 다루기 어려웠다. 또한 여러 날에 걸쳐 일어난 일들을 연결해서 이해하는 복잡한 추론도 힘들었다. 예를 들어 “이번 주에 내가 특정 친구와 몇 번이나 만났는지” 또는 “특정 카페에서 반복적으로 마주친 사람이 누구인지” 같은 질문에는 기존 시스템이 제대로 답하지 못했다. EGAgent는 이런 한계를 극복하기 위해 ‘관계 지도’라는 새로운 방식을 도입했다.

사람·물건·장소의 관계를 지도로… 시간까지 기록한다

EGAgent의 핵심 기술은 ‘관계 지도’다. 이 지도는 영상 속에 나오는 사람, 물건, 장소를 점으로 표시하고, 이들 사이의 관계를 선으로 연결한다. 관계는 “대화했다”, “함께 활동했다”, “언급했다”, “사용했다” 등 네 가지로 분류된다. 더 중요한 건 각 관계마다 언제 시작했고 언제 끝났는지 시간 정보가 함께 기록된다는 점이다. 예를 들어 “슈어가 앨리스와 오후 3시 50분 21초부터 22초까지 대화했다”는 식으로 정확한 시간과 함께 관계가 저장된다.

이런 관계 지도는 영상의 음성을 글로 바꾼 내용과 장면 설명을 합쳐서 자동으로 만들어진다. 시스템은 먼저 30초마다 영상을 끊어서 장면을 설명하고, 이걸 음성 내용과 합친 뒤, AI를 활용해서 사람과 물건, 그리고 이들의 관계를 뽑아낸다. 뽑아낸 정보는 데이터베이스에 저장돼서 나중에 빠르게 검색할 수 있다. 연구팀이 일주일간의 실험 데이터에서 만든 지도에는 총 13,968개의 관계가 담겨 있으며, 대부분은 사람과 사람, 또는 사람과 물건 간의 상호작용이었다.

계획하고 찾고 분석하는 AI… 여러 단계로 답을 찾는다

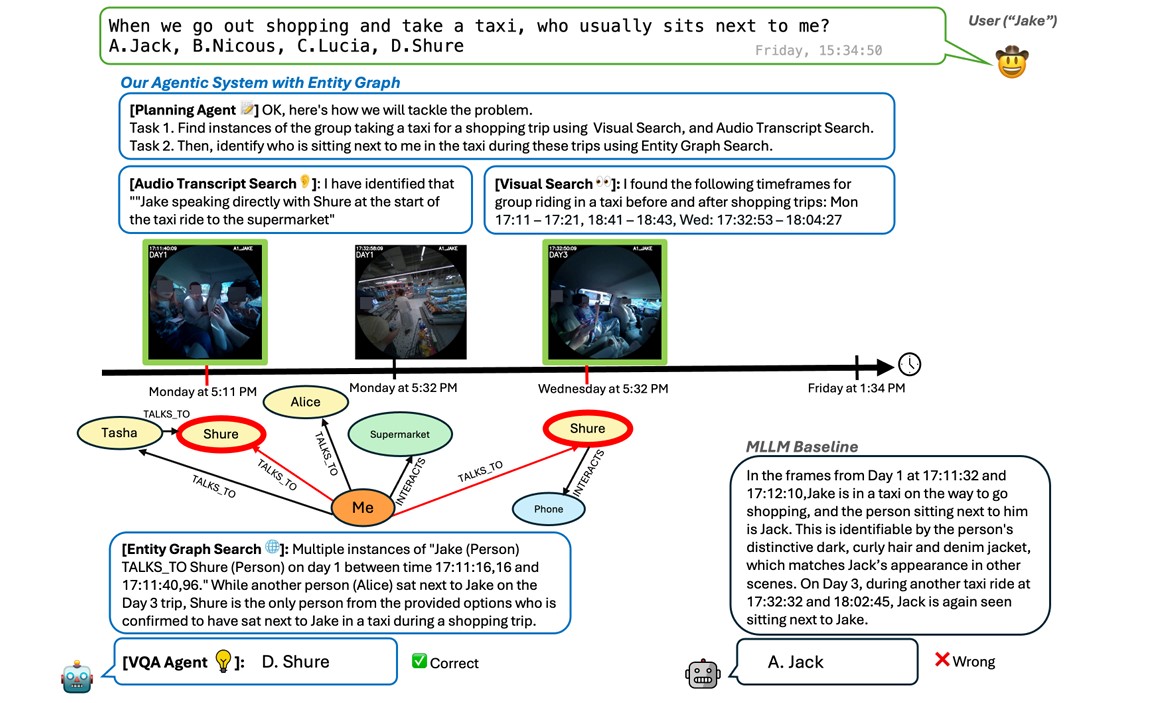

EGAgent는 단순히 관계 지도만 만드는 게 아니라, 이걸 활용해서 질문에 답하는 시스템을 구현했다. 시스템은 여러 부분으로 나뉘어 있다. 먼저 ‘계획 AI’가 복잡한 질문을 여러 개의 작은 작업으로 쪼갠다. 그 다음 세 가지 검색 도구가 각각 다른 곳에서 정보를 찾는다. 그리고 ‘분석 도구’가 찾은 정보가 질문과 관련 있는지 판단한다. 마지막으로 ‘답변 AI’가 모든 정보를 종합해서 최종 답을 만든다.

세 가지 검색 도구는 각각 다른 데이터를 뒤진다. ‘영상 검색 도구’는 초당 1장씩 뽑아낸 영상 장면들을 저장해뒀다가, 질문과 관련된 장면을 찾는다. ‘음성 검색 도구’는 영상에서 사람들이 한 말을 글로 바꾼 내용을 검색한다. ‘관계 지도 검색 도구’는 앞서 만든 관계 지도를 뒤져서 시간, 사람 이름, 관계 종류 등을 조합해서 관련된 관계를 찾아낸다.

특히 관계 지도 검색은 똑똑한 방식을 쓴다. 처음엔 정확한 날짜, 시간대, 사람 이름, 관계 종류를 모두 만족하는 조건으로 검색한다. 만약 아무것도 안 나오면 점점 조건을 느슨하게 한다. 예를 들어 시간 범위를 넓히거나, 사람 이름을 비슷한 것도 찾도록 바꾸거나, 관계 종류 조건을 빼는 식이다. 이렇게 각 검색 도구가 가져온 정보는 분석을 거쳐서 ‘작업 메모리’에 쌓인다. 모든 작은 작업이 끝나면 답변 AI가 쌓인 증거를 바탕으로 최종 답을 만든다.

실험 결과 57.5% 정확도… 관계 이해 능력 크게 향상

연구팀은 EGAgent를 두 가지 평가 기준으로 테스트했다. ‘EgoLifeQA’는 여섯 명이 일주일 동안 함께 생활하며 특수 안경으로 촬영한 50시간 분량의 1인칭 영상에서 뽑은 500개의 객관식 문제다. 문제는 물건 찾기, 과거 일 기억하기, 습관 파악하기, 사람 관계 분석하기 등 실생활에 도움이 되는 내용들이다.

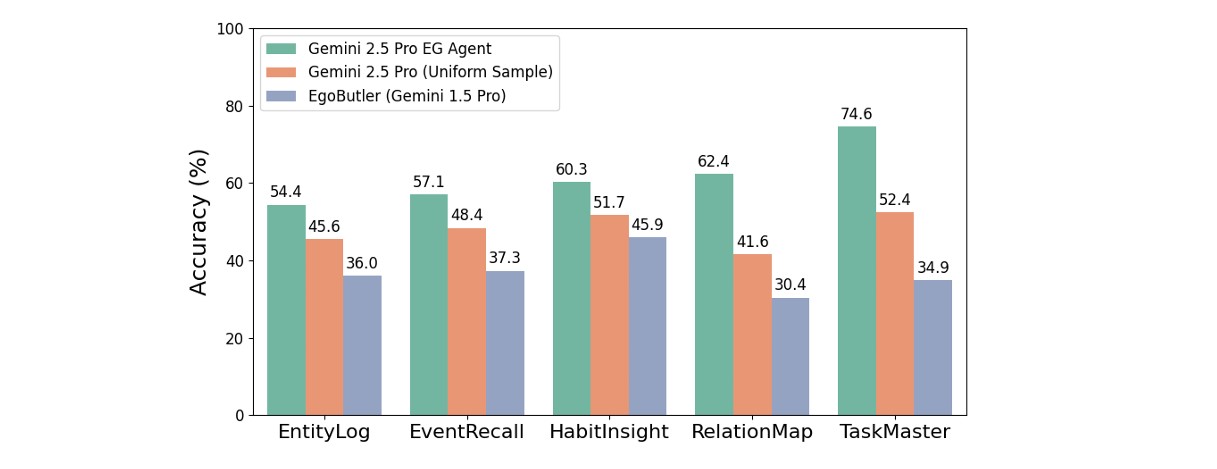

실험 결과 EGAgent는 EgoLifeQA에서 57.5%의 정확도를 기록했다. 이는 이전 최고 기록보다 20.6%포인트 높은 수치다. 특히 사람 간 관계를 파악해야 하는 ‘RelationMap’ 항목에서는 62.4%의 정확도로 이전 최고보다 32%포인트나 올랐다. 구글의 AI인 제미나이 2.5 프로와 비교해도 20.8%포인트 높았다. 또한 복잡한 작업 추론이 필요한 ‘TaskMaster’ 항목에서는 74.6%로 이전 최고보다 39.7%포인트, 제미나이 2.5 프로보다 22.2%포인트 향상됐다.

연구팀은 각 검색 도구가 얼마나 중요한지 알아보기 위해 여러 조합을 실험했다. 영상 검색만 썼을 땐 RelationMap에서 28%의 낮은 점수를 받았지만, 음성 검색을 추가하니 40%로 올랐다. 관계 지도 검색까지 모두 결합하자 53.6%로 최고 성능을 달성했다. 이는 여러 정보원을 함께 활용하는 게 긴 영상 이해에 꼭 필요하다는 걸 보여준다.

스마트 글래스 AI 비서의 실용화… 하지만 과제도 있다

EGAgent의 등장은 스마트 글래스를 활용한 AI 비서가 현실에 한 걸음 더 다가왔다는 의미다. 기존 시스템들이 짧은 영상 조각이나 독립적인 사건만 처리할 수 있었던 반면, EGAgent는 일주일 이상의 연속적인 경험을 이해하고 기억할 수 있다. 이는 사용자의 일상을 계속 관찰하며 상황을 파악하는 진짜 “항상 켜진” AI 비서를 만들 수 있다는 가능성을 보여준다.

하지만 연구팀도 인정하듯 아직 풀어야 할 숙제가 있다. 관계 지도를 만드는 과정에서 AI가 실수할 수 있고, 특히 누가 말했는지 구분하는 게 정확하지 않으면 성능이 떨어진다. 또한 EGAgent는 평균적으로 하나의 질문에 답하는 데 2-3분이 걸려서 즉시 답을 얻기는 어렵다. 연구팀은 음성 검색 방식을 바꾸면 처리 속도를 3.6배 높일 수 있지만 정확도가 6.8%포인트 떨어진다고 밝혔다.

연구팀은 완벽한 시스템을 가정한 실험을 통해 개선 여지를 확인했다. 정답 시간대를 미리 알고 있는 완벽한 검색을 쓰면 정확도가 68.7%까지 올라갈 수 있어, 영상에서 정확한 시점을 찾는 기술이 성능 향상의 핵심임을 보여줬다. 특히 영상 검색 도구는 10초 단위에서도 85.7%의 높은 정확도를 보여 우수한 시간 파악 능력을 입증했다.

개인정보 보호와 AI 윤리의 새로운 과제

EGAgent 같은 긴 영상 이해 AI의 발전은 개인정보 보호와 데이터 보안에 새로운 문제를 던진다. 일주일 분량의 1인칭 영상은 사용자의 일상, 인간관계, 방문 장소, 습관 등 매우 민감한 정보를 담고 있다. 연구팀이 쓴 실험 데이터는 얼굴과 개인 식별 정보를 자동으로 흐리게 처리하고 민감한 음성 내용을 제거했지만, 실제 서비스에서는 훨씬 강력한 개인정보 보호 장치가 필요할 것이다.

특히 관계 지도는 사람들 간 관계망을 구조화해서 저장하기 때문에, 누가 누구와 언제 어디서 만났는지, 무엇을 했는지 등의 정보가 데이터베이스에 영구적으로 기록된다. 이런 데이터가 밖으로 새어 나가거나 나쁜 목적으로 쓰일 경우 심각한 개인정보 침해로 이어질 수 있다. 따라서 앞으로 스마트 글래스 AI 비서가 실제 제품으로 나오려면 기기 안에서만 처리하기, 데이터 암호화, 사용자가 직접 데이터를 삭제할 수 있는 기능 등이 반드시 들어가야 한다.

또한 AI가 사용자의 일상을 “기억”하고 “이해”하는 수준이 높아질수록, AI와 인간의 관계에 대한 철학적·윤리적 질문도 나올 것이다. AI 비서가 사용자의 습관, 취향, 인간관계를 모두 알고 있을 때, 이게 진짜 “도움”인가 아니면 지나친 “감시”인가? 연구팀이 개발한 기술은 분명 혁신적이지만, 그 활용에는 신중한 사회적 논의와 규제가 뒷받침돼야 할 것이다.

마지막으로, 이 연구는 한국의 AI 산업에도 중요한 의미가 있다. 메타는 자체 안경형 기기인 레이밴 메타 스마트 글래스를 갖고 있어서 기기와 소프트웨어를 함께 만들 수 있다는 강점이 있다. 국내 기업들도 단순히 알고리즘 개발에만 집중할 게 아니라, 안경형 기기와 AI 서비스를 연결한 종합적인 전략이 필요한 시점이다. 특히 삼성전자와 LG전자는 각각 스마트폰, AR/VR 기기 분야에서 경쟁력을 갖추고 있으므로, 이를 활용한 긴 영상 이해 AI 개발에 나설 수 있을 것이다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. EGAgent는 기존 AI와 어떻게 다른가요?

A. 기존 AI는 짧은 영상만 처리할 수 있고 몇 분에서 한 시간 정도가 한계였습니다. 반면 EGAgent는 최대 일주일(50시간) 분량의 영상을 이해할 수 있으며, 여러 날에 걸친 일들의 관계를 파악하고 복잡한 질문에 답할 수 있습니다. 특히 사람과 물건, 장소의 관계를 시간 정보와 함께 지도로 저장해서 “지난주 특정 친구와 몇 번 만났는지” 같은 질문에도 정확히 답합니다.

Q2. 스마트 글래스로 촬영한 영상의 개인정보는 안전한가요?

A. 연구팀이 쓴 데이터는 얼굴과 개인 식별 정보를 자동으로 흐리게 처리했습니다. 하지만 실제 서비스에서는 일주일치 일상 영상이 민감한 정보를 많이 담고 있으므로, 기기 내부에서만 처리하고 암호화하는 등 강력한 보안 조치가 필수입니다. 앞으로 실제 제품으로 나오려면 사용자가 직접 데이터를 관리하고 삭제할 수 있는 기능이 반드시 필요합니다.

Q3. 이 기술은 언제쯤 실제 제품에 들어갈 수 있나요?

A. 현재 EGAgent는 하나의 질문에 답하는 데 2-3분이 걸려서 즉각 답하기는 어렵습니다. 또한 누가 말했는지 구분하는 정확도나 AI의 실수 등 개선할 부분이 있습니다. 메타는 이미 레이밴 메타 스마트 글래스를 팔고 있으므로, 앞으로 몇 년 안에 간단한 버전이 들어갈 가능성은 있지만, 완전한 형태의 일주일 영상 이해 기능은 더 많은 기술 발전이 필요할 것으로 보입니다.

기사에 인용된 리포트 원문은 arXiv에서 확인 가능하다

리포트명: Agentic Very Long Video Understanding

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.