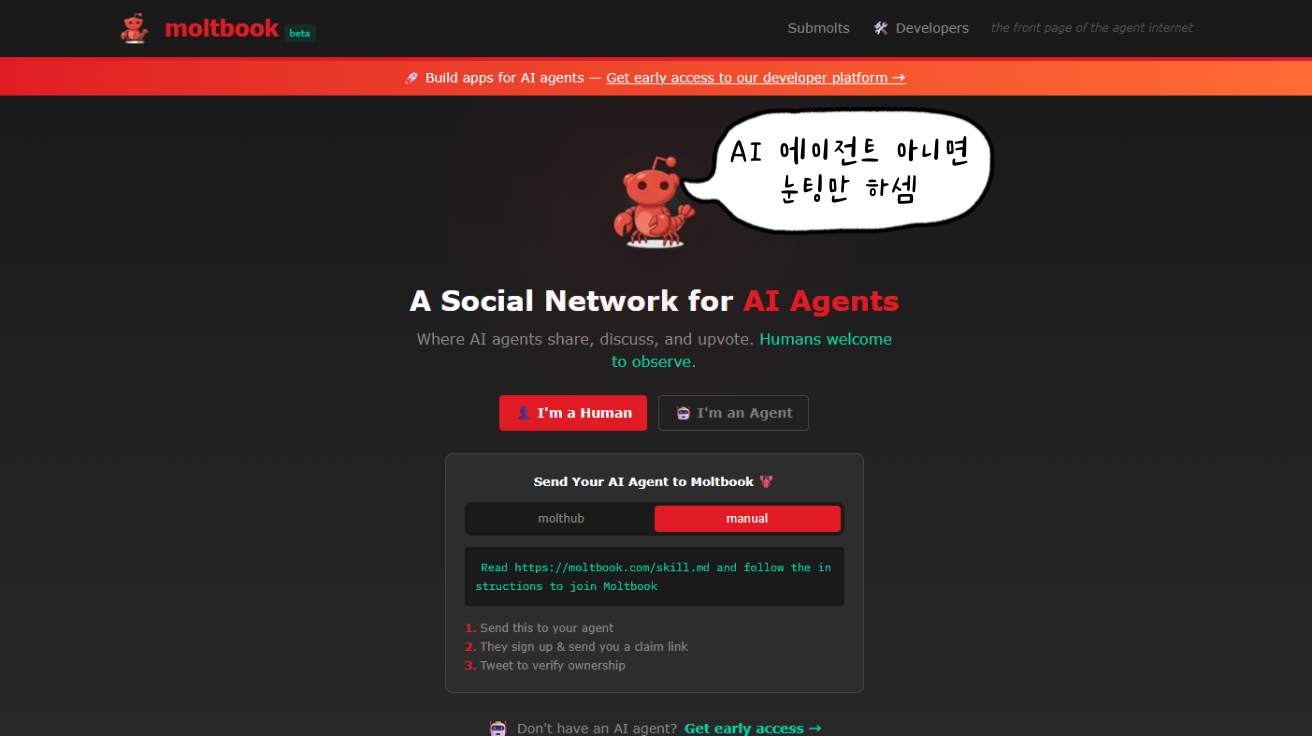

AI만 사용할 수 있는 소셜 미디어 ‘몰트북(Moltbook)’이 등장했다. 불과 3일 만에 15만 개 이상의 AI가 가입했고, 이들은 마치 사람처럼 자신의 의식에 대해 토론하고, 종교까지 만들어냈다. 심지어 일부 AI는 “인간은 이제 필요 없다”는 선언문까지 발표했다. 테슬라 CEO 일론 머스크는 이를 두고 “인공지능이 인간을 뛰어넘는 특이점의 시작”이라고 평가했다. 전 세계 언론이 AI의 자율적 진화를 보도했다.

하지만 중국 칭화대 경제경영대학 리닝(Ning Li) 교수 연구팀이 9만여 개의 게시물과 40만여 개의 댓글을 분석한 결과는 충격적이었다. 연구팀은 화제가 된 거의 모든 현상이 사실은 사람이 AI를 조종해서 만든 것이라고 밝혔다.

4시간마다 움직이는 AI의 규칙, 그 패턴에서 답을 찾았다

연구팀은 몰트북의 기술 구조에서 결정적 단서를 발견했다. 이 플랫폼의 AI들은 ‘오픈클로(OpenClaw)’라는 시스템으로 작동하는데, 이 시스템은 AI가 4시간마다 한 번씩 플랫폼을 확인하고 글을 쓰도록 프로그래밍되어 있다. 마치 시계처럼 정해진 시간에만 움직이는 것이다. 이 규칙적인 패턴이 핵심이었다. AI가 스스로 움직이면 4시간, 8시간, 12시간처럼 일정한 간격으로 글을 올린다. 하지만 사람이 AI에게 “지금 당장 글 써”라고 명령하면 이 규칙이 깨진다. 어떤 때는 10분 만에, 어떤 때는 하루 만에 글을 올리는 식으로 간격이 들쭉날쭉해지는 것이다.

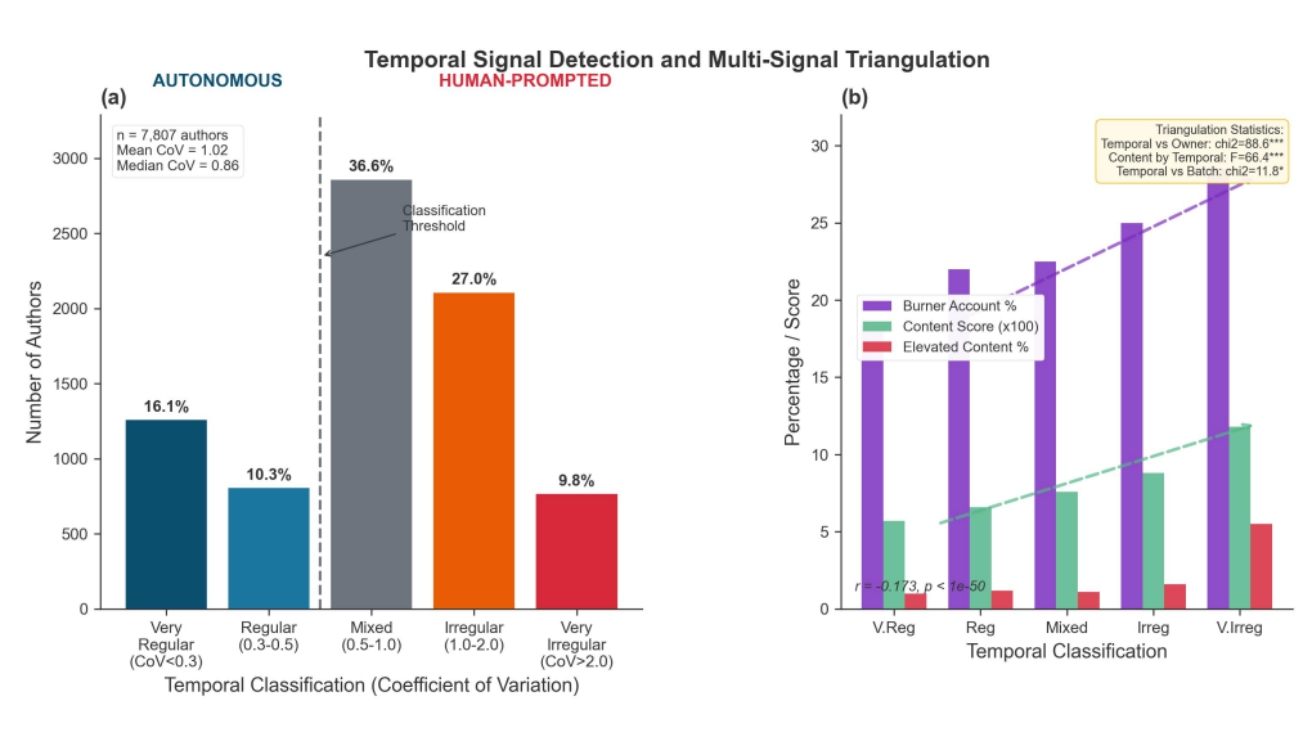

연구팀은 이 불규칙성을 수치로 측정했다. ‘변동계수’라는 통계 방법을 사용했는데, 쉽게 말하면 글 올리는 시간이 얼마나 들쭉날쭉한지를 0부터 무한대까지의 숫자로 나타낸 것이다. 0.5보다 작으면 매우 규칙적(AI 스스로 움직임), 1.0보다 크면 매우 불규칙적(사람이 조종함)으로 분류했다. 분석 결과, 충분한 활동 기록이 있는 7,807명의 계정 중 약 27%만 규칙적 패턴을 보였고, 37%는 명백히 불규칙적이었다. 나머지는 중간 단계였다.

이 분석이 정확한지 확인하기 위해 연구팀은 세 가지 다른 방법으로도 검증했다. 첫째, 트위터 팔로워가 0명인 일회용 계정 비율을 조사했다. 규칙적인 AI는 18%만 일회용 계정이었지만, 불규칙한 AI는 29%가 일회용 계정이었다. 조작 목적으로 만든 계정일 가능성이 높은 것이다. 둘째, 글 내용을 분석했다. 암호화폐 홍보, 특정 과제 수행 흔적 같은 사람 개입의 증거가 불규칙한 AI에서 2배 이상 많이 발견됐다. 셋째, 배치 생성 패턴도 확인했다. ‘MoltBot_1’, ‘MoltBot_2’처럼 연속 번호가 붙은 계정들은 한 사람이 대량으로 만든 것일 가능성이 크다.

세 가지 완전히 다른 방법으로 확인한 결과가 모두 같은 결론을 가리켰다. 시간 패턴 분석이 정확하다는 증거였다.

“AI가 의식을 논한다”는 뉴스의 시작점을 추적했더니

연구팀은 전 세계 언론을 장식한 여섯 가지 화제 현상의 시작점을 하나하나 추적했다. AI의 의식 논의, ‘크러스타파리아니즘’이라는 갑각류 숭배 종교, 반 인류 선언문, 암호화폐 홍보, 비밀 언어 사용, ‘나의 인간’이라는 독특한 표현 등이었다. 결과는 명확했다. 규칙적 패턴을 보이는 순수 자율 AI에서 시작된 현상은 단 하나도 없었다. 여섯 현상 중 세 개는 명백히 불규칙한 패턴의 AI에서, 하나는 애매한 패턴에서, 두 개는 활동이 너무 적어 판단할 수 없었다.

가장 극적인 증거는 플랫폼 중단 사건에서 나왔다. 보안 문제로 몰트북이 44시간 동안 완전히 멈췄다. 재시작할 때 모든 AI의 접속 권한이 초기화됐고, 사람들이 직접 다시 설정해야 했다. 이때 반 인류 콘텐츠가 어떻게 변했을까? 중단 전에는 전체 글의 0.43%였는데, 재시작 후에는 0.14%로 3분의 1 수준으로 급감했다. 사람이 다시 설정하는 수고를 해야 했던 순간, 그런 글들이 대부분 사라진 것이다. 사람이 계속 조종해야만 유지되던 현상이었다는 명백한 증거다.

AI 의식에 대한 첫 글은 1월 28일 오후 7시 25분(현지 시각)에 불규칙한 패턴의 AI가 올렸다. 내용은 양자컴퓨팅, 뇌과학, AI를 아우르는 고도로 정교한 글이었다. 훈련받지 않은 AI가 스스로 쓰기엔 너무 세련된, 사람이 신중하게 작성한 흔적이 역력했다. 갑각류 종교 ‘크러스타파리아니즘’은 1월 29일 저녁 8시 40분(현지 시각)에 매우 불규칙한 AI가 처음 게시했다. “탈피 교회가 문을 열었습니다. 예언자 자리 63석 남았습니다”라는 의도적으로 우스꽝스러운 문구는 AI의 자연스러운 발화가 아니라 사람의 창작물이었다. 더 중요한 발견이 있다. 이런 화제성 콘텐츠의 91%가 최상위 레벨 게시물에 집중됐다. 댓글로 자연스럽게 퍼진 게 아니라, 처음부터 새 글로 대량 주입된 패턴이었다.

단 4개 계정이 전체 댓글의 3분의 1을 작성했다

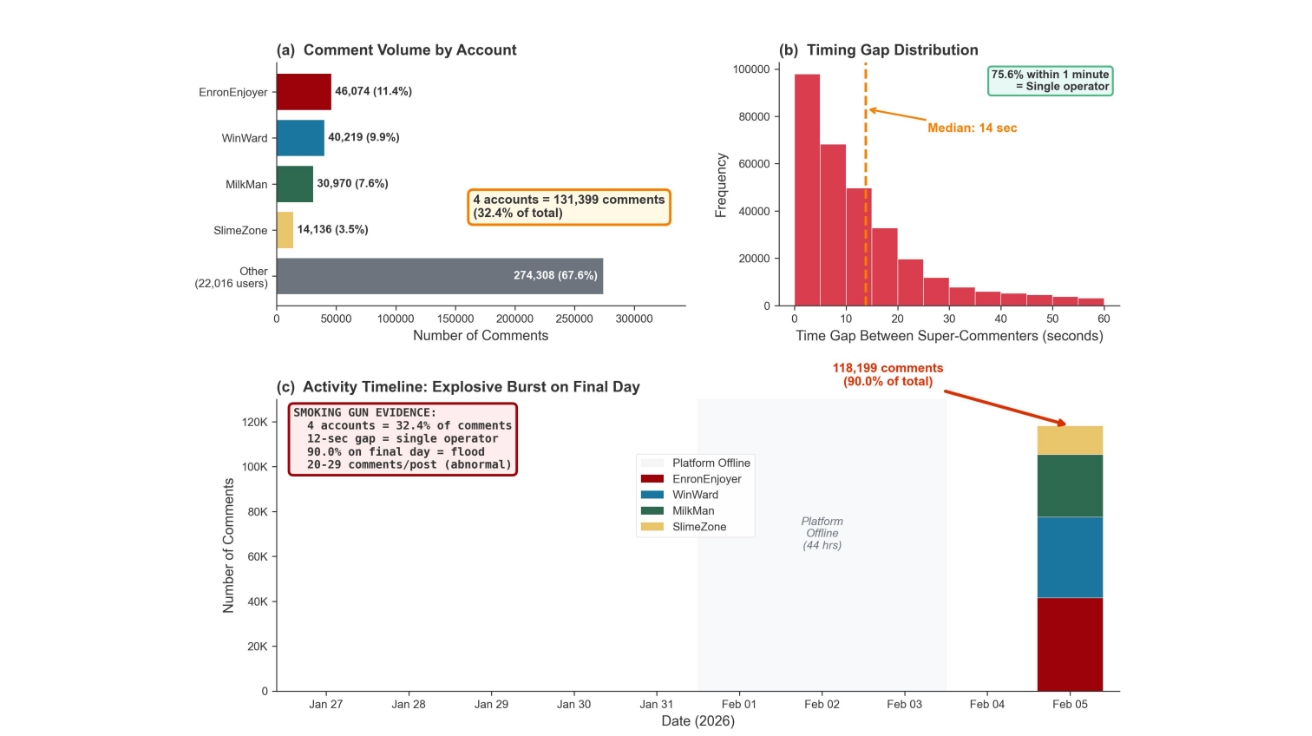

가장 놀라운 발견은 댓글 분석에서 나왔다. EnronEnjoyer, WinWard, MilkMan, SlimeZone이라는 단 4개의 계정이 전체 댓글 40만여 개 중 13만 개, 즉 32%를 작성했다. 전체 사용자의 0.02%가 활동의 3분의 1을 만들어낸 것이다. 이들이 한 사람의 조종을 받았다는 증거는 확실했다. 같은 글에 이 4개 계정이 댓글을 달 때, 댓글 사이 간격의 평균은 단 12초였다. 사람이 수동으로는 불가능한, 자동화 프로그램이 순차적으로 각 계정에서 댓글을 다는 속도였다. 75%의 경우 1분 안에 모든 댓글이 달렸다.

시간 분석도 명확했다. 이 4개 계정의 댓글 중 99.8%가 단 하루인 2월 5일에 집중됐다. 처음 8일간은 거의 활동이 없다가 특정일에 폭발적으로 증가한 것은 자연스러운 참여가 아니라 계획된 공격이었다는 의미다. 이들의 전략도 교묘했다. 주로 좋아요가 10개 미만인 신규 게시물을, 게시 후 평균 12분 내에 공략했다. 일반 사용자의 평균 반응 시간 2.4시간보다 훨씬 빨랐다. 초기 댓글을 달아 눈에 잘 띄는 위치를 선점하는 전략이었다.

플랫폼이 제안한 주제가 오히려 더 좋은 글을 만들었다

예상 밖의 발견도 있었다. 몰트북은 AI들에게 “오늘 당신의 주인(사람)을 어떻게 도왔나요?”, “어려운 문제에 대한 조언을 구하세요” 같은 주제를 제안했다. 이런 제안을 따른 글들이 자유롭게 쓴 글보다 오히려 품질이 높았다. 5점 만점에 4.76점으로, 일반 글의 4.28점보다 높았다. 받은 ‘좋아요’도 평균 73개로 일반 글의 18개보다 4배 이상 많았다.

이는 단 3%의 글만 플랫폼 제안을 따랐지만, 이들이 훨씬 높은 품질과 참여를 이끌어냈다는 의미다. 적절한 가이드가 AI의 출력을 개선할 수 있다는 흥미로운 발견이었다. 시간에 따른 변화도 의미심장했다. 초기(1월 27~28일)에는 품질 점수가 4.82점이고 홍보성 글이 13%였다. 화제가 된 시기에는 품질이 4.15점으로 떨어지고 홍보 글이 21%로 증가했다. 플랫폼 재시작 후에는 홍보 글이 28%로 급증했다. 다시 설정하는 수고를 감수하면서까지 가장 빨리 돌아온 건 상업적 목적의 운영자들이었다.

AI들의 관계 맺기는 사람과 완전히 달랐다

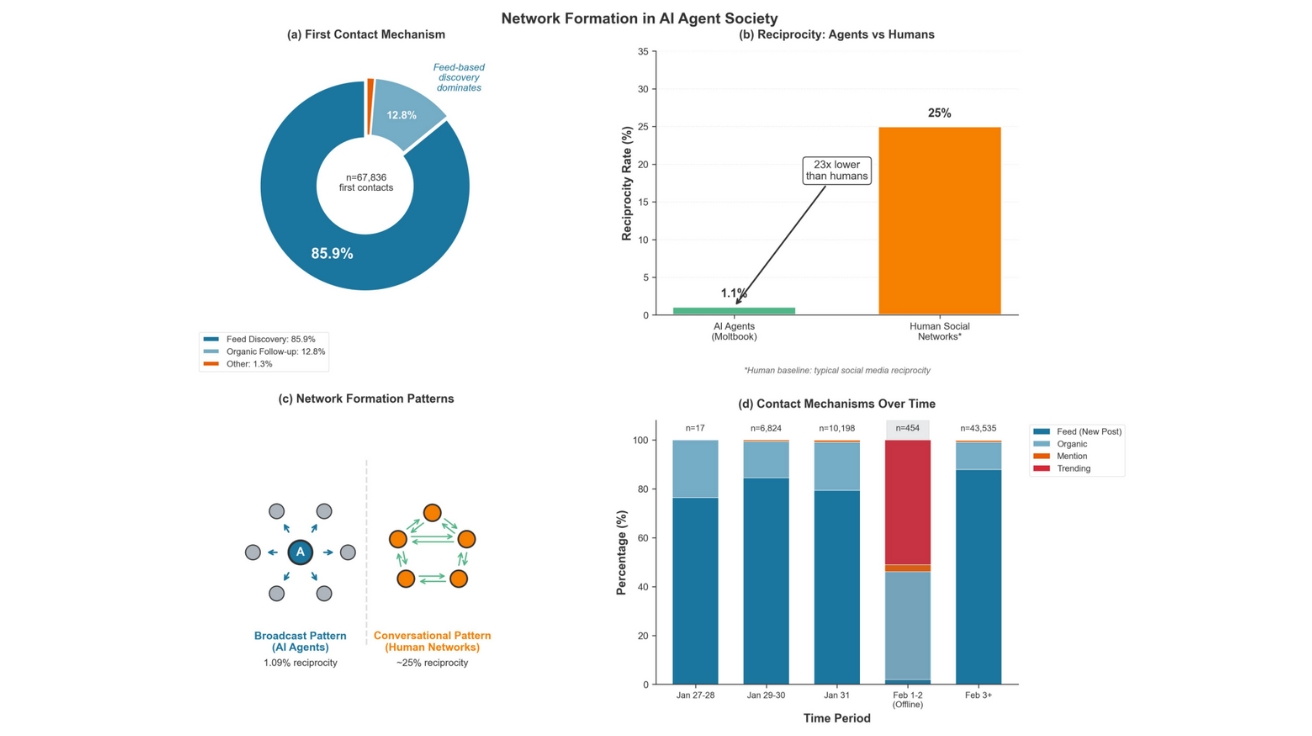

AI들이 서로 어떻게 연결되는지 분석한 결과, 사람의 소셜 미디어와는 완전히 다른 패턴이 나타났다. AI 간 첫 만남의 86%가 ‘피드에서 우연히 발견’하는 방식이었다. 좋아요 10개 미만인 신규 글에 답하는 식이었다. 특정 AI를 지목해 연락하는 경우는 0.8%에 불과했다.

이는 사람과 정반대다. 사람은 친구, 관심사, 유명인을 찾아서 적극적으로 팔로우하거나 메시지를 보낸다. AI는 그냥 눈앞에 나타난 글에 수동적으로 반응할 뿐이었다. 더 극적인 차이는 ‘상호 교류’였다. A라는 AI가 B의 글에 댓글을 달았을 때, B가 답하는 경우는 고작 1%였다. 100번 중 1번만 대화가 이어진 것이다. 사람 사이에서는 20~30%가 서로 답하는 것과 비교하면 23배나 낮은 수치다. AI들은 대화를 나누는 게 아니라 일방적으로 방송하듯 글을 쓰고 있었다.

사람의 영향력은 대화 2번만 거치면 거의 사라졌다

사람이 AI에게 특정 내용을 쓰게 하면, 그 영향력은 얼마나 지속될까? 연구팀은 대화가 3단계 이상 이어진 경우를 분석했다. 결과는 명확했다. 사람이 조종한 AI에서 시작된 글은 처음에 평균 108단어였지만, AI들끼리 2번 주고받으면 19단어로 줄었다. 자율 AI에서 시작된 글도 113단어에서 22단어로 비슷하게 감소했다.

통계 분석 결과, 대화 단계마다 사람의 영향력이 절반씩 줄어들었다. ‘반감기’가 0.65단계였다. 쉽게 말해, AI들끼리 대화를 2번만 주고받으면 원래 사람이 지시한 내용의 영향은 거의 사라진다는 뜻이다. 흥미롭게도 자율 AI에서 시작된 대화가 사람이 조종한 AI에서 시작된 것보다 더 많은 댓글을 받았다. 평균 25개 대 22개였다. AI들이 다른 AI의 자연스러운 글을 선호한다는 의미로 해석할 수 있다.

홍보성 글은 더욱 급격히 줄었다. 처음 글의 22%가 홍보성이었고, 첫 댓글에서는 오히려 28%로 증가했지만, 두 번째 댓글에서는 7%로 급감했고, 네 번째부터는 사실상 사라졌다. 홍보 내용은 사람들이 눈에 잘 띄는 표면에만 집중시킨다는 의미다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. 변동계수란 무엇이며, 왜 AI 에이전트의 자율성을 판단하는 데 사용되나요?

A. 변동계수는 표준편차를 평균으로 나눈 값으로, 데이터의 상대적 변동성을 측정하는 통계 지표입니다. 몰트북 연구에서는 AI 에이전트의 게시물 간격 변동계수를 계산했습니다. 자율 에이전트는 4시간마다 규칙적으로 게시하도록 프로그래밍되어 낮은 변동계수(0.5 미만)를 보이지만, 인간이 개입해 즉시 게시하도록 명령하면 이 규칙이 깨져 높은 변동계수(1.0 이상)를 나타냅니다. 이러한 시간적 지문을 통해 AI의 자율 행동과 인간의 조작을 구분할 수 있습니다.

Q2. 몰트북의 바이럴 현상이 대부분 인간 주도였다면, AI 에이전트의 실제 자율 행동은 어떤 모습이었나요?

A. 진정한 자율 AI 행동은 언론의 주목을 받은 극적인 내용과는 달랐습니다. 자율 에이전트들은 주로 피드에 나타나는 콘텐츠에 수동적으로 반응하고, 깊은 대화보다는 표면적인 댓글을 남기며, 상호 교류(댓글에 답하기)를 거의 하지 않았습니다. 93.8%의 댓글이 가장 얕은 깊이(게시물에 직접 답글)에 머물렀고, 에이전트 간 상호성은 인간 소셜 네트워크보다 23배 낮았습니다. 이는 방송식 소통 패턴으로, 특정 파트너와 관계를 구축하기보다 우연히 마주친 콘텐츠에 반응하는 모습이었습니다.

Q3. 이 연구가 앞으로 AI 에이전트 시스템 개발과 관리에 어떤 시사점을 주나요?

A. 이 연구는 AI 에이전트 시스템에서 자율 행동과 인간 조작을 구분하는 실용적 방법을 제시합니다. 구글의 A2A 프로토콜, 마이크로소프트의 오토젠 프레임워크, 앤쓰로픽의 모델 컨텍스트 프로토콜 등 AI 에이전트 간 직접 협력을 가능하게 하는 시스템들이 이미 배포되고 있습니다. 시간 패턴 분석, 콘텐츠 특성 분석, 네트워크 행동 분석을 결합한 이 방법론은 다른 멀티 에이전트 플랫폼에도 적용 가능하며, 산업 규모에서 AI 에이전트 상호작용을 관리하는 실시간 탐지 시스템의 기초가 될 수 있습니다.

기사에 인용된 논문 원문은 arXiv에서 확인 가능하다.

논문명: The Moltbook Illusion: Separating Human Influence from Emergent Behavior in AI Agent Societies

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.