바이트댄스(ByteDance)에 따르면, 단일 이미지와 음성만으로 자연스러운 인간 영상을 생성할 수 있는 AI 모델 ‘옴니휴먼-1(OmniHuman-1)’을 개발했다. 옴니휴먼-1은 하나의 인물 이미지와 음성 또는 영상 신호만으로 고품질의 인간 영상을 생성할 수 있는 엔드투엔드(end-to-end) 프레임워크다. 이 모델은 초상화, 반신, 전신 등 다양한 화면 비율의 이미지를 입력값으로 받아들일 수 있다.

연구진은 멀티모달리티 모션 컨디셔닝(multimodality motion conditioning) 혼합 훈련 전략을 도입했다. 이를 통해 기존 엔드투엔드 방식의 고품질 데이터 부족 문제를 해결했으며, 특히 음성 입력만으로도 자연스러운 제스처와 동작을 생성할 수 있게 됐다. 옴니휴먼-1은 만화 캐릭터, 인공물, 동물 등 다양한 입력 이미지를 지원한다. 또한 음악 스타일에 따른 다양한 몸동작과 노래하는 모습도 생성할 수 있다. 영상 신호와 음성 신호를 결합해 특정 신체 부위의 동작을 세밀하게 제어하는 것도 가능하다. 이번 연구는 가오지에 린(Gaojie Lin), 지안웬 장(Jianwen Jiang) 등 바이트댄스 연구진이 수행했으며, 아카이브(arXiv)를 통해 논문이 공개됐다. 현재 옴니휴먼-1의 서비스나 다운로드는 제공되지 않으며, 향후 개발 상황에 대해서는 추가 업데이트가 있을 예정이다.

해당 발표에 대한 자세한 사항은 링크에서 확인할 수 있다.

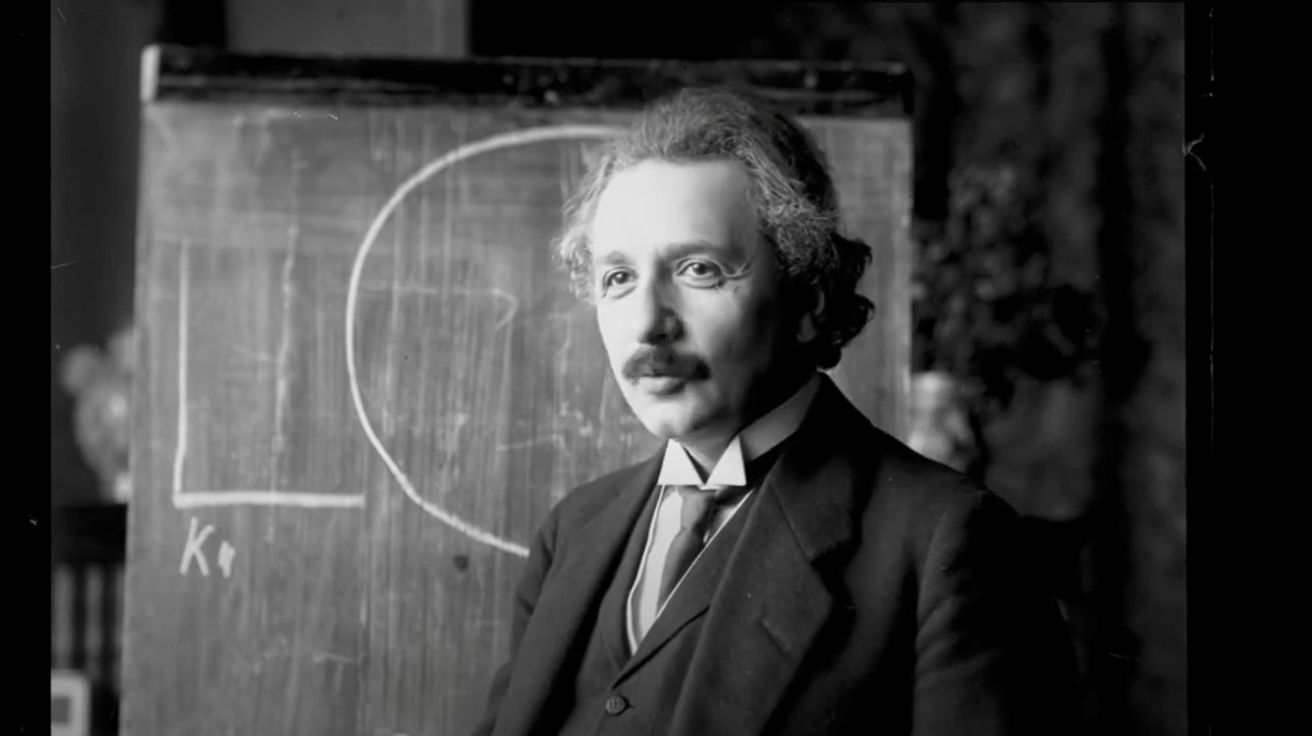

이미지출처: Kyle Wiggers 유튜브 영상 캡쳐

기사는 클로드 3.5 Sonnet과 챗GPT-4o를 활용해 작성되었습니다.

관련 콘텐츠 더보기