딥시크(DeepSeek)가 25일(현지 시간) 오픈소스 주간(#OpenSourceWeek) 둘째 날을 맞아 혼합 전문가(MoE, Mixture of Experts) 모델 훈련과 추론을 위한 최초의 오픈소스 EP 통신 라이브러리인 ‘DeepEP’를 공개했다. 딥시크의 공식 X(구 트위터) 계정에 따르면, DeepEP는 대규모 AI 모델의 효율적인 훈련과 배포를 위한 통신 인프라를 제공하는 것을 목표로 한다.

DeepEP의 주요 특징은 효율적이고 최적화된 all-to-all 통신 기능이다. 이 라이브러리는 NVLink와 RDMA를 통해 노드 내(intranode)와 노드 간(internode) 통신을 모두 지원한다. 특히 훈련과 추론 프리필링(prefilling)을 위한 고처리량 커널과 추론 디코딩을 위한 저지연 커널을 제공하여 AI 모델 개발 프로세스를 가속화한다. 또한 네이티브 FP8 디스패치를 지원하고, 계산-통신 오버래핑을 위한 유연한 GPU 리소스 제어 기능을 갖췄다.

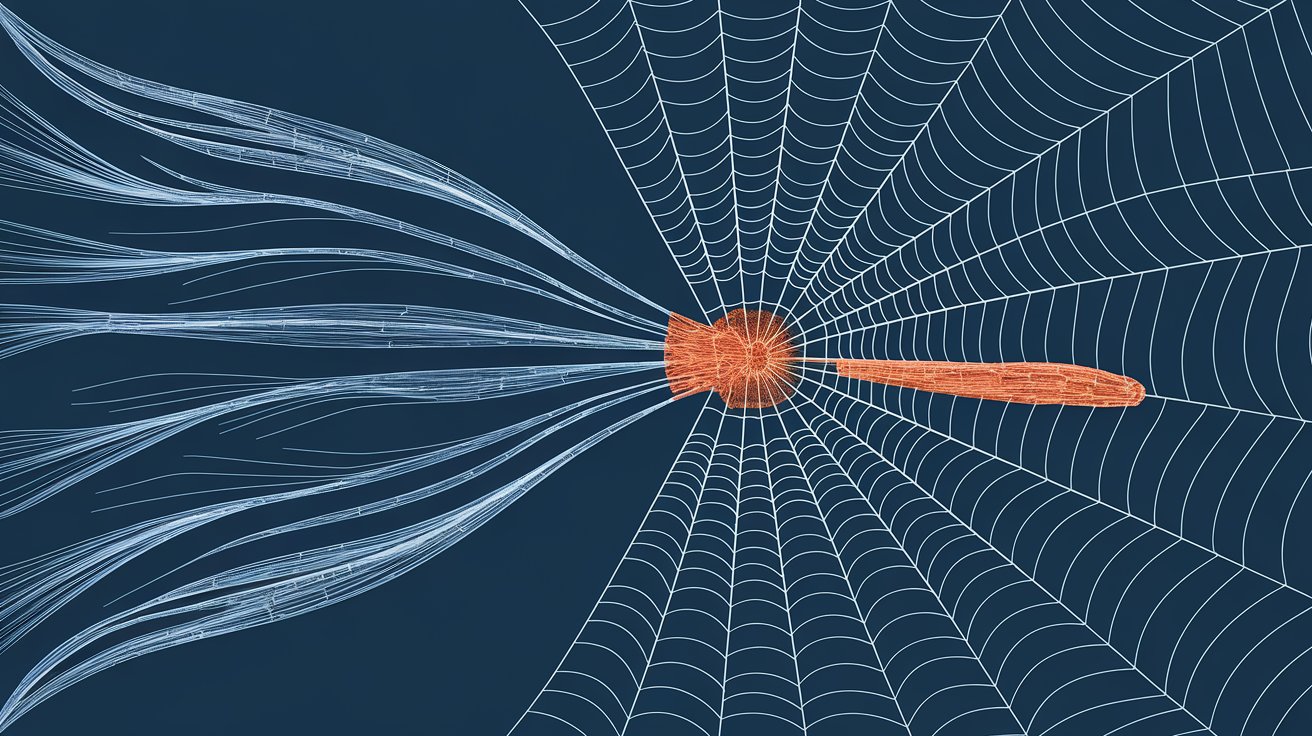

혼합 전문가(MoE) 모델은 여러 ‘전문가’ 네트워크로 구성된 AI 아키텍처로, 입력에 따라 가장 적합한 전문가를 활성화하는 방식으로 작동한다. 이러한 구조는 모델 크기를 효율적으로 확장할 수 있게 해주지만, 전문가 네트워크 간의 효율적인 통신이 중요한 과제였다. DeepEP는 이러한 문제를 해결하기 위해 설계되었으며, 특히 분산 컴퓨팅 환경에서 대규모 MoE 모델의 성능을 최적화하는 데 중점을 두고 있다.

AI 전문가들은 DeepEP가 기후 변화 예측이나 의료 진단 도구 개발과 같은 대규모 프로젝트에서 큰 역할을 할 수 있다고 보고 있다. 여러 위치에 분산된 컴퓨터들이 방대한 양의 데이터를 처리할 때, DeepEP는 이러한 컴퓨터 간의 효율적인 통신을 가능하게 한다. 한 AI 전문가는 “DeepEP는 AI ‘전문가’들이 서로 다른 컴퓨터 칩에 분산되어 있더라도 효율적으로 작업하고 통신할 수 있도록 도와주는 새로운 통신 시스템”이라고 설명했다.

딥시크는 DeepEP를 GitHub을 통해 오픈소스로 공개했다. 이를 통해 전 세계 AI 개발자들이 이 기술을 활용하고 발전시킬 수 있게 되었다. DeepEP의 등장으로 대규모 AI 모델 개발이 더욱 가속화될 전망이며, 특히 딥시크와 같은 대규모 AI 모델의 훈련과 배포에 큰 도움이 될 것으로 기대된다.

해당 기사의 원문은 링크에서 확인할 수 있다.

이미지 출처: 딥시크

기사는 클로드와 챗GPT를 활용해 작성되었습니다.

관련 콘텐츠 더보기