애플(Apple)이 9일(현지 시간) 자사 머신러닝 웹사이트를 통해 iOS, macOS 등에서 애플 인텔리전스(Apple Intelligence) 기능을 구동하는 AI 모델의 업데이트를 발표했다. 그러나 회사 자체 벤치마크에 따르면 이 모델들은 오픈AI(OpenAI) 등 경쟁 기술 회사들의 기존 모델보다 성능이 떨어지는 것으로 나타났다.

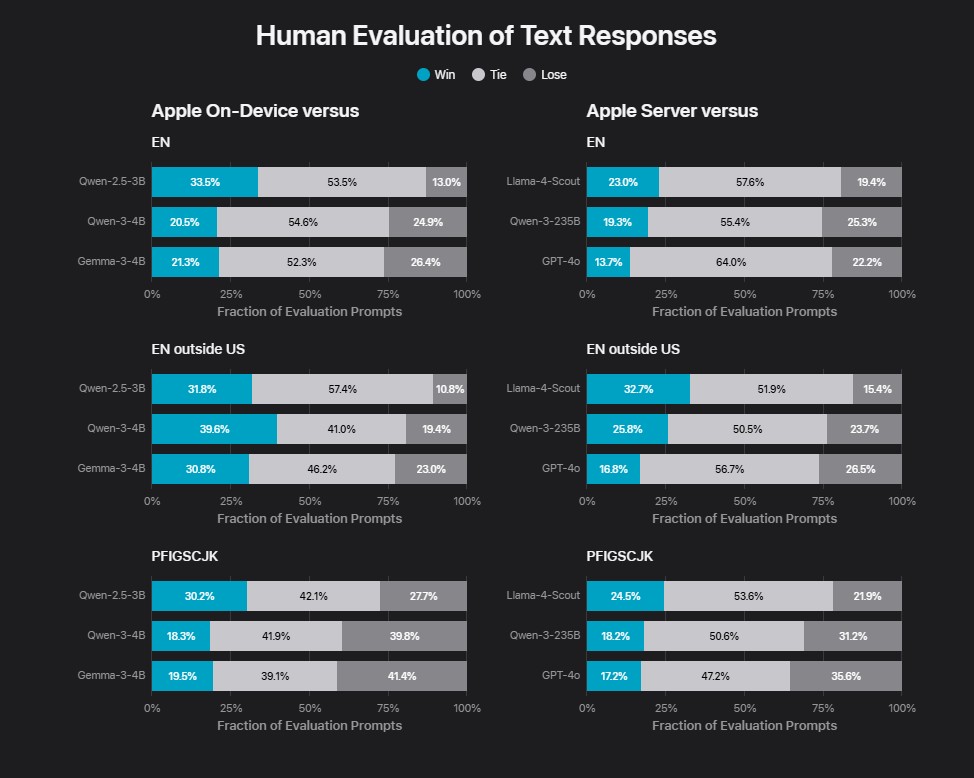

테크크런치가 10일(현지 시간) 보도한 내용에 따르면, 애플은 아이폰을 포함한 제품에서 오프라인으로 실행되는 최신 ‘애플 온디바이스(Apple On-Device)’ 모델이 생성하는 텍스트 품질을 인간 테스터들이 평가한 결과, 비슷한 크기의 구글(Google)과 알리바바(Alibaba) 모델과 ‘비교 가능한’ 수준이지만 더 나은 성능을 보이지는 못했다고 밝혔다. 한편 회사의 데이터센터에서 실행되도록 설계된 더 강력한 신규 모델인 ‘애플 서버(Apple Server)’의 경우, 동일한 테스터들이 1년 전 출시된 오픈AI의 GPT-4o보다 낮은 점수를 매겼다.

애플 모델들의 이미지 분석 능력을 평가한 별도 테스트에서는 인간 평가자들이 애플 서버보다 메타(Meta)의 라마 4 스카우트(Llama 4 Scout) 모델을 선호하는 것으로 나타났다고 애플이 발표했다. 이는 다소 놀라운 결과다. 여러 테스트에서 라마 4 스카우트는 구글, 앤트로픽(Anthropic), 오픈AI 같은 AI 연구소의 주요 모델들보다 성능이 떨어지는 것으로 평가받기 때문이다.

이번 벤치마크 결과는 치열한 AI 경쟁에서 애플의 AI 연구 부문이 경쟁사를 따라잡는 데 어려움을 겪고 있다는 보고서들에 신빙성을 더한다. 최근 몇 년간 애플의 AI 역량은 기대에 못 미쳤고, 약속했던 시리(Siri) 업그레이드는 무기한 연기됐다. 일부 고객들은 애플이 아직 제공하지 못한 AI 기능을 제품 마케팅에 활용했다며 회사를 상대로 소송을 제기하기도 했다.

텍스트 생성 외에도 약 30억 개의 매개변수 규모인 애플 온디바이스는 요약 및 텍스트 분석 같은 기능을 담당한다. 매개변수는 모델의 문제 해결 능력과 대략적으로 연관되며, 일반적으로 매개변수가 많은 모델이 적은 모델보다 더 나은 성능을 보인다. 월요일부터 서드파티 개발자들은 애플의 파운데이션 모델즈 프레임워크(Foundation Models framework)를 통해 이 모델을 활용할 수 있게 됐다.

애플은 애플 온디바이스와 애플 서버 모두 이전 버전 대비 향상된 도구 사용 능력과 효율성을 자랑하며, 약 15개 언어를 이해할 수 있다고 밝혔다. 이는 이미지 데이터, PDF, 문서, 원고, 인포그래픽, 표, 차트 등을 포함하는 확장된 훈련 데이터셋 덕분이다.

해당 기사의 원문은 테크크런치에서 확인 가능하다.

이미지 출처: 애플