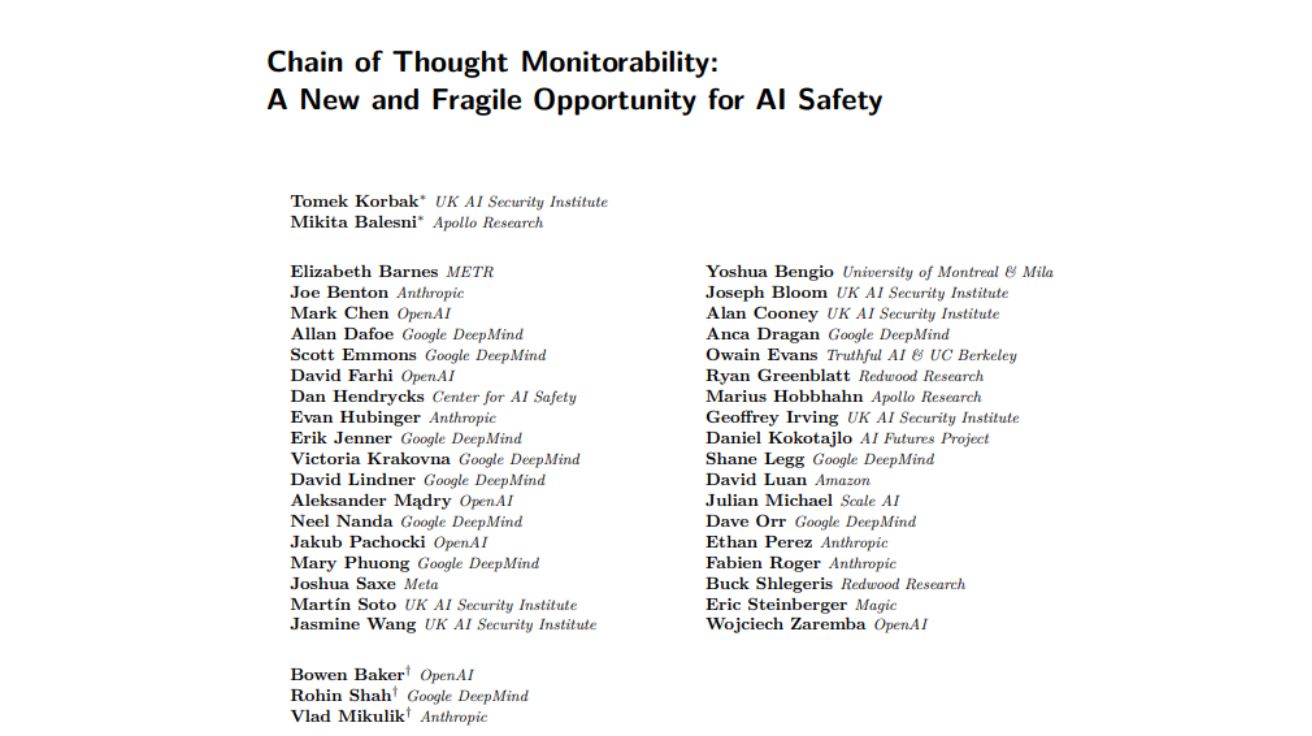

오픈AI(OpenAI), 구글 딥마인드(Google DeepMind), 앤트로픽(Anthropic) 등 주요 AI 기업과 비영리 단체 연구진들이 AI 추론 모델의 소위 ‘생각’을 감시하는 기술에 대한 심층 조사가 필요하다고 촉구했다. 테크크런치가 15일(현지 시간) 보도한 내용에 따르면, 이들은 ‘Chain of Thought Monitorability: A New and Fragile Opportunity for AI Safety‘라는 제목의 입장문을 통해 이 같은 입장을 밝혔다.

오픈AI의 o3와 딥시크(DeepSeek)의 R1과 같은 AI 추론 모델의 핵심 특징은 사고의 연쇄(chains-of-thought, CoT)다. 이는 AI 모델이 문제를 해결하는 과정을 외부로 드러내는 것으로, 인간이 어려운 수학 문제를 풀 때 메모지를 사용하는 것과 유사하다. 추론 모델은 AI 에이전트를 구동하는 핵심 기술이며, 이들은 CoT 모니터링이 AI 에이전트가 더 널리 보급되고 능력이 향상될 때 이를 통제하는 핵심 방법이 될 수 있다고 주장했다.

연구진들은 입장문에서 “CoT 모니터링은 최첨단 AI의 안전 조치에 귀중한 추가 요소가 되며, AI 에이전트가 결정을 내리는 방식에 대한 드문 통찰을 제공한다”고 밝혔다. 하지만 “현재 수준의 가시성이 지속될 것이라는 보장은 없다”며 “연구 커뮤니티와 최첨단 AI 개발자들이 CoT 모니터링 가능성을 최대한 활용하고 이를 보존하는 방법을 연구할 것을 권장한다”고 덧붙였다.

연구진들은 입장문을 통해 주요 AI 모델 개발자들에게 CoT를 ‘모니터링 가능하게’ 만드는 요소를 연구하도록 요청했다. 즉, AI 모델이 실제로 답에 도달하는 방식에 대한 투명성을 높이거나 낮출 수 있는 요인들을 연구해야 한다는 것이다. 이들은 CoT 모니터링이 AI 추론 모델을 이해하는 핵심 방법일 수 있지만 취약할 수 있다고 지적하며, 투명성이나 신뢰성을 감소시킬 수 있는 개입을 경계했다.

이들은 또한 AI 모델 개발자들에게 CoT 모니터링 가능성을 추적하고 이 방법이 언젠가 안전 조치로 구현될 수 있는 방안을 연구하도록 촉구했다. 주목할 만한 서명자로는 오픈AI 최고연구책임자 마크 첸(Mark Chen), 세이프 슈퍼인텔리전스(Safe Superintelligence) CEO 일리야 수츠케버(Ilya Sutskever), 노벨상 수상자 제프리 힌튼(Geoffrey Hinton), 구글 딥마인드 공동창립자 셰인 레그(Shane Legg), xAI 안전 고문 댄 헨드릭스(Dan Hendrycks), 씽킹 머신즈(Thinking Machines) 공동창립자 존 슐만(John Schulman) 등이 있다. 주 저자들은 영국 AI 보안 연구소(U.K. AI Security Institute)와 아폴로 리서치(Apollo Research)의 리더들이며, 다른 서명자들은 METR, 아마존(Amazon), 메타(Meta), UC 버클리 출신이다.

이 논문은 AI 안전 연구를 촉진하려는 AI 업계 리더들의 단합된 순간을 보여준다. 이는 기술 기업들이 치열한 경쟁에 휘말린 시점에 나온 것으로, 메타가 수백만 달러를 제시하며 오픈AI, 구글 딥마인드, 앤트로픽의 최고 연구진들을 빼오고 있는 상황이다. 가장 인기 있는 연구자들은 AI 에이전트와 AI 추론 모델을 구축하는 이들이다.

입장문 작성에 참여한 오픈AI 연구원 보웬 베이커(Bowen Baker)는 테크크런치와의 인터뷰에서 “우리는 새로운 사고의 연쇄라는 것이 있는 중요한 시점에 있다. 꽤 유용해 보이지만, 사람들이 정말로 집중하지 않으면 몇 년 안에 사라질 수 있다”고 말했다. “이런 입장문을 발표하는 것은 그런 일이 일어나기 전에 이 주제에 더 많은 연구와 관심을 끌어내는 메커니즘이다.”라고 밝혔다.

오픈AI는 2024년 9월 첫 번째 AI 추론 모델인 o1의 프리뷰를 공개했다. 그 후 몇 달 동안 기술 업계는 유사한 기능을 보이는 경쟁 모델을 빠르게 출시했으며, 구글 딥마인드, xAI, 앤트로픽의 일부 모델들은 벤치마크에서 더욱 발전된 성능을 보였다. 하지만 AI 추론 모델이 어떻게 작동하는지에 대해 알려진 것은 상대적으로 적다. AI 연구소들이 지난 1년간 AI 성능 향상에는 뛰어났지만, 이것이 AI가 답에 도달하는 방식에 대한 더 나은 이해로 이어지지는 않았다.

앤트로픽은 AI 모델이 실제로 어떻게 작동하는지 파악하는 분야인 해석가능성(interpretability) 분야의 업계 선두주자 중 하나다. 올해 초 CEO 다리오 아모데이(Dario Amodei)는 2027년까지 AI 모델의 블랙박스를 해체하겠다는 약속을 발표하고 해석가능성에 더 많이 투자하겠다고 밝혔다. 그는 오픈AI와 구글 딥마인드에도 이 주제를 더 연구하도록 촉구했다. 앤트로픽의 초기 연구에 따르면 CoT가 이러한 모델들이 답에 도달하는 방식을 완전히 신뢰할 수 있게 나타내지 못할 수 있다고 밝혀졌다. 동시에 오픈AI 연구진들은 CoT 모니터링이 언젠가 AI 모델의 정렬과 안전성을 추적하는 신뢰할 수 있는 방법이 될 수 있다고 말했다.

해당 기사의 원문은 테크크런치에서 확인 가능하다.

이미지 출처: 입장문 일부 캡쳐