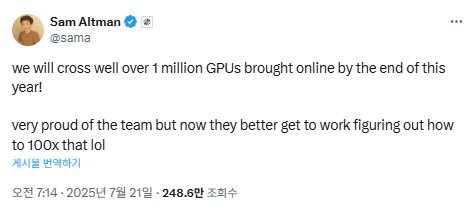

일론 머스크와 샘 알트만이 각각 자신의 AI 회사를 통해 대규모 컴퓨팅 인프라 구축 계획을 연이어 발표하며 AI 업계의 하드웨어 경쟁이 격화되고 있다. 샘 알트만 오픈AI(OpenAI) 최고경영자는 21일(현지시간) 자신의 엑스(X) 계정을 통해 “올해 말까지 100만 개를 훨씬 넘는 GPU를 온라인으로 구축할 것”이라며 “향후 이를 100배 확장하는 방법을 찾아야 한다”고 밝혔다.

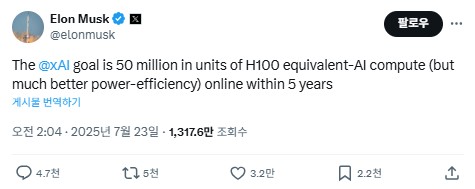

이틀 후인 23일, 일론 머스크 xAI 최고경영자도 같은 플랫폼에서 “xAI의 목표는 5년 내에 H100 상당 AI 컴퓨팅 유닛 5천만 개를 온라인으로 구축하는 것”이라고 대응했다. 머스크는 “전력 효율성이 훨씬 더 뛰어날 것”이라고 덧붙였다.

두 CEO의 발표는 각각 248만 조회수와 1천185만 조회수를 기록하며 업계의 큰 관심을 끌었다. 현재 공개적으로 알려진 최대 AI GPU 클러스터는 머스크의 xAI가 운영하는 콜로서스(Colossus)로 약 20만 개의 GPU를 보유하고 있다. 알트만의 100만 GPU 목표는 현재 최대 규모보다 5배 큰 수준이며, 향후 100배 확장 시 1억 개에 달한다. 머스크의 5천만 유닛 목표도 이에 못지않은 규모다.

업계 전문가들은 이러한 대규모 컴퓨팅 파워 확장이 AI 모델 훈련 시간을 획기적으로 단축할 것으로 예상한다고 분석했다. 한 X 사용자는 “스타게이트 텍사스가 완성되면 2023년 GPT-4 훈련에 90일이 걸렸던 작업이 약 2시간 만에 완료될 것”이라고 분석했다. 하지만 이러한 계획 실현을 위해서는 막대한 전력 공급과 냉각 시설, 그리고 기술적 혁신이 필요할 것으로 예상된다. 일부에서는 GPU 중심 접근법의 한계를 지적하며 더 나은 훈련 프로세서 개발의 필요성을 언급했다.