구글이 제미나이 3 플래시에 ‘에이전틱 비전(Agentic Vision)’이라는 새 기능을 추가했다. AI가 이미지를 보고 이해하는 능력에 프로그래밍을 결합해 훨씬 정확하게 사진을 분석할 수 있게 됐다.

구글 딥마인드의 로한 도시(Rohan Doshi) 제품 매니저는 27일(현지 시각) 구글 공식 블로그에서 “지금까지 최첨단 AI 모델들은 사진을 딱 한 번만 본다”며 “마이크로칩에 새겨진 일련번호나 멀리 있는 도로 표지판처럼 아주 작은 부분을 놓치면 그냥 추측할 수밖에 없었다”고 설명했다.

새 기능은 사진을 보는 방식 자체를 바꿨다. 한 번 보고 마는 게 아니라, 사람처럼 필요한 부분을 확대하고 자세히 들여다보며 적극적으로 조사한다. 이 기능을 켜면 대부분의 이미지 분석 성능 평가에서 5~10% 정도 점수가 올라간다고 구글은 밝혔다.

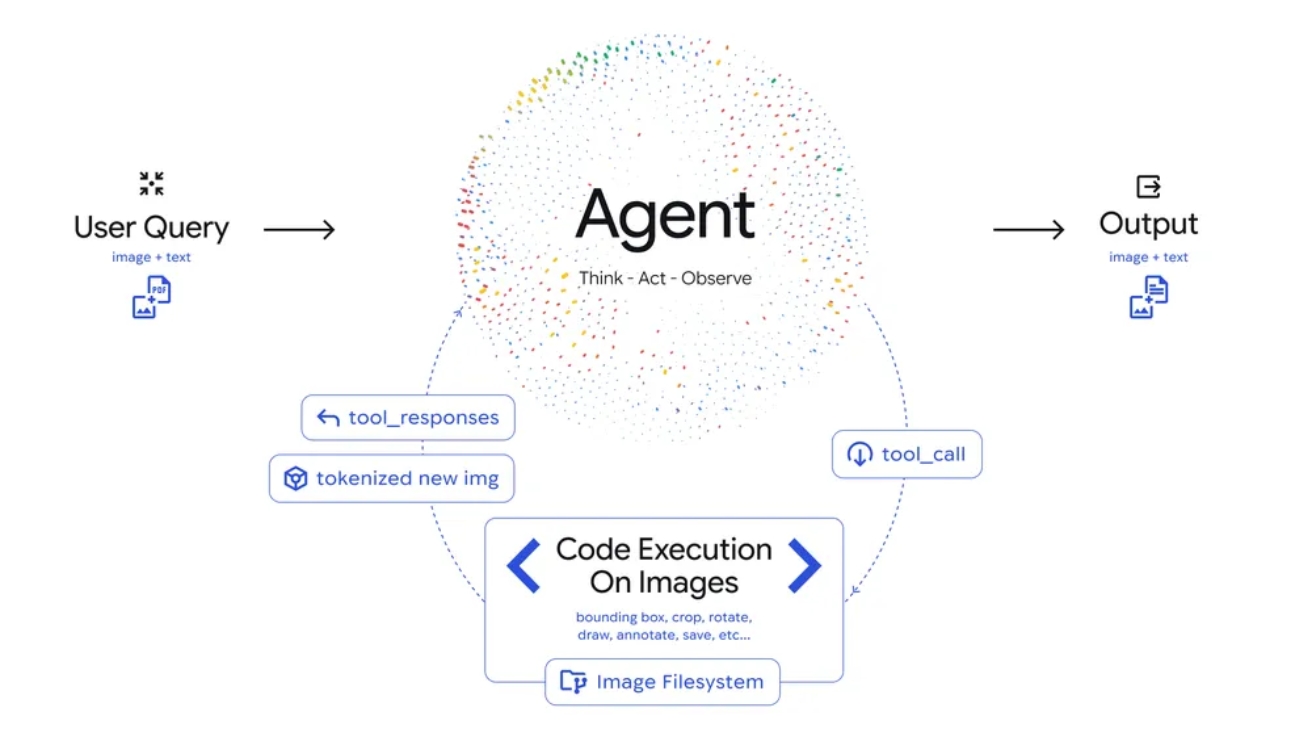

작동 원리는 ‘생각하기-행동하기-관찰하기’ 3단계로 이뤄진다. 먼저 AI가 사용자 질문과 사진을 분석해서 어떻게 답할지 계획을 세운다. 그다음 파이썬(Python) 프로그램을 스스로 만들어 실행하면서 사진을 자르거나 돌리거나 표시를 그려 넣는다. 마지막으로 새롭게 만들어진 사진을 다시 살펴보고 정확한 답변을 내놓는다.

실제 사례를 보면 효과가 확실하다. 건물 설계도를 검사해주는 플랫폼인 플랜체크솔버닷컴(PlanCheckSolver.com)은 이 기능을 사용해 정확도를 5% 높였다. AI가 스스로 프로그램을 만들어 고해상도 설계도에서 지붕 끝이나 건물 특정 부분을 잘라내 확대한 뒤, 복잡한 건축 규정을 제대로 지켰는지 꼼꼼히 확인했다.

사진에 직접 그림을 그리는 기능도 있다. 제미나이 앱에서 손가락이 몇 개인지 세달라고 하면, AI가 손가락마다 네모 상자를 그리고 번호를 매긴다. 이런 ‘메모장’ 기능 덕분에 숫자를 정확하게 셀 수 있다.

복잡한 표나 그래프를 분석할 때도 유용하다. 보통 AI 모델들은 여러 단계 계산이 필요한 작업에서 틀린 답을 만들어내곤 한다. 제미나이 3 플래시는 계산을 파이썬 프로그램에 맡겨서 이 문제를 해결한다. 구글 AI 스튜디오 데모를 보면, AI가 표에서 데이터를 찾아내고 직접 프로그램을 짜서 전문가 수준의 막대그래프까지 만든다.

구글은 앞으로 이 기능을 더 발전시킬 계획이다. 지금은 작은 글씨를 확대하는 건 AI가 알아서 하지만, 사진을 돌리거나 계산을 하려면 사용자가 구체적으로 요청해야 한다. 앞으로는 이런 것들도 AI가 스스로 판단하도록 만들 예정이다. 웹 검색이나 비슷한 이미지 찾기 같은 기능도 추가하고, 플래시 외에 다른 크기의 모델에도 적용할 계획이다.

에이전틱 비전은 현재 구글 AI 스튜디오와 버텍스 AI(Vertex AI)에서 사용할 수 있다. 제미나이 앱에서는 모델 선택 메뉴에서 ‘띵킹(Thinking)’을 고르면 된다. 개발자들은 구글 AI 스튜디오에서 직접 체험해보거나, AI 스튜디오 플레이그라운드에서 ‘도구’ 메뉴의 ‘코드 실행’을 켜서 테스트할 수 있다.

해당 서비스에 대한 자세한 사항은 구글 공식 블로그에서 확인 가능하다.

이미지 출처:구글