OmniHuman-1: Rethinking the Scaling-Up of One-Stage Conditioned Human Animation Models

기존 AI 영상 생성의 한계와 도전 과제

최근 디퓨전 트랜스포머 기반의 영상 생성 모델들이 큰 발전을 이루었지만, 인간의 자연스러운 움직임을 생성하는 데는 여전히 한계가 있었다. 특히 기존의 오디오 기반 모델들은 얼굴이나 초상화 애니메이션에만 국한되었고, 포즈 기반 모델들은 정면을 바라보는 전신 이미지와 정적인 배경에서만 작동하는 한계가 있었다.

또한 오디오는 주로 얼굴 표정과 연관되어 있고 신체 포즈, 배경 움직임, 카메라 움직임, 조명 변화와는 상관관계가 적어 원시 학습 데이터를 필터링하고 자르는 과정이 필요했다. 이로 인해 많은 양의 유용한 데이터가 버려지는 문제가 있었고, 이는 데이터셋 확장을 어렵게 만드는 주요 원인이 되었다.

1만 8천 시간 이상의 데이터로 구현한 차세대 AI 영상 생성 기술

바이트댄스(ByteDance)가 공개한 연구 논문에 따르면, 새로운 AI 모델 ‘OmniHuman’은 기존의 영상 생성 기술을 한 단계 발전시켰다. 이 기술은 한 장의 사진과 음성만으로도 자연스러운 인간의 움직임을 담은 영상을 생성할 수 있다.

특히 18,700시간 분량의 인간 관련 데이터를 학습에 활용했으며, 이 중 13%는 립싱크와 포즈 가시성 기준을 충족하는 고품질 데이터로 구성되었다. 테스트를 위해 CelebV-HQ와 RAVDESS 등 공개 데이터셋에서 무작위로 선별한 100개의 영상과 119개의 신원이 포함된 269개의 신체 영상을 활용했다.

3단계 훈련으로 완성되는 옴니-컨디션 트레이닝 전략

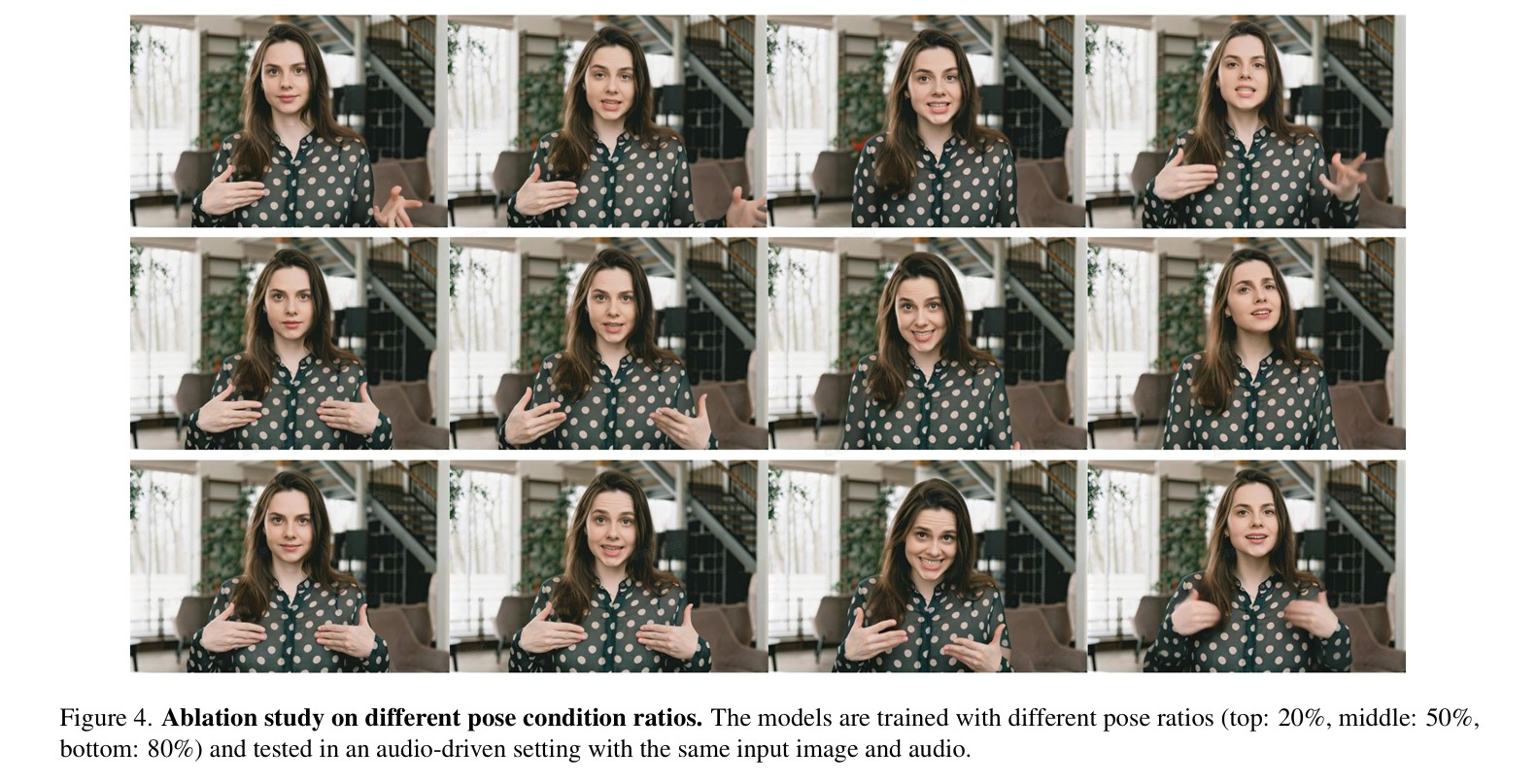

OmniHuman의 핵심은 ‘옴니-컨디션 트레이닝 전략’에 있다. 이 전략은 두 가지 주요 원칙을 따른다. 첫째, 강력한 조건부 작업은 약한 조건부 작업의 데이터를 활용할 수 있다. 둘째, 조건이 강력할수록 훈련 비율은 낮아져야 한다.

훈련은 텍스트만 사용하는 1단계, 이미지와 텍스트를 결합한 2단계, 오디오까지 추가한 3단계로 진행되며, 각 단계에서 훈련 비율을 점진적으로 조정한다. 실험 결과, 오디오 조건 50% 비율에서 최적의 성능을 보였으며, 이는 주관적 평가에서 신원 일치성 50.87%, 립싱크 정확도 53.62%, 전반적 품질 69.57%의 높은 점수로 입증되었다.

wav2vec과 DiT를 활용한 첨단 기술 구현

OmniHuman은 wav2vec 모델로 음향 특징을 추출하고, MMDiT를 통해 오디오 토큰과 잠재 표현을 상호작용시킨다. 3D 회전 위치 임베딩(RoPE)을 수정하여 참조 및 비디오 토큰을 구분하며, 분류기 프리 가이던스(CFG) 어닐링 전략으로 표현력과 계산 효율성을 최적화했다. 또한 3DVAE를 통해 원본 크기의 비디오를 잠재 공간에 투영하고, 플로우 매칭을 훈련 목표로 사용하여 비디오 디노이징 과정을 학습한다.

최신 AI 모델들과의 성능 비교에서 입증된 우수성

OmniHuman은 CelebV-HQ와 RAVDESS 데이터셋에서 영상 및 음성 합성 성능을 평가한 결과, 기존 모델 대비 우수한 성능을 기록했다. CelebV-HQ 데이터셋에서 IQA 3.875(영상 품질 평가), ASE 2.656(음성-영상 동기화 정확도), Sync-C 5.199(입술-음성 동기화), FID 31.435(영상 품질 평가), FVD 46.393(동영상 품질 평가) 등의 수치를 보였으며, RAVDESS 데이터셋에서도 IQA 4.564, ASE 2.815, Sync-C 5.255, FID 16.970, FVD 15.906으로 우수한 성능을 보였다.특히, 신체 동작 생성에서 HKV 47.561, HKC 0.898을 기록하며, 기존의 DiffTED 및 CyberHost 모델보다 향상된 결과를 달성했다.

다양한 스타일과 장면 구현이 가능한 범용성

OmniHuman은 초상화부터 전신까지 다양한 화면 비율을 지원하며, 실사 인물뿐 아니라 2D 만화 캐릭터, 조각상, 인형 등 다양한 스타일의 이미지도 자연스럽게 애니메이션화할 수 있다. 또한 악기 연주, 쇼핑, 운전 등 다양한 상황에서의 제스처와 동작을 자연스럽게 생성할 수 있어, 실제 응용 가능성이 매우 높다.

해당 기사에 인용된 논문 원문은 링크에서 확인 가능하다.

기사는 클로드 3.5 Sonnet과 챗GPT를 활용해 작성되었습니다.

관련 콘텐츠 더보기

![[Q&AI] 15억 로또 ‘올림픽파크포레온’ 청약 시작… 고려 사항은?](https://aimatters.co.kr/wp-content/uploads/2025/07/AI-Matters-기사-썸네일-QAI-4.jpg)