Are Vision-Language Models Ready for Dietary Assessment?

비공개 소스 AI 모델, 식품 인식에서 90% 이상의 정확도 달성

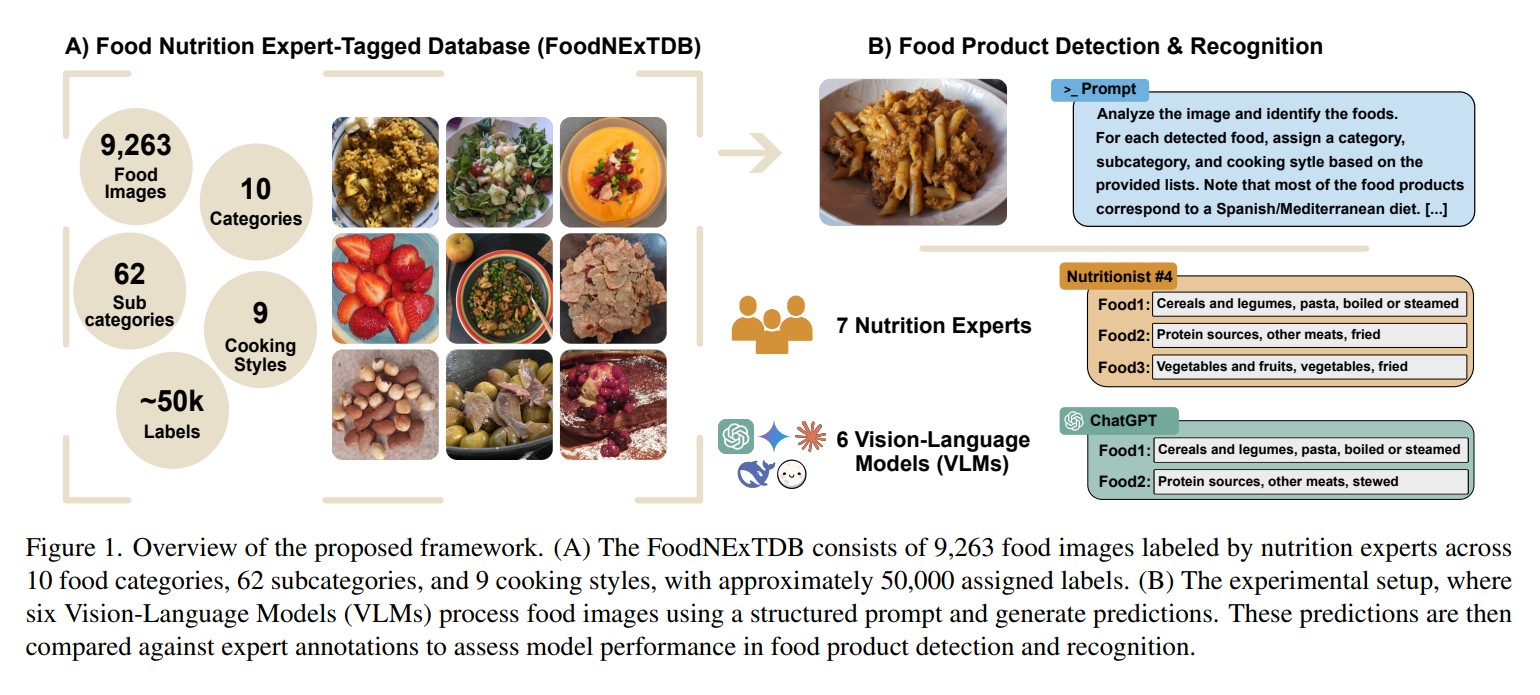

인공지능(AI) 발전으로 식품 이미지 인식 기술이 크게 향상되었다. 특히 비전-언어 모델(Vision-Language Models, VLM)이 텍스트와 이미지 데이터를 통합하여 식품 인식에 새로운 가능성을 제시하고 있다. 마드리드 자치대학교와 IMDEA 푸드 연구소 연구팀은 식품 영양 전문가 태그 데이터베이스(FoodNExTDB)를 개발하고, 비전-언어 모델 6종의 식품 인식 능력을 평가했다. 연구 결과, 비공개 소스 모델들이 공개 소스 모델보다 우수한 성능을 보였으며, 단일 제품 이미지에서는 90% 이상의 전문가 가중 회상률(Expert-Weighted Recall, EWR)을 달성했다. 그러나 현재 비전-언어 모델은 요리 스타일 구분이나 외관이 유사한 식품 간 차이 식별과 같은 세부적인 식품 인식에 여전히 어려움을 겪는 것으로 나타났다.

7명의 영양 전문가가 검증한 9,263개 이미지 – FoodNExTDB 데이터베이스의 특징

연구팀은 체중 감량 임상시험에 참여한 개인들의 실제 식이 기록에서 추출한 9,263개의 식품 이미지로 구성된 FoodNExTDB를 소개했다. 이 데이터베이스의 특징은 7명의 영양 전문가가 모든 이미지를 검토하여 약 5만 개의 라벨을 생성했다는 점이다. 각 이미지는 10개의 주요 식품 카테고리(예: “단백질 공급원”, “채소 및 과일” 등), 62개의 하위 카테고리(예: “가금류”, “과일” 등), 그리고 9개의 조리 스타일(예: “구운”, “삶은” 등)로 체계적으로 분류되었다. 이러한 구조화된 분류법은 식품 인식 모델 평가에 있어 중요한 기준을 제공한다.

각 참가자는 평균적으로 약 96개의 식품 이미지를 촬영했으며, 이미지의 약 79%는 스페인의 주요 식사 시간(아침, 점심, 저녁)에 촬영되었다. 가장 자주 할당된 식품 카테고리는 “채소 및 과일”(약 28%), “곡물 및 콩류”(약 17%), “음료”(약 16%)였다. 하위 카테고리 수준에서는 “채소”(약 13%), “과일”(약 13%), “빵”(약 8%)이 가장 많았다.

Gemini 70.16%, ChatGPT 64.32% – 비전-언어 모델 6종의 식품 인식 성능 비교

연구팀은 ChatGPT(GPT-4o), Gemini 2.0 Flash, Claude 3.5 Sonnet과 같은 비공개 소스 모델과 Moondream, DeepSeek Janus-Pro, LLaVA와 같은 공개 소스 모델을 포함한 6종의 비전-언어 모델을 평가했다. 비공개 소스 모델들은 모든 분류 수준에서 공개 소스 모델보다 일관되게 우수한 성능을 보였다. Gemini는 모든 수준에서 평균 70.16%의 EWR을 달성하여 가장 높은 성능을 보였으며, ChatGPT(64.32%)와 Claude(65.86%)도 강력한 성능을 유지했다. 분류 복잡성이 증가함에 따라 모든 모델의 성능이 저하되었다. 예를 들어, Gemini의 EWR은 카테고리 수준에서 85.79%였으나, 카테고리+하위 카테고리 수준에서는 74.69%, 카테고리+하위 카테고리+조리 스타일 수준에서는 50.00%로 감소했다.

공개 소스 모델 중에서는 Moondream이 DeepSeek과 LLaVA보다 우수한 성능(평균 54.71% 대 34.04%, 47.00%)을 보였다. DeepSeek은 식품 데이터셋에 대한 노출이 제한적이어서 가장 낮은 평균 EWR(34.04%)을 기록했다.

“튀김”과 “조림” 구분에 어려움 – 비전-언어 모델의 조리 스타일 인식 한계

연구 결과, 비전-언어 모델들은 이미지의 복잡성에 따라 성능 차이를 보였다. DeepSeek을 제외한 모든 모델은 단일 제품 이미지에서 다중 제품 이미지보다 높은 성능을 보였다. ChatGPT, Gemini, Claude, Moondream과 같은 모델들은 단일 제품 이미지에서 90% 이상의 EWR을 달성했다. 카테고리 수준에서는 “곡물 및 콩류”, “단백질 공급원”, “유제품 및 식물성 음료”와 같은 식품 카테고리 인식에 비전-언어 모델들이 우수한 성능을 보였다. 하위 카테고리 수준에서는 “과일”이 “채소”보다, “생선”이 “가금류”보다 더 정확하게 인식되었다. “파스타”도 “쌀”보다 더 자주 인식되었다.

조리 스타일 수준에서는 모든 모델이 상당한 어려움을 겪었다. “신선한” 스타일이 가장 식별하기 쉬웠고, “구운” 스타일이 그 뒤를 이었으나, “튀긴”과 “조림” 스타일은 가장 정확하게 예측되지 않았다. 이는 비전-언어 모델들이 미세한 시각적 차이를 구분하는 데 여전히 한계가 있음을 시사한다.

웨어러블 기기와 AI의 만남 – 개인화된 영양 관리의 미래 전망

식이 분석은 영양학에서 여러 관련 요소를 고려해야 하는 주요 과제로 남아있다. 순수한 이미지 인식 모델들이 식품 인식 분야에서 크게 향상되었지만, 복잡한 다중 식품 이미지를 처리하고 충분한 맥락 이해를 제공하는 데는 여전히 어려움을 겪고 있다.

비전-언어 모델은 텍스트 및 시각적 추론을 통합하여 식품 인식 및 식이 분석에서 설명 가능성을 향상시키는 유망한 대안을 제시한다. 그러나 추가적인 다중 모달 데이터 통합이 필요한 조리 스타일 식별과 같은 세부적인 작업에는 여전히 어려움을 겪고 있다.

연구팀은 개인화된 영양 전략과 비전-언어 모델을 통합하면 식이 추적과 만성 질환 예방을 개선할 수 있다고 제안한다. 웨어러블 기기, 식이 설문지, 전문가 감독에서 얻은 다중 모달 데이터와 AI 기반 식품 인식을 결합하면 자동화된 식이 평가의 정확성과 준수도를 향상시킬 수 있을 것이다.

FAQ

Q: 비전-언어 모델(VLM)이란 무엇인가요?

A: 비전-언어 모델은 이미지와 텍스트 데이터를 함께 처리할 수 있는 인공지능 모델입니다. 이 모델들은 시각적 정보와 언어적 정보를 통합하여 더 포괄적인 이해를 제공하며, 식품 인식과 같은 작업에서 기존 모델보다 더 나은 성능을 발휘할 수 있습니다.

Q: 연구에서 사용된 FoodNExTDB는 어떤 데이터베이스인가요?

A: FoodNExTDB는 9,263개의 식품 이미지로 구성된 데이터베이스로, 체중 감량 프로그램에 참여한 실제 참가자들의 식사 기록에서 수집되었습니다. 7명의 영양 전문가가 각 이미지를 검토하여 10개의 식품 카테고리, 62개의 하위 카테고리, 9개의 조리 스타일로 분류했으며, 총 5만 개 이상의 라벨을 생성했습니다.

Q: 왜 비전-언어 모델은 조리 스타일 인식에 어려움을 겪나요?

A: 조리 스타일 인식은 미세한 시각적 차이를 구분해야 하는 복잡한 작업입니다. 비전-언어 모델은 기본적인 식품 카테고리 인식에는 강하지만, “튀긴”, “구운”, “삶은” 등의 조리 방법 구분은 더 세밀한 특징을 요구합니다. 또한 이미지만으로는 조리 과정이나 사용된 소스, 기름 등을 정확히 파악하기 어렵기 때문에 이러한 세부적인 분류에 한계가 있습니다.

해당 기사에서 인용한 논문 원문은 링크에서 확인할 수 있다.

이미지 출처: 이디오그램 생성

기사는 클로드와 챗GPT를 활용해 작성되었습니다.