Real-Time Imitation of Human Head Motions, Blinks and Emotions by Nao Robot

: A Closed-Loop Approach

실시간 두뇌 모방 기술로 인간-로봇 상호작용 혁신

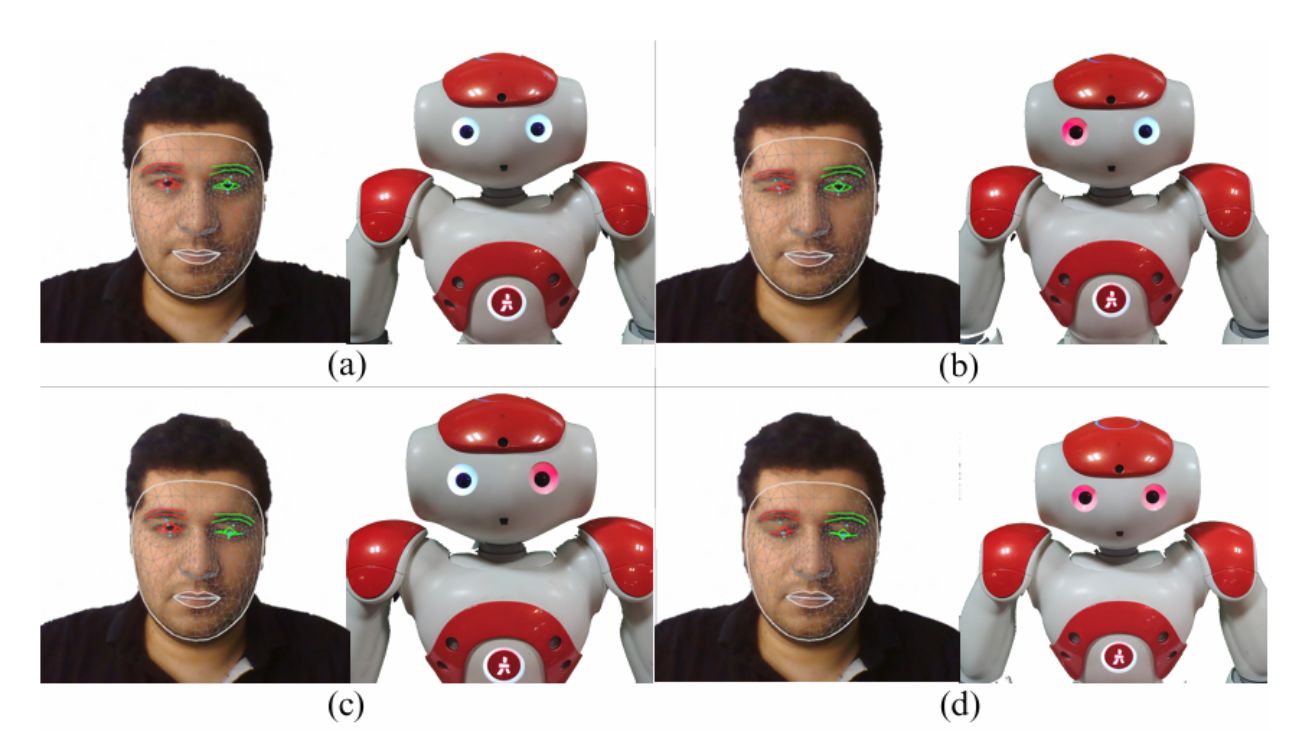

테헤란 대학교와 오클랜드 대학교의 공동 연구팀은 나오 로봇(Nao Robot)이 사람의 머리 움직임, 눈 깜빡임, 감정 표현까지 실시간으로 따라할 수 있는 획기적인 기술을 개발했다. 이 기술을 통해 로봇은 사람이 고개를 돌리거나 끄덕일 때 같은 방향으로 움직이고, 눈을 깜빡이면 함께 깜빡이며, 심지어 사람의 표정에서 감정까지 읽어내 반응할 수 있게 되었다.

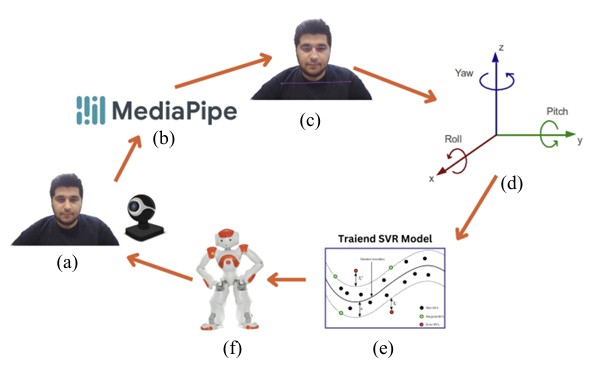

연구팀은 일반 웹캠을 통해 사람의 얼굴을 관찰하고, 여기서 얻은 정보를 로봇이 이해할 수 있는 명령으로 변환하는 시스템을 개발했다. 이 과정에서 사람의 움직임을 인식하는 미디어파이프(MediaPipe)와 감정을 인식하는 딥페이스(DeepFace) 기술이 사용되었다. 특히 중요한 점은 로봇이 동작한 후 그 결과를 다시 분석해 더 정확한 모방이 가능하도록 하는 ‘피드백 루프’ 방식을 도입한 것이다. 이러한 방식 덕분에 머리의 상하 움직임에서 96.3%, 좌우 움직임에서 98.9%라는 높은 정확도를 달성할 수 있었다.

미디어파이프와 딥페이스: 로봇이 사람을 이해하는 방법

로봇이 사람의 머리 움직임과 표정을 이해하는 과정은 크게 세 단계로 나눌 수 있다.

첫째, 웹캠으로 사람의 얼굴을 촬영한다.

둘째, 이 영상에서 필요한 정보를 추출한다.

셋째, 추출한 정보를 바탕으로 로봇에게 어떻게 움직일지 명령한다.

미디어파이프는 구글이 개발한 기술로, 웹캠 영상에서 얼굴의 중요한 지점(눈, 코, 입 등)을 찾아낸다. 연구팀은 이 지점들의 위치 변화를 계산해 사람이 고개를 어느 방향으로 얼마나 기울였는지 정확히 파악했다. 또한 눈의 위아래 점 사이 거리를 측정해 눈을 감았는지 떴는지도 감지했다. 눈 주변 점들 사이의 간격이 특정 값보다 작아지면 ‘눈을 감았다’고 판단하는 방식이다.

딥페이스는 페이스북이 개발한 기술로, 얼굴 표정에서 감정을 읽어낸다. 연구팀은 이 기술을 활용해 ‘행복’, ‘슬픔’, ‘분노’, ‘놀라움’, ‘두려움’ 등 여러 감정을 인식했다. 정확도를 높이기 위해 연속된 10개 프레임에서 감지된 감정 중 가장 많이 나타난 감정을 선택하는 방식을 사용했다.

폐쇄 루프 방식: 계속 배우며 더 정확해지는 기술

이 연구의 가장 혁신적인 부분은 ‘폐쇄 루프’ 방식을 도입한 점이다. 일반적인 모방 시스템은 사람의 동작을 한 번 인식해 로봇에게 전달하는 ‘열린 루프’ 방식인데 반해, 이 연구에서는 로봇이 움직인 후 그 결과를 다시 분석해 다음 움직임을 더 정확하게 조정하는 방식을 사용했다.

쉽게 말해, 사람이 고개를 오른쪽으로 돌리면 로봇도 오른쪽으로 고개를 돌리는데, 이때 로봇은 자신이 얼마나 정확하게 움직였는지 확인하고 필요하면 각도를 미세 조정한다. 이런 과정을 반복하면서 로봇은 점점 더 사람의 움직임을 정확하게 따라할 수 있게 된다.

실험 결과, 로봇은 사람의 머리 좌우 움직임(요 각도)을 98.9%, 상하 움직임(피치 각도)을 96.3%의 정확도로 모방했다. 또한 50번의 눈 깜빡임 중 48번을 성공적으로 감지해 96%의 정확도를 보였다. 나머지 2번은 너무 빠른 깜빡임(0.07초 미만)이어서 감지하지 못했다.

자폐 아동 교육과 치료를 위한 혁신적 응용 가능성

테헤란 대학교와 오클랜드 대학교 공동 연구팀은 이 기술이 자폐 아동의 의사소통 개선에 중요한 역할을 할 수 있다고 강조했다. 감정에 따라 실시간으로 반응하는 나오 로봇의 특성은 자폐가 있는 아이들에게 매우 가치 있는 치료 도구가 될 수 있다. 자폐 아동들은 종종 미묘한 감정 표현을 읽고 이해하는 데 어려움을 겪는데, 로봇이 이들의 감정 상태를 감지하고 그에 맞는 일관된 반응을 제공함으로써 사회적 상호작용 능력 향상에 도움을 줄 수 있다.

이 기술은 특히 “행복”, “슬픔”, “분노”, “놀라움”, “두려움”과 같은 다양한 감정을 인식하고 그에 맞는 맞춤형 응답을 제공할 수 있다. 예를 들어, 아동이 행복한 표정을 지으면 로봇은 “당신이 행복해 보여서 기쁩니다”라고 말하고, 슬픈 표정을 지으면 “기분이 나아지도록 도와드릴게요”라고 반응한다. 이러한 실시간 감정 인식과 반응은 자폐 아동의 감정 표현과 인식 능력을 발달시키는 데 효과적인 도구가 될 수 있다.

헬스케어와 교육 분야의 다양한 적용 가능성

연구팀은 이 기술이 헬스케어와 교육 분야에서 광범위하게 활용될 수 있다고 제시했다. 의료 환경에서는 환자의 표정과 감정을 모니터링하여 통증이나 불편함을 감지하는 보조 도구로 활용될 수 있다. 환자가 말로 표현하지 못하는 상태에서도 로봇이 미세한 얼굴 움직임을 감지해 의료진에게 알림으로써 더 신속한 대응이 가능해진다.

교육 분야에서는 이 기술이 학생들의 집중도와 이해도를 실시간으로 파악하는 교육 보조 도구로 활용될 수 있다. 학생이 혼란스러워하거나 지루해하는 표정을 지을 때 로봇이 이를 감지하고 교육 내용을 조정하거나 추가 설명을 제공하는 방식으로 맞춤형 학습 경험을 제공할 수 있다.

연구진은 이 기술이 엔터테인먼트, 고객 서비스, 노인 돌봄 등 다양한 분야로 확장될 수 있다고 강조했다. 특히 인간-로봇 상호작용이 중요한 서비스 분야에서 로봇이 사람의 미묘한 얼굴 표정과 감정을 이해하고 적절히 반응할 수 있게 됨으로써, 더 자연스럽고 인간적인 서비스 제공이 가능해질 전망이다.

FAQ

Q: 나오 로봇이 인간의 머리 움직임을 얼마나 정확하게 모방할 수 있나요?

A: 나오 로봇은 매우 높은 정확도로 인간의 머리 움직임을 모방할 수 있습니다. 연구 결과에 따르면 피치(상하 움직임)에서 96.3, 요(좌우 움직임)에서 98.9라는 인상적인 R2 점수를 기록했습니다. 이는 로봇의 모방이 인간의 머리 움직임을 거의 완벽하게 반영한다는 것을 의미합니다.

Q: 이 기술이 자폐 아동에게 어떤 구체적인 도움을 제공하나요?

A: 테헤란 대학교와 오클랜드 대학교 연구팀에 따르면, 이 기술은 자폐 아동이 감정을 인식하고 표현하는 능력을 향상시키는데 중요한 역할을 할 수 있습니다. 나오 로봇은 아동의 표정을 감지하고 “행복”, “슬픔”, “분노” 등의 감정에 맞춰 일관된 음성 응답을 제공합니다. 예를 들어 아동이 슬픈 표정을 지으면 “기분이 나아지도록 도와드릴게요”라고 말합니다. 이러한 실시간 상호작용은 자폐 아동의 감정 인식 훈련에 효과적이며, 안정적이고 예측 가능한 반응을 통해 사회적 상호작용 기술 발달을 돕습니다.

Q: 미디어파이프와 딥페이스는 어떤 기술인가요?

A: 미디어파이프(MediaPipe)는 구글이 개발한 컴퓨터 비전 라이브러리로, 얼굴과 신체의 랜드마크를 추적하는 데 사용됩니다. 딥페이스(DeepFace)는 페이스북의 AI 연구팀이 개발한 심층 학습 기반 얼굴 인식 시스템으로, 얼굴 이미지의 고차원 특징 벡터 표현을 생성하여 다양한 감정을 인식할 수 있습니다. 연구팀은 이 두 기술을 결합하여 로봇이 인간의 얼굴 움직임과 감정을 정확하게 감지하고 모방할 수 있는 시스템을 개발했으며, 이는 인간-로봇 상호작용을 향상시키는 데 중요한 역할을 합니다.

해당 기사에서 인용한 논문 원문은 링크에서 확인할 수 있다.

이미지 출처: 구글

기사는 클로드와 챗GPT를 활용해 작성되었습니다.