OpenVision : A Fully-Open, Cost-Effective Family of Advanced Vision Encoders

for Multimodal Learning

독점에서 개방으로: OpenVision, 25종 이상의 완전 공개형 비전 인코더로 멀티모달 AI 지형 변화

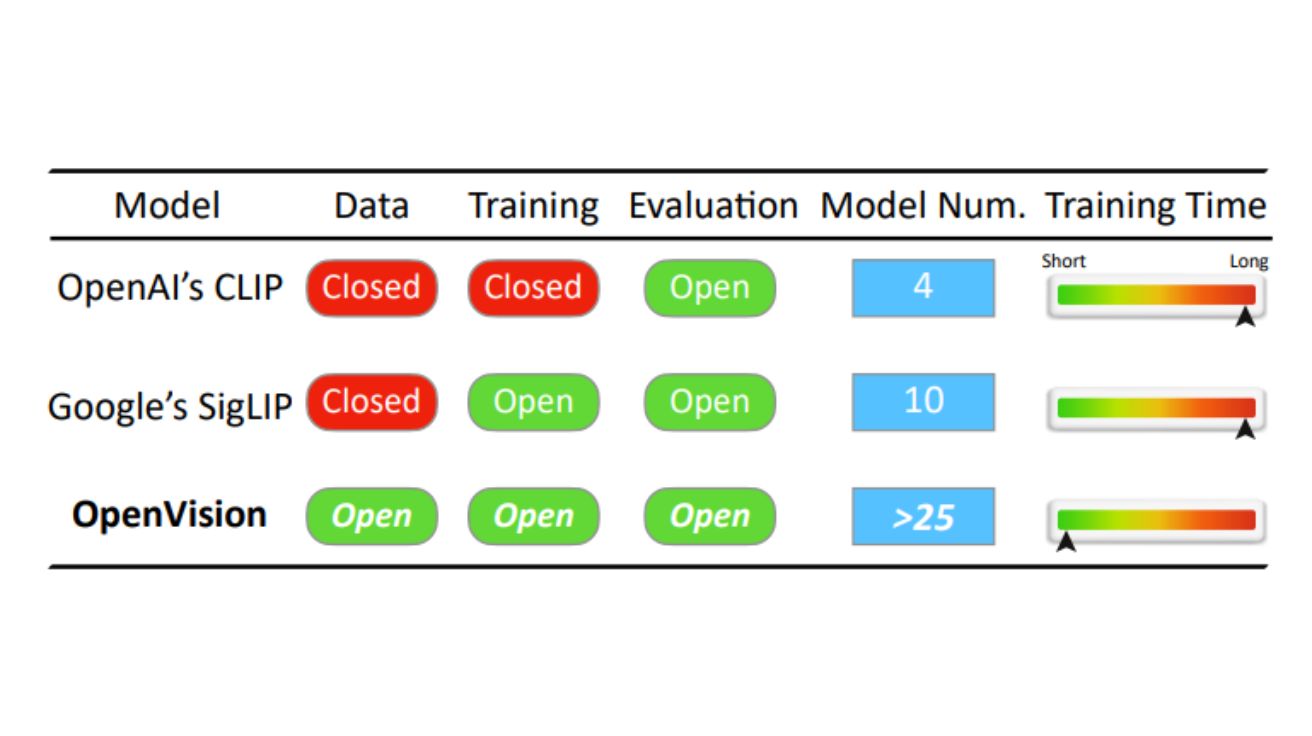

OpenAI의 CLIP(Contrastive Language-Image Pre-training)은 2021년 초에 공개된 이후 멀티모달 기반 모델을 구축하는 데 있어 가장 널리 사용되는 비전 인코더였다. 최근 SigLIP와 같은 대안 모델들이 이러한 현상에 도전하기 시작했지만, 현재까지 완전히 공개된 모델은 없었다. 이들 모델은 학습 데이터가 비공개이거나 학습 방법이 공개되지 않았다.

캘리포니아 산타크루즈 대학 연구팀이 개발한 ‘OpenVision’은 이러한 격차를 메우는 비전 인코더 계열이다. OpenVision은 완전 공개형이며 비용 효율적인 비전 인코더로, LLaVA와 같은 멀티모달 프레임워크에 통합했을 때 OpenAI의 CLIP과 동등하거나 더 뛰어난 성능을 발휘한다.

OpenVision은 학습 프레임워크를 위한 CLIPS와 학습 데이터를 위한 Recap-DataComp-1B와 같은 기존 연구를 기반으로 하면서, 인코더 품질을 향상시키는 여러 핵심 인사이트를 제공하고 멀티모달 모델 발전에 실질적인 이점을 보여준다. 5.9M부터 632.1M 매개변수에 이르는 25종 이상의 다양한 규모의 비전 인코더를 공개함으로써, OpenVision은 멀티모달 모델을 구축하는 데 있어 용량과 효율성 사이의 유연한 선택을 제공한다. 더 큰 모델은 향상된 멀티모달 성능을 제공하는 반면, 더 작은 버전은 경량화되고 엣지 장치에 배포 가능한 멀티모달 시스템을 가능하게 한다.

CLIP의 한계 극복: OpenVision, 공간 관계 이해와 물체 계수에서 문서화된 약점 해결

최근 멀티모달 기반 모델의 발전은 거의 전적으로 동일한 비주얼 백본, 즉 OpenAI의 CLIP 인코더에 의존해 왔다. LLaVA와 Mini-GPT-4와 같은 초기 오픈소스 노력부터 Falcon2 VLM과 Eagle과 같은 최신 고급 모델에 이르기까지, 언어 구성 요소가 빠르게 발전하는 동안에도 OpenAI의 CLIP-L/336은 지속적으로 기본 선택이었다.

그러나 이러한 의존성은 여러 문제를 야기한다. 첫째, OpenAI CLIP의 학습 데이터와 상세한 프레임워크는 공개되지 않아 투명성과 재현성이 제한된다. 둘째, OpenAI의 CLIP은 Base와 Large라는 두 가지 매개변수 규모로만 사용 가능하여, 엣지 장치에 경량 모델을 배포하거나 복잡한 작업을 위한 더 높은 용량의 인코더를 탐색하는 것이 어렵다. 마지막으로, OpenAI의 CLIP은 공간 관계 이해 부족 및 물체 계수 할루시네이션과 같은 문서화된 약점을 가지고 있다.

이에 대응하여 오픈소스 커뮤니티는 완전히 개방된 CLIP 학습 프레임워크, Laion, DataComp, DFN과 같은 수십억 규모의 개방형 데이터셋, 개선된 학습 방법론을 통해 OpenAI의 CLIP을 복제하고 능가하기 위한 노력을 기울여 왔다. 그러나 중요한 격차가 여전히 존재했으며, OpenVision이 이러한 격차를 메우는 역할을 한다.

13배 적은 매개변수로 94% 성능 유지: 모바일에서 대형 서버까지 확장 가능한 유연성

OpenVision은 다양한 자원이나 정확도 요구사항에 맞춘 비전 인코더 스펙트럼을 자유롭게 설계할 수 있게 한다. 이러한 다양성은 다양한 애플리케이션 시나리오에 맞게 OpenVision을 확장하거나 축소하고 패치 크기를 조정하여 보여주며, 초소형 언어 모델과 함께 사용해도 경쟁력 있는 성능을 발휘한다.

우수한 멀티모달 성능을 위한 스케일 업: 더 풍부한 의미론을 인코딩하고 언어와 더 정확하게 정렬할 수 있기 때문에 더 큰 비전 인코더가 강력한 멀티모달 성능이 필요한 애플리케이션에 유용하다. 이를 위해 연구팀은 OpenAI CLIP과 Google SigLIP의 가장 큰 모델보다 훨씬 큰 632.1M 매개변수의 비전 인코더인 OpenVision-H/14를 공개했다. LLaVA-1.5 설정에서 이 변형은 고해상도 VQA, OCR 및 검색 작업에서 멀티모달 이해도에 있어 OpenAI CLIP-L/14보다 상당한 이득을 제공하여 도전적인 멀티모달 작업에 추가 용량의 가치를 확인시켜 준다.

자원 제한적 시나리오를 위한 스케일 다운: 모바일 또는 저전력 장치의 메모리 및 지연 시간 예산을 충족하기 위해, 연구팀은 두 개의 컴팩트한 변형 OpenVision-S/16과 OpenVision-Ti/16을 학습시켰다. 동일한 LLaVA-1.5 설정에서 S/16은 13배 이상 적은 매개변수를 사용하면서도 CLIP-L/14 평균 점수의 94%를 유지하고, Ti/16은 거의 50배 작은 크기에도 87%를 유지한다.

9개 벤치마크에서 증명된 우수성: LLaVA-1.5와 Open-LLaVA-Next 환경에서 OpenAI CLIP 능가

OpenVision은 특히 다른 규모에서 두 가지 LLaVA 설정을 채택했다:

첫 번째는 LLaVA-1.5라는 저연산 레짐으로, 이 설정에서는 비전 인코더가 고정되어 있고, 경량 프로젝터와 언어 모델만 업데이트된다. 이 설정은 사전 학습된 비전 특징의 품질을 평가할 수 있게 한다. 표준 LCS-558K 및 LLaVA-665K 데이터셋으로 학습한다.

두 번째는 Open-LLaVA-Next라는 고연산 레짐으로, 이 설정은 인코더의 추가 학습 및 스케일링 능력을 측정한다. 약 백만 개의 이미지-지시 쌍이 사용되며, 비전 백본, 프로젝터 및 LLM이 모두 미세 조정된다. 이 설정은 또한 기본 크기 336 × 336에서 생성된 여러 종횡비 변형(예: 672×672, 336×1344)으로 이미지를 크기 조정하는 “any-resolution” 전략을 사용하여 더 큰 입력을 처리한다.

연구팀은 OpenVision 계열을 LLaVA-1.5 및 Open-LLaVA-Next 프레임워크에서 인기 있는 독점 및 오픈소스 비전 인코더와 비교했다. 공정성을 보장하기 위해 모든 실행은 CLIPS, LLaVA-1.5 및 OpenLLaVA-Next에서 제공한 원래 하이퍼파라미터를 사용했다. 224×224 해상도에서 OpenVision-B/16 및 OpenVision-L/14 체크포인트는 두 MLLM 설정 모두에서 대부분의 작업에서 비슷한 역할을 수행하는 모델들보다 상당히 뛰어난 성능을 보였고, 특히 9개의 대표적인 벤치마크에서 OpenAI의 CLIP과 Google의 SigLIP을 일관되게 능가하거나 그에 필적하는 성능을 보여주었다.

오픈소스의 힘: 투명성과 협력으로 AI 기술 민주화 이끄는 OpenVision

OpenVision은 최근의 두 가지 발전을 기반으로 한다: Llama-3에 의해 구동되는 LLaVA 모델을 사용하여 전체 DataComp-1B 말뭉치를 다시 캡셔닝하는 Recap-DataComp-1B와 합성 캡션을 통합하는 향상된 CLIP 학습 파이프라인인 CLIPS이다. 이러한 자원을 활용하여 연구팀은 전반적인 학습 효율성을 개선하고 비전 인코더의 품질을 향상시키는 핵심 설계 요소를 식별하고, 다양한 멀티모달 모델 개발에서의 실질적인 이점을 보여주는 체계적인 분석을 수행했다.

이 논문은 멀티모달 기반 모델 개발을 지원하도록 설계된 완전 공개적이고 비용 효율적인 비전 인코더 계열인 OpenVision을 소개한다. 광범위한 실험을 통해 OpenVision 인코더는 OpenAI의 CLIP 및 Google의 SigLIP와 같은 널리 사용되는 독점 모델과 비교 가능하거나 이를 능가하는 성능을 보여준다.

또한 OpenVision은 모델 크기와 입력 해상도 모두에서 유연하게 확장되어 대규모 컴퓨팅 인프라부터 엣지 장치까지 다양한 환경에 배포하기에 적합하다. 모든 모델 가중치, 코드 및 학습 데이터를 공개함으로써, 연구팀은 연구 유연성을 촉진하고 커뮤니티의 추가 혁신을 유도하여 더 투명하고 적응 가능한 멀티모달 기반 모델을 위한 길을 열고자 한다.

FAQ

Q: OpenVision이 기존의 비전 인코더와 어떻게 다른가요?

A: OpenVision은 완전히 공개된 비전 인코더로, 학습 데이터, 코드, 학습 방법 모두가 공개되어 있습니다. 반면 OpenAI의 CLIP이나 Google의 SigLIP 같은 기존 모델들은 학습 데이터나 방법이 비공개입니다. 또한 OpenVision은 5.9M부터 632.1M 매개변수까지 다양한 크기의 모델을 제공하여 경량 장치부터 고성능 서버까지 다양한 환경에 적용할 수 있습니다.

Q: 멀티모달 AI에서 비전 인코더의 역할은 무엇인가요?

A: 비전 인코더는 이미지를 분석하고 이를 언어 모델이 이해할 수 있는 형태로 변환하는 역할을 합니다. 좋은 비전 인코더는 이미지의 세부적인 내용, 공간 관계, 객체 인식 등을 정확히 포착하여 언어 모델이 이미지에 대해 정확한 응답을 생성할 수 있게 해줍니다. OpenVision과 같은 고품질 비전 인코더는 멀티모달 AI의 전반적인 성능을 크게 향상시킵니다.

Q: 오픈소스 비전 인코더가 왜 중요한가요?

A: 오픈소스 비전 인코더는 투명성, 접근성, 혁신을 촉진합니다. 코드와 데이터가 공개되면 연구자들이 모델의 작동 방식을 이해하고 개선할 수 있으며, 더 많은 사람들이 최첨단 AI 기술에 접근할 수 있게 됩니다. 또한 독점 모델에 대한 의존성을 줄이고 다양한 애플리케이션에 맞게 모델을 조정할 수 있는 유연성을 제공합니다.

해당 기사에서 인용한 논문은 링크에서 확인할 수 있다.

이미지 출처: OpenVision : A Fully-Open, Cost-Effective Family of Advanced Vision Encoders for Multimodal Learning

기사는 클로드와 챗GPT를 활용해 작성되었습니다.