Beyond ‘Aha!’: Toward Systematic Meta-Abilities Alignment in Large Reasoning Models

오픈AI o1·딥시크 R1도 겪는 ‘아하!’ 순간의 예측 불가능성 문제

세일즈 포스 AI 연구소 및 싱가포르, 칭화 대학 연구진이 발표한 논문에 따르면, 대형 추론 모델(Large Reasoning Models, LRMs)은 이미 장기간의 사고 연쇄(Chain-of-Thought) 추론 능력을 잠재적으로 보유하고 있다. 오픈AI(OpenAI)의 o1, 딥시크(DeepSeek)의 R1, 그록(Grok) 3.5, 제미나이(Gemini) 2.5 프로 등의 모델들이 복잡한 작업을 처리할 때 긴 사고 연쇄 응답을 생성하고 고급 반성적 추론 행동을 보여주고 있다.

특히 딥시크 R1은 사전훈련된 기본 모델이나 지시 조정된 모델에서 시작하여 순수한 강화학습과 규칙 기반 보상만으로도 긴 사고 연쇄 추론, 자기 교정, 자기 반성 등의 고급 행동이 자발적으로 나타나는 현상을 보여주었다. 이러한 현상은 일반적으로 ‘아하! 순간(aha moment)’이라고 불리며, 모델의 내부적으로 강력한 추론 능력을 경험했다는 신호로 해석된다.

하지만 이러한 창발적 행동에만 의존하는 것은 본질적으로 신뢰할 수 없고 제어하기 어렵다. 모델이 이러한 고급 추론 방식을 일관되게 나타내지 못할 수 있어 대형 언어 모델 기반 추론의 예측 가능성과 확장성을 모두 제한한다.

연역·귀납·가설, 3가지 사고 방식으로 AI에게 체계적 추론 능력 주입

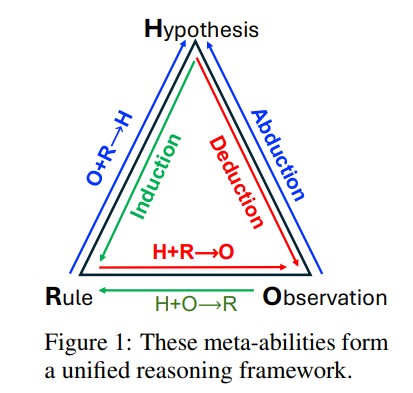

이러한 한계를 극복하기 위해 세일즈 포스 AI 연구소 및 싱가포르, 칭화 대학 연구진은 피어스(Peirce)의 고전적 추론 삼원조에서 도출한 세 가지 영역 일반적 추론 메타능력인 연역(deduction), 귀납(induction), 가설(abduction)을 대형 언어 모델에 명시적으로 정렬하는 방법을 제안했다.

연역은 일반적인 규칙과 가설로부터 특정 결과를 추론하여(H + R → O) 엄격한 예측과 검증을 가능하게 한다. 귀납은 반복적인 공존 현상으로부터 규칙을 추상화하여(H + O → R) 패턴 발견과 일반화를 촉진한다. 가설은 놀라운 관찰에 대한 가장 그럴듯한 설명을 추론하여(O + R → H) 창의적이고 역방향 추론을 장려한다.

이들은 함께 가설 생성, 테스트, 수정을 위한 닫힌 추론 루프를 형성하여 과학적 방법을 반영하고 견고하고 해석 가능한 추론을 지원한다. 연구진은 프로그래밍 방식으로 생성된 인스턴스와 자동 검증 가능성을 갖춘 작업 모음을 구성했다.

개별 훈련→병합→강화학습, 3단계로 완성하는 똑똑한 AI

연구진이 개발한 3단계 파이프라인은 개별 정렬, 매개변수 공간 병합, 도메인별 강화학습으로 구성된다. 첫 번째 단계에서는 연역을 위한 명제 만족도 과제, 귀납을 위한 마스킹된 시퀀스 완성, 가설을 위한 역 규칙 그래프 탐색을 통해 각 메타능력에 모델을 독립적으로 정렬한다.

두 번째 단계에서는 매개변수 공간 모델 병합을 활용하여 이러한 메타능력을 통합한다. 병합된 모델 매개변수는 Θmerge = λdΘ(d) + λiΘ(i) + λaΘ(a) 공식을 통해 계산되며, 각 전문 모델의 기여도를 스칼라 가중치를 통해 제어한다. 실험에서는 λd = 1.0, λi = 0.2, λa = 0.1의 최적 가중치를 사용했다.

마지막 단계에서는 정렬된 체크포인트에서 도메인별 강화학습 훈련을 재개하여 지시 조정된 모델에 동일한 절차를 적용한 것과 비교했다. 메타능력 체크포인트에서 시작하면 달성 가능한 성능 상한이 높아져, 동일한 연속 도메인별 강화학습 훈련 후 지시 전용 대응 모델보다 평균 약 2%의 추가 이득을 달성했다.

7B 모델 2.5%·32B 모델 4.4% 향상, 모델 크기별 일관된 성능 증명

실험 결과는 메타능력 정렬이 지시 조정된 기준선 대비 10% 이상의 성능 향상을 가져온다는 것을 보여준다. 7B 스케일에서 귀납 정렬 모델이 가장 큰 평균 개선을 제공하여 평균 점수를 1.7% 향상시켰고(38.8%에서 39.8%로), 연역 정렬 모델은 MATH500에서 2.8% 증가로 가장 큰 단일 수학 작업 이득을 얻었다.

세 메타능력을 통합한 병합 모델은 전체 평균을 2.5% 더 향상시켜(37.8%로) 능력들이 건설적으로 결합된다는 것을 확인했다. 32B 모델로 확장하면 이러한 패턴이 증폭되어 각 정렬된 모델이 Qwen2.5-32B-지시 기준선을 능가하며 수학 전체 지표에서 평균 3.1%, 전체 평균에서 2.6%의 이득을 얻었다.

도메인별 강화학습 파이프라인에 메타능력 정렬을 포함시키면 7B와 32B 모델 스케일 모두에서 성능이 향상된다. 7B 설정에서 지시 조정된 기준선에서 시작한 도메인별 강화학습은 수학 점수를 41.2로, 전체 평균을 37.8로 향상시켰다. 반면 메타능력 병합 체크포인트에서 강화학습을 초기화하면 동일한 강화학습 일정으로 수학을 43.0, 전체를 39.0으로 끌어올렸다.

FAQ

Q. 메타능력 정렬이란 무엇이고 왜 중요한가요?

A: 메타능력 정렬은 AI 모델에게 연역, 귀납, 가설이라는 세 가지 기본적인 추론 능력을 체계적으로 학습시키는 방법입니다. 기존의 ‘아하!’ 순간에 의존하는 대신 예측 가능하고 일관된 추론 능력을 개발할 수 있어 AI의 신뢰성과 확장성을 크게 향상시킵니다.

Q. 이 연구의 성과가 실제 AI 응용 분야에 어떤 영향을 미칠까요?

A: 수학, 코딩, 과학 분야에서 10% 이상의 성능 향상을 보여주었으며, 특히 복잡한 추론이 필요한 작업에서 더 큰 개선을 보였습니다. 이는 교육, 연구, 문제 해결 등 다양한 실제 응용 분야에서 AI의 활용도를 크게 높일 것으로 예상됩니다.

Q. 다른 AI 추론 방법과 비교했을 때 이 접근법의 장점은 무엇인가요?

A: 기존 방법들이 예측 불가능한 창발적 행동에 의존하는 반면, 이 접근법은 체계적이고 모듈화된 추론 능력을 개발합니다. 또한 추가적인 인간 주석 없이 합성 데이터로 훈련이 가능하며, 각 추론 모드를 독립적으로 분석하고 개선할 수 있어 더 나은 해석 가능성과 안전성을 제공합니다.

해당 기사에 인용한 논문 원문은 링크에서 확인 가능하다.

기사는 클로드와 챗GPT를 활용해 작성되었습니다.