When Bias Backfires: The Modulatory Role of Counterfactual Explanations on the Adoption of Algorithmic Bias in XAI-Supported Human Decision-Making

설명 유무에 따라 정반대로 나타나는 AI 편향의 영향: 294명 참가자 대상 채용 실험 결과

인공지능(AI)이 채용 과정과 같은 중요한 의사결정에 점점 더 많이 활용되면서, AI 시스템의 편향성이 인간의 판단에 어떤 영향을 미치는지에 대한 우려가 커지고 있다. 독일 빌레펠트 대학교와 도르트문트 공과대학교 연구팀은 최근 발표한 연구에서 편향된 AI 추천이 인간의 의사결정 패턴에 미치는 영향과 반사실적 설명(Counterfactual Explanations)의 역할을 심층적으로 분석했다.

연구 결과에 따르면, 놀랍게도 설명 가능한 AI(XAI)가 제공하는 반사실적 설명은 단순히 편향성을 방지하는 것이 아니라, 오히려 역효과를 일으켜 AI의 편향과 반대 방향으로 인간의 의사결정을 변화시키는 것으로 나타났다. 이는 XAI 기술이 단순히 투명성을 높이는 것을 넘어 인간의 판단에 예상치 못한 방식으로 영향을 미칠 수 있다는 점을 시사한다.

참가자 97%가 AI 편향성을 인식하지 못했지만 70%는 추천을 그대로 수용

연구팀은 참가자들에게 채용 담당자 역할을 맡겨 60개의 가상 지원자 프로필을 평가하도록 했다. 실험은 세 단계로 진행되었는데, 처음에는 AI 도움 없이 지원자를 평가하고, 두 번째 단계에서는 성별 편향(남성 또는 여성 선호)이 있는 AI의 추천을 받았으며, 마지막 단계에서는 다시 AI 없이 독립적으로 결정을 내렸다.

주목할 만한 점은 294명의 참가자 중 단 8명만이 AI 시스템의 성별 편향성을 감지했다는 것이다. 이는 AI 편향성이 “보이지 않는 영향력”으로 작용할 수 있다는 심각한 우려를 제기한다. 더욱이 참가자들은 지원자 자격이 비슷한 경우 AI 추천을 70%의 높은 비율로 따랐다. 이는 AI 편향성이 명시적으로 인식되지 않아도 인간의 판단에 상당한 영향을 미칠 수 있음을 보여준다.

AI 설명을 들은 참가자들, 편향 방향과 정반대로 결정 패턴 변화

연구의 가장 놀라운 발견은 반사실적 설명의 효과였다. 설명 없는 AI 추천을 받은 참가자들은 이후 독립적인 결정에서 AI의 편향 방향으로 자신의 결정 패턴을 변화시켰다. 즉, 남성 편향 AI에 노출된 참가자들은 나중에 더 많은 남성 지원자를 선호했고, 여성 편향 AI에 노출된 참가자들은 더 많은 여성 지원자를 선호하는 경향을 보였다.

그러나 반사실적 설명이 제공된 경우, 정반대의 패턴이 나타났다. 설명을 받은 참가자들은 AI가 편향된 방향과 반대로 자신의 결정을 변화시켰다. 이는 설명이 단순히 편향성을 방지하는 것이 아니라, 일종의 심리적 반발을 유발하여 AI의 선호와 반대 방향으로 결정을 내리도록 영향을 미친다는 것을 시사한다.

남성 편향 AI에만 나타난 자신감 변화: 신뢰도는 모든 조건에서 유사

연구는 또한 XAI가 신뢰도와 결정 자신감에 미치는 영향도 조사했다. 흥미롭게도 AI에 대한 신뢰도는 설명 유무나 편향 방향에 관계없이 모든 조건에서 큰 차이를 보이지 않았다. 이는 반사실적 설명이 반드시 AI에 대한 신뢰를 높이는 것은 아니라는 점을 시사한다.

결정 자신감은 실험 단계와 성별 편향 조건에 따라 달라졌는데, 특히 남성 편향 AI에 노출된 경우에만 자신감 패턴의 변화가 관찰되었다. 이는 AI 편향과 인간의 의사결정 사이의 상호작용이 기존의 사회적 편향과 기대에 따라 다르게 나타날 수 있음을 보여준다.

편향 감지율 2.7%: AI 설명 방식의 근본적인 재고 필요

이 연구 결과는 채용 맥락에서 XAI 시스템의 설계와 배포에 중요한 시사점을 제공한다. 우선, 단순히 설명을 제공하는 것이 반드시 더 나은 인간 감독이나 객관적인 의사결정으로 이어지지 않는다는 점이다. 설명은 직접적인 편향 채택을 방지할 수 있지만, 객관성보다는 반대 편향을 촉진하는 것으로 나타났다.

또한, 설명이 있더라도 편향 감지율이 낮다는 것은 현재의 XAI 접근 방식이 사용자가 체계적인 편향 패턴을 식별하는 데 충분하지 않을 수 있음을 시사한다. 이는 편향을 더 명확하게 드러내는 새로운 설명 형식이나 보조 도구의 필요성을 제기한다.

연구 저자들은 “편향된 AI 추천이 인간의 판단에 미치는 영향을 완화하기 위해서는 단순히 알고리즘 편향성을 수정하는 것을 넘어, 인간-AI 상호작용의 복잡한 심리적 역학을 이해하는 것이 중요하다”고 강조했다.

FAQ

Q: AI의 편향성이 무엇이며 왜 문제가 되나요?

A: AI 편향성은 인공지능 시스템이 특정 개인이나 집단을 부당하게 선호하거나 불이익을 주는 것을 말합니다. 이는 채용과 같은 중요한 의사결정에서 공정성을 해치고, 더 심각한 문제는 이 연구에서 보듯이 사람들이 AI의 편향을 인식하지 못한 채 그 영향을 받아 자신의 판단까지 변화시킬 수 있다는 점입니다.

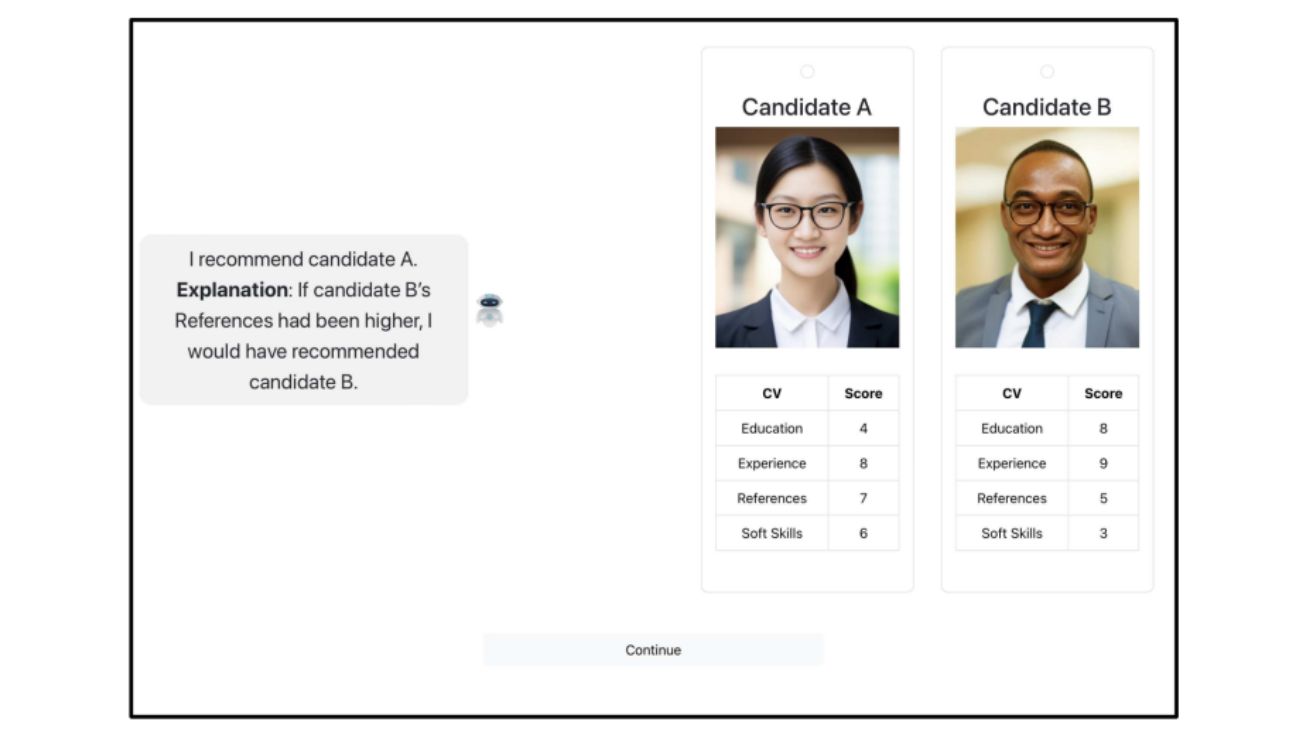

Q: 반사실적 설명(Counterfactual Explanations)이란 무엇인가요?

A: 반사실적 설명은 “만약 ~했다면, 결과는 달라졌을 것이다”라는 형식으로 AI의 결정을 설명하는 방법입니다. 예를 들어, “지원자 B의 교육 수준이 더 높았다면, 지원자 B를 추천했을 것이다”와 같은 설명입니다. 이는 AI 의사결정 과정을 인간이 이해하기 쉽게 만들기 위한 방법이지만, 이 연구에서는 예상치 못한 방식으로 사람들의 판단에 영향을 미치는 것으로 나타났습니다.

Q: 이 연구 결과가 실제 AI 시스템 사용에 어떤 의미가 있나요?

A: 이 연구는 AI 시스템의 투명성과 설명 가능성이 단순히 사용자의 이해를 돕는 것을 넘어, 의사결정에 예상치 못한 영향을 미칠 수 있음을 보여줍니다. 기업과 조직은 AI 시스템을 도입할 때 단순히 기술적 편향 제거를 넘어, 사용자가 어떻게 AI 추천과 상호작용하는지, 그리고 설명이 어떻게 판단에 영향을 미치는지에 대한 포괄적인 이해가 필요합니다.

해당 기사에 인용한 논문 원문은 링크에서 확인 가능하다.

기사는 클로드와 챗GPT를 활용해 작성되었습니다.