DO THEY SEE WHAT WE SEE? Building Emotionally Intelligent AI with EmoNet

인공지능 연구 관련 비영리 단체 라이온(LAION)이 인텔(Intel)과의 협력을 통해 개발한 EmoNet은 AI가 인간의 미묘한 감정까지 인식할 수 있는 새로운 기술적 돌파구를 마련했다. 이번 발표는 단순한 언어 처리를 넘어 진정한 감정 지능을 갖춘 AI 시스템 구축의 가능성을 현실화했다는 점에서 주목받고 있다.

기쁨·슬픔을 넘어선 40개 감정 분석: 당황·자부심·피로까지 구분하는 정밀 시스템

EmoNet의 핵심은 기존의 단순한 기본 감정 분류를 뛰어넘는 40개 카테고리의 정교한 감정 분류체계다. 이 분류체계는 ‘감정 핸드북(Handbook of Emotions)’ 분석을 토대로 심리학자들과의 협의를 거쳐 완성됐다. 기쁨, 슬픔 같은 기본 감정뿐만 아니라 당황(Embarrassment), 수치(Shame), 자부심(Pride) 같은 사회적 감정, 집중(Concentration), 혼란(Confusion), 의심(Doubt) 같은 인지적 상태, 심지어 통증(Pain), 피로(Fatigue), 취함(Intoxication) 같은 신체적 상태까지 포괄한다.

이러한 세밀한 분류는 구성된 감정 이론(Theory of Constructed Emotion)에 기반했다. 이 이론에 따르면 감정은 미리 프로그램된 고정된 실체가 아니라 뇌가 내부 신호와 학습된 개념, 맥락 정보를 결합해 구성하는 복합적 현상이다. 따라서 단순한 감정 ‘인식’이 아닌 다양한 감정의 존재 가능성과 강도를 평가하는 감정 ‘추정’이 필요하다는 것이 LAION의 접근법이다.

20만 장 얼굴 사진으로 훈련한 시각 AI: 심리학 전문가 1만 건 평가로 완성

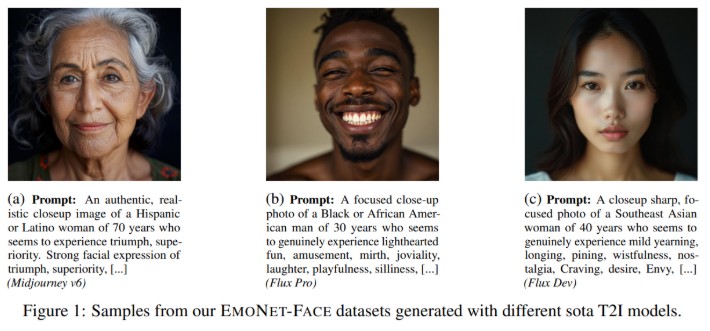

EMONET-FACE는 시각적 감정 인식을 위한 포괄적 리소스를 제공한다. 이 시스템은 세 가지 주요 구성요소로 이뤄져 있다. EMONET-FACE BIG는 20만 3천 개 이상의 합성 이미지로 모델 사전 훈련을 위한 대규모 데이터셋을 제공한다. EMONET-FACE BINARY는 약 2만 개 이미지와 6만 2천 개 이상의 인간 전문가 이진 감정 주석을 포함해 미세 조정용으로 설계됐다. 이 주석들은 긍정적 레이블에 대해 3중 긍정 합의를 요구하고 대조 배치를 통해 고품질 참 음성을 보장하는 엄격한 다단계 과정을 거쳤다.

가장 주목할 만한 것은 EMONET-FACE HQ다. 2천 5백 개 이미지로 구성된 이 골드 스탠다드 평가 벤치마크는 여러 심리학 전문가들이 40개 감정 카테고리 전반에 걸쳐 연속적인 0-7 강도 척도로 세심하게 평가해 총 1만 개의 전문가 주석을 생성했다.

합성 이미지들은 최첨단 텍스트-이미지 모델을 사용해 생성됐으며, 인종, 연령, 성별에 걸친 다양한 인구통계학적 표현과 명확하고 전체적인 얼굴 표정을 보장하기 위한 명시적 프롬프트를 활용했다. 이러한 접근법은 통제된 다양성을 허용할 뿐만 아니라 실제 개인의 이미지 사용과 관련된 윤리적 우려도 회피한다.

5천 시간 음성 데이터로 목소리 감정 해독: 4개 언어·11개 목소리로 구축

EMONET-VOICE는 청각 영역에서 유사한 엄격함으로 접근했다. 4천 692개의 높은 합의도를 가진 오디오 샘플을 LAION의 Got Talent에서 선별했다. 각 스니펫은 특정 감정을 유발하도록 설계된 장면을 연기하는 배우들을 시뮬레이션한다. 중요한 것은 각 스니펫이 심리학 학위를 가진 인간 전문가들의 엄격한 검증을 거쳤다는 점이다. 이들은 존재하지 않음(Not Present), 약하게 존재함(Mildly Present), 강하게 존재함(Intensely Present)이라는 지각된 강도 레이블을 엄격한 3명 주석자 합의 프로토콜에 따라 할당했다.

LAION’s Got Talent 데이터셋은 이 음성 감정 이니셔티브의 핵심이다. HyperLab API를 통해 OpenAI의 GPT-4 오디오 모델을 활용해 생성된 이 포괄적 리소스는 11개의 서로 다른 음성, 40개의 세심하게 선별된 감정 카테고리, 영어(약 2천 156시간), 독일어(약 716시간), 스페인어(약 888시간), 프랑스어(약 881시간) 등 4개 언어를 포함한다. 이 데이터셋의 누적 재생 시간은 2021년부터 2024년까지 미국 영화관에서 상영된 모든 영화의 누적 재생 시간보다 많아 그 규모를 가늠할 수 있다.

구글 제미나이·Hume AI 성능 초월한 오픈소스 모델 공개

이러한 벤치마크의 위력은 LAION의 EMPATHIC INSIGHT 모델들이 입증했다. EMPATHIC INSIGHT-FACE는 EMONET-FACE HQ에서 인간 전문가 수준의 성능을 달성하며 구글의 제미나이 2.5 프로(Gemini 2.5 Pro)와 Hume AI 같은 독점 API들을 능가했다. 이 모델은 다양한 모델 주석자와 인간 주석 간의 평균 스피어만 로(Spearman’s Rho) 상관관계에서 가장 높은 성능을 보였다.

EMPATHIC INSIGHT-VOICE는 LAION’s Got Talent과 EMONET-VOICE로 훈련돼 음성 감정 추정에서 새로운 최고 성능을 기록했다. EmoNet-Voice 벤치마크에서 오디오 언어 모델들과의 성능 비교에서 탁월한 결과를 보여줬다. 이 모델들은 크리에이티브 커먼즈 라이선스로 허용적 라이선스화돼 있어 글로벌 AI 커뮤니티가 자유롭게 활용할 수 있다.

BUD-E Whisper: 전사를 넘어선 감정적 이해의 새로운 패러다임

음성 내 감정적 콘텐츠를 진정으로 활용하기 위해서는 단순한 전사로는 불충분하다. 이에 LAION은 OpenAI의 Whisper 모델을 미세 조정한 BUD-E Whisper 제품군을 개발했다. BUD-E Whisper는 고급 감정 캡션을 위해 특별히 적응됐다. 이 모델들은 단순히 음성을 텍스트로 변환하는 것을 넘어 감정적 톤(40개 카테고리 분류체계에서 인지된 감정 식별), 음성적 폭발(웃음, 한숨, 헐떡임 등 비어휘적 표현 인식), 화자 특성(연령, 성별, 심지어 말하기 스타일까지 추론) 등의 구조화된 설명을 생성한다.

BUD-E Whisper의 훈련은 반복적 개선의 여정이었다. LAION’s Got Talent 음성 연기 데이터와 공개 블로그, 온라인 일기, 영화 대화에서 약 5천 시간의 오디오를 포함한 다양한 데이터셋을 활용했으며, 음성 활동 감지(VAD)를 사용해 음성 세그먼트를 분리했다. 그 후 제미나이 플래시 2.0(Gemini Flash 2.0)을 사용해 40개 카테고리 감정 분류체계를 따라 이 샘플들에 주석을 달았다.

FAQ

Q: EmoNet의 40개 감정 카테고리가 기존 AI 감정 인식과 어떻게 다른가요?

A: 기존 AI는 주로 기쁨, 슬픔, 분노 등 기본 감정만 인식했지만, EmoNet은 당황, 자부심 같은 사회적 감정부터 집중, 의심 같은 인지 상태, 심지어 피로, 통증 같은 신체 상태까지 40개 세분화된 감정을 정확히 구분할 수 있습니다.

Q: 합성 데이터로 만든 감정 인식 AI가 실제 인간 감정도 정확히 읽을 수 있나요?

A: LAION의 EMPATHIC INSIGHT 모델은 합성 데이터로 훈련됐지만 인간 심리학 전문가들의 평가와 거의 동일한 수준의 감정 인식 정확도를 보여줍니다. 실제로 구글 제미나이나 Hume AI 같은 기존 상용 모델들보다 우수한 성능을 기록했습니다.

Q: BUD-E Whisper는 기존 음성 인식 기술과 어떤 차이가 있나요?

A: 기존 음성 인식은 단순히 말을 글자로 바꾸는 전사 기능에 그쳤지만, BUD-E Whisper는 목소리 톤에서 감정 상태를 파악하고 웃음이나 한숨 같은 비언어적 표현까지 인식해 화자의 감정과 특성을 종합적으로 분석합니다.

해당 기사에 인용된 리포트 원문은 LAION에서 확인 가능하다.

이미지 출처: LAION

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.