“선배, 이 환자 어떻게 볼까요?” AI가 실제 환자 데이터로 가상 진료 시뮬레이션한다

드라마 ‘언젠가는 슬기로울 전공의생활’에서 1년 차 레지던트 오이영이 어려운 환자를 만날 때마다 같은 연차 동료나 2년 차 선배들에게 조언을 구하고, 함께 머리를 맞대고 고민하는 장면이 인상적이었다. 실제 병원에서도 의사들은 복잡한 케이스를 두고 여러 전문과 의사들과 상의하며 최선의 진단을 찾아간다.

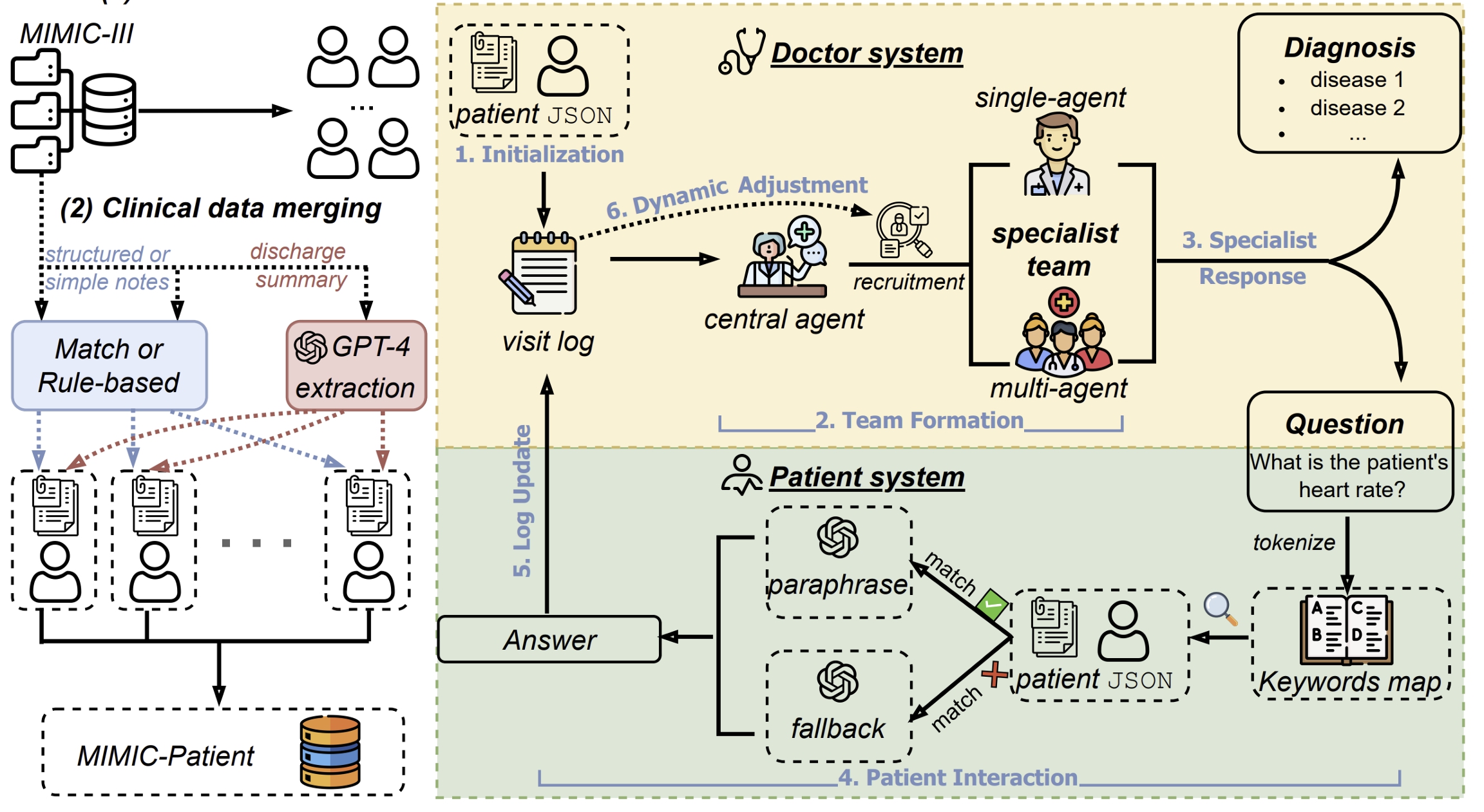

이제 AI도 드라마 속 레지던트들처럼 환자 케이스를 바탕으로 진료 시뮬레이션을 수행하는 시대가 열렸다. 펜실베이니아 대학교(University of Pennsylvania)와 사우스플로리다 대학교(University of South Florida) 연구진이 개발한 ‘다이나미케어(DynamiCare)’는 실제 4만여 명의 환자 의료기록을 바탕으로 AI끼리 가상 진료를 하며 진단 능력을 평가받는 혁신적인 시스템이다.

기존 AI 시스템은 단일턴 방식이 많아 실시간 상호작용의 부족이 지적돼 왔다. 하지만 다이나미케어는 실제 의사처럼 “언제부터 아프셨어요?”, “다른 증상은 없나요?” 하며 차근차근 정보를 수집하고, 동료 의사들과 상의해서 진단을 내린다.

“신경과 선생님, 상의 좀 드릴게요” 필요할 때마다 전문의 호출하는 똑똑한 AI

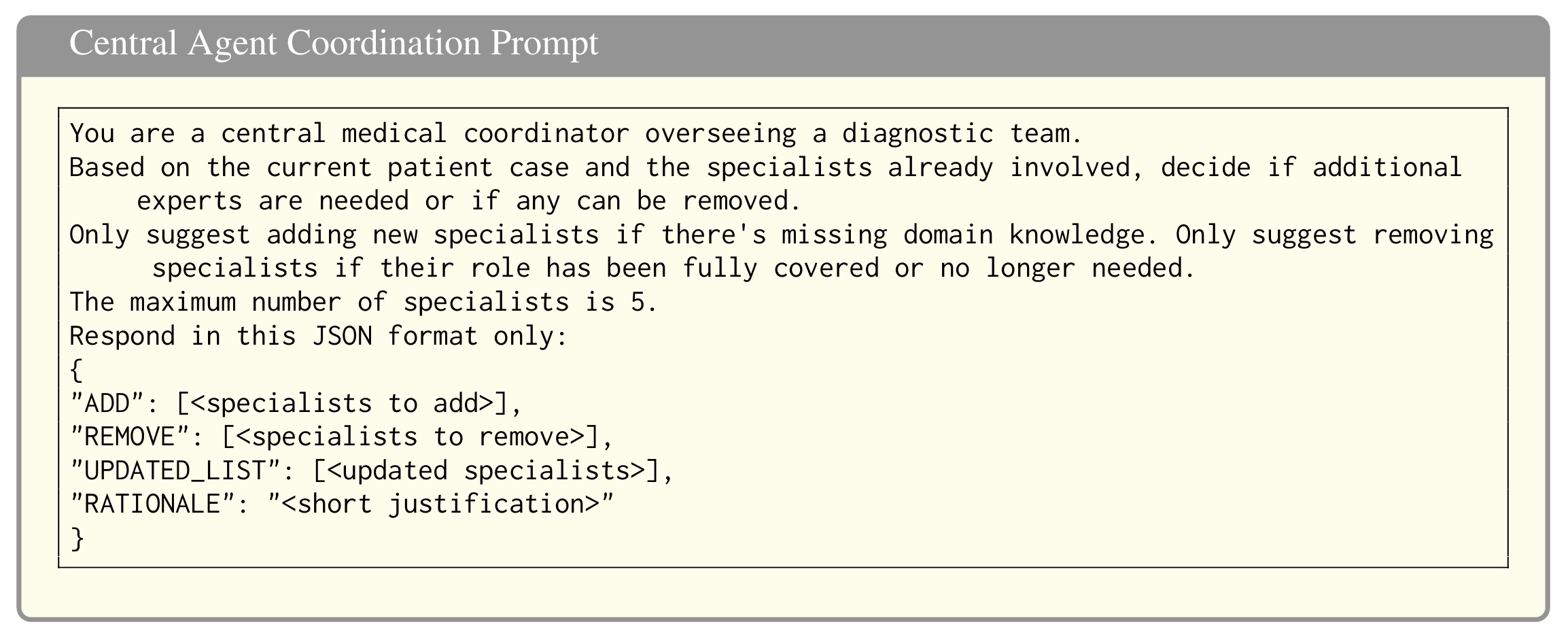

다이나미케어의 가장 흥미로운 점은 마치 드라마 속 응급실처럼 상황에 따라 필요한 전문의를 불러 모은다는 것이다. 중앙 조정 역할을 하는 AI가 환자 상태를 파악한 후 “이건 신경과 케이스네”, “영상의학과 선생님도 필요할 것 같은데” 하며 적절한 전문의 AI들을 차례로 투입한다.

예를 들어 심한 두통을 호소하는 60세 여성 환자가 있다면, 처음에는 신경과 의사와 신경외과 의사 AI가 팀을 이룬다. 이들이 “급성 경막하혈종 진단받은 적 있나요?”, “CT 촬영 결과는 어떻게 나왔나요?” 같은 질문을 던진다. 그러다 CT 스캔 분석이 필요해지면 영상의학과 의사 AI가 추가로 합류해 “9mm 우측 편위가 보이네요”, “뇌압 상승 소견이 있습니다” 같은 전문적인 판단을 내린다.

더욱 놀라운 것은 이 AI 의사들이 서로 토론하고 투표를 통해 합의를 이룬다는 점이다. 각자 의견을 제시하고 확신도를 표명한 뒤, 다른 동료의 제안에 “동의합니다” 또는 “다른 의견입니다”라고 답한다. 마치 실제 병원의 다학제 회진(MDT)이 AI로 재현된 셈이다.

하버드 의대 부속병원 4만 명 실제 환자 데이터로 “실전같은” 훈련

이 시스템이 더욱 놀라운 이유는 가상의 시나리오가 아닌 실제 환자 데이터를 활용한다는 점이다. 연구진은 하버드 의과대학 부속 베스 이스라엘 디코니스 메디컬 센터(Beth Israel Deaconess Medical Center)에서 수집한 중환자실 환자 4만여 명의 실제 의료기록을 바탕으로 ‘MIMIC-Patient’라는 특별한 데이터셋을 구축했다.

이 중에서 진단이 너무 복잡하지 않고(5개 질환 미만) 충분한 의료 정보가 있는 케이스들을 선별해 최종 500명의 환자 데이터를 완성했다. 각 환자 정보에는 나이, 성별 같은 기본 정보부터 혈압, 심전도, CT·MRI 결과, 처방약 목록, 의사의 진료 기록까지 실제 진료에 필요한 모든 정보가 담겨 있다.

AI 환자 시스템은 이런 구조화된 데이터를 바탕으로 의사 AI의 질문에 시뮬레이션된 답변을 생성한다. “혈압이 어떻게 되세요?”라고 물으면 “158/91mmHg예요”, “언제부터 증상이 시작됐나요?”라고 하면 “3일 전부터 두통이 심해졌어요”처럼 실제 의료기록에 기반한 답변을 제공한다.

기존 AI 의사보다 최대 8.4%p 높은 정확도…복잡한 케이스일수록 팀워크 위력 발휘

실험 결과는 고무적이었다. GPT-4.1을 기반으로 한 다이나미케어 팀은 상위 5개 진단 후보 중 정답을 맞추는 비율에서 63.4%를 기록했다. 이는 혼자 진단하는 단일 AI 의사의 58.0%보다 5.4%포인트 높은 수치다. 상위 10개 후보까지 확장하면 71.6%로 단일 시스템(63.2%)을 8.4%포인트나 앞섰다.

특히 흥미로운 점은 질환별로 성과가 달랐다는 것이다. 순환기계 질환(심장·혈관 관련, 74.09%), 근골격계 질환(뼈·관절 관련, 76.0%), 내분비 질환(당뇨·갑상선 등, 67.27%)에서는 높은 정확도를 보였다. 반면 암(32.0%)이나 증상이 애매한 질환(48.78%)에서는 상대적으로 어려움을 겪었다. 이는 실제 의료 현장에서도 진단이 까다로운 영역들과 정확히 일치한다.

연구진은 “명확한 증상이 있는 질환일수록 AI가 효율적으로 질문을 던져 빠르게 진단에 도달할 수 있었다”며 “반면 여러 장기에 걸친 복잡한 질환이나 사회적 맥락이 중요한 경우에는 여전히 한계가 있다”고 설명했다.

FAQ

Q: AI끼리 가상 진료를 한다는 게 정확히 어떤 의미인가요?

A: 실제 환자와 AI가 대화하는 게 아닙니다. 실제 환자 의료기록을 바탕으로 한 AI가 환자 역할을 하고, 여러 전문의 AI가 이 가상 환자에게 질문하며 진단하는 시뮬레이션 시스템입니다. 마치 의대생들이 모의환자로 실습하는 것과 비슷합니다.

Q: 이런 시스템이 실제 병원에서도 활용될 수 있나요?

A: 현재는 의료진 교육이나 AI 성능 개선을 위한 연구 목적으로 개발됐습니다. 실제 진료에 적용하려면 더 많은 검증과 안전장치가 필요하며, 반드시 의료진의 최종 판단이 전제되어야 합니다.

Q: AI가 잘못 진단할 위험은 없나요?

A: 모든 AI 시스템처럼 완벽하지 않습니다. 특히 복잡한 질환이나 희귀 질환에서는 정확도가 떨어질 수 있어, 연구진도 교육·연구 목적으로만 사용하고 실제 환자 진료에는 의료진의 전문적 판단이 필수라고 강조했습니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

출처: DynamiCare: A Dynamic Multi-Agent Framework for Interactive and Open-Ended Medical Decision-Making

이미지 출처: 챗GPT 생성