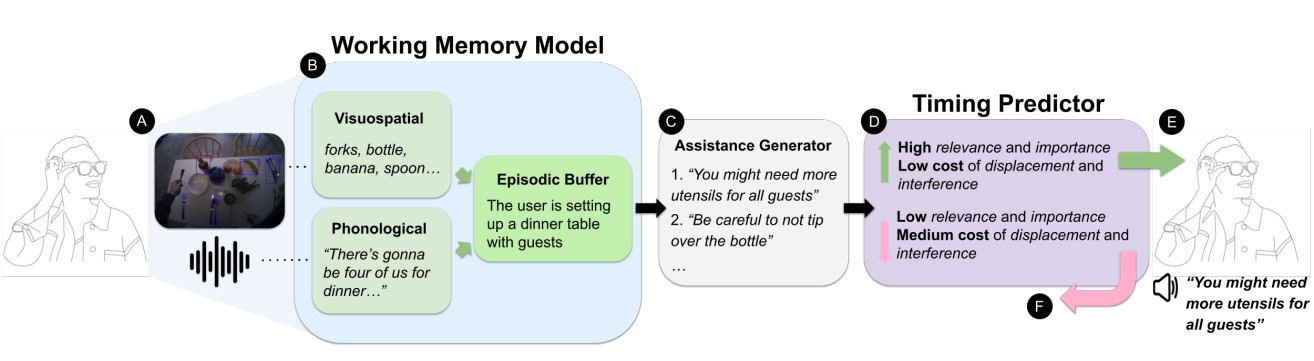

메타와 토론토대학교 연구진이 사용자의 머릿속 상황을 파악해서 적절한 타이밍에만 도움을 주는 스마트안경용 AI 시스템을 개발했다. 프로멤어시스트(ProMemAssist)라는 이름의 이 시스템은 기존 스마트안경에 탑재되어 사용자가 뭔가에 집중하고 있을 때는 말을 걸지 않고, 정신적으로 여유가 생겼을 때만 필요한 정보를 알려준다.

기존 AI 어시스턴트들은 사용자가 바쁘든 말든 상관없이 일방적으로 정보를 전달했다. 하지만 이 새로운 시스템은 마치 눈치 있는 사람처럼 상황을 파악한다. 예를 들어 사용자가 식탁을 차리다가 와인병을 테이블 가장자리에 위험하게 놓았다고 하자. 시스템은 “조심하세요”라고 말하려다가도, 사용자가 냉장고에서 달걀 개수를 세느라 바쁘면 나중에 말한다. 사용자가 그 일을 끝내고 다시 식탁으로 돌아왔을 때 비로소 “와인병이 넘어질 수 있으니 조심하세요”라고 알려준다.

뇌 속 단기기억 상태 실시간으로 추적하는 기술

연구진은 사람의 단기기억 원리를 AI에 적용했다. 사람의 뇌는 한 번에 처리할 수 있는 정보량이 제한되어 있고, 새로운 정보가 들어오면 기존 정보와 충돌하기도 한다. 이런 뇌 과학 원리를 이용해 사용자가 지금 머릿속에서 무엇을 처리하고 있는지, 새로운 정보를 받아들일 여유가 있는지 판단하는 것이다.

시스템은 사람의 뇌가 동시에 처리할 수 있는 정보를 최대 7개로 제한하고, 이를 최대 4개의 의미 있는 상황 덩어리로 묶어서 이해한다. 예를 들어 “포크, 접시, 나이프를 보고 있다”는 개별 정보들을 “식탁을 차리고 있다”는 하나의 상황으로 통합해서 파악하는 식이다.

시스템은 스마트안경의 카메라와 마이크를 통해 사용자가 보고 듣는 모든 것을 분석한다. 이때 카메라로 물체를 인식하는 YOLO 기술과 음성을 텍스트로 바꾸는 Whisper 기술을 사용한다. 또한 이미지와 텍스트를 동시에 이해하는 CLIP이라는 AI 모델로 상황을 종합 판단한다. 사용자가 접시를 놓고, 컵을 옮기고, 누군가와 대화하는 모든 상황을 종합해서 지금 사용자의 머릿속 상태를 실시간으로 파악한다. 마치 사람의 뇌 속 메모리를 들여다보는 것처럼 현재 어떤 정보들이 처리되고 있는지 추적하는 셈이다.

방해받기 싫을 때는 조용히, 필요할 때만 정확히 개입

12명을 대상으로 한 실험에서 놀라운 결과가 나왔다. 사용자들이 식탁 차리기, 짐 싸기, 사무용품 정리하기 같은 일상적인 일을 할 때, 새로운 시스템은 기존 AI보다 훨씬 좋은 반응을 얻었다. 사용자들이 “도움이 됐다”고 긍정적으로 반응한 비율이 24.6%로, 기존 시스템의 9.34%보다 2.6배나 높았다.

구체적인 숫자로 보면 ProMemAssist는 395번의 상황 파악 중에서 218개의 도움 메시지를 만들어냈다. 이 중 130개는 바로 전달하고, 31개는 나중으로 미뤘으며, 57개는 별로 도움이 안 될 것 같아서 아예 전달하지 않았다. 반면 기존 시스템은 534번의 상황에서 332개 메시지를 모조리 즉시 전달했다. 작업 완료 시간은 거의 비슷했지만(175초 vs 182초), 사용자 만족도에서는 큰 차이가 났다.

더 중요한 것은 사용자들이 느끼는 스트레스가 줄어들었다는 점이다. 참가자들은 “내가 뭔가에 집중하고 있을 때는 말을 걸지 않고 기다려주는 것 같았다”고 평가했다. 실제로 좌절감 점수가 크게 낮아져서(7점 만점에 2.32점 vs 3.14점) 사용자 경험이 개선됐음을 보여줬다. 흥미로운 것은 새로운 시스템이 기존 시스템보다 실제로는 더 적은 횟수로 도움을 줬다는 점이다. 하지만 적절한 타이밍에 정확히 개입해서 오히려 사용자 만족도는 훨씬 높았다. 마치 말 많은 사람보다 꼭 필요할 때만 한 마디 하는 사람이 더 신뢰받는 것과 같은 원리다.

실제 생활에서 어떻게 작동하나

연구진은 4가지 일상 상황을 테스트했다. 식탁 차리기에서는 “4명이 올 거니까 수저를 더 준비하세요”, 짐 싸기에서는 “비즈니스 미팅이니까 넥타이를 챙기세요”, 사무용품 정리에서는 “회의 때 필요하니까 메모지를 가까이 두세요” 같은 식으로 상황에 맞는 조언을 했다.

시스템이 똑똑한 점은 같은 종류의 정보끼리 충돌할 때를 구분한다는 것이다. 예를 들어 사용자가 누군가와 대화하고 있을 때 음성으로 새로운 조언을 하면 혼란스러울 수 있다. 반대로 시각적인 작업을 하고 있을 때는 음성 조언이 덜 방해가 된다. 또한 머릿속 정보 저장공간이 가득 찰 때는 오래되고 덜 중요한 정보를 새로운 중요한 정보로 자동 교체한다.

개인 맞춤형 학습과 소통 기능 강화 계획

실험에 참여한 사용자들은 전반적으로 만족했지만 몇 가지 개선점도 제안했다. “시스템이 시간이 지나면서 내 습관을 학습했으면 좋겠다”거나 “내가 항상 열쇠를 깜빡하니까 자동으로 알려줬으면 좋겠다”는 의견이 나왔다. 또한 사용자가 시스템에게 피드백을 줄 수 있는 방법이 있으면 좋겠다는 제안도 있었다.

연구진은 현재 시스템이 눈으로 보는 것과 귀로 듣는 것만 분석한다는 한계를 인정했다. 앞으로는 사용자의 시선 방향, 손동작, 심지어 만지는 감각까지 종합적으로 파악할 수 있도록 개선할 예정이다. 이렇게 되면 사용자의 상황을 더 정확하게 이해하고, 개인별 특성에 맞춘 맞춤형 서비스를 제공할 수 있을 것으로 기대된다. 연구진은 이 기술이 스마트워치, 이어폰, 심지어 일반 컴퓨터에서도 활용 가능하다고 보고 있다. 각각의 기기 특성에 맞게 조정하면 더 다양한 환경에서 사용할 수 있을 것으로 예상된다.

FAQ

Q: 이 기술이 일반 스마트폰이나 다른 기기에서도 사용할 수 있나요?

A: 네, 연구진은 스마트워치, 이어폰, 컴퓨터 등 다양한 기기에서도 활용 가능하다고 밝혔습니다. 각 기기의 특성에 맞게 시스템을 조정하면 더 넓은 범위에서 사용할 수 있습니다.

Q: 사용자의 사생활이나 개인정보 보호는 어떻게 되나요?

A: 현재 시스템은 사용자 기기에서 직접 처리되며, 연구진은 투명하고 개인정보를 보호하는 방식으로 개발해야 한다고 강조했습니다. 사용자가 언제 어떻게 정보가 수집되는지 알 수 있도록 하는 것이 중요합니다.

Q: 언제쯤 실제로 이런 기능을 사용할 수 있게 될까요?

A: 아직 연구 단계이지만, 연구진은 더 많은 상황에서 테스트하고 개인화 기능을 추가해서 실용적인 시스템으로 발전시킬 계획이라고 밝혔습니다. 구체적인 상용화 시기는 언급되지 않았습니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: ProMemAssist: Exploring Timely Proactive Assistance Through Working Memory Modeling in Multi-Modal Wearable Devices

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.