보스턴 대학교(Boston College) 연구진이 발표한 연구에 따르면, ChatGPT-4와 ChatGPT-3.5가 차트나 그래프 만들기 조언에서 사람 전문가보다 더 좋은 답변을 제공하는 것으로 나타났다. 이 연구는 AI 챗봇이 데이터를 시각적으로 표현하는 분야에서 어떻게 사람의 능력을 뛰어넘고 있는지를 자세히 살펴봤다.

ChatGPT-4는 사람과 가장 비슷한 답변 방식을 보여

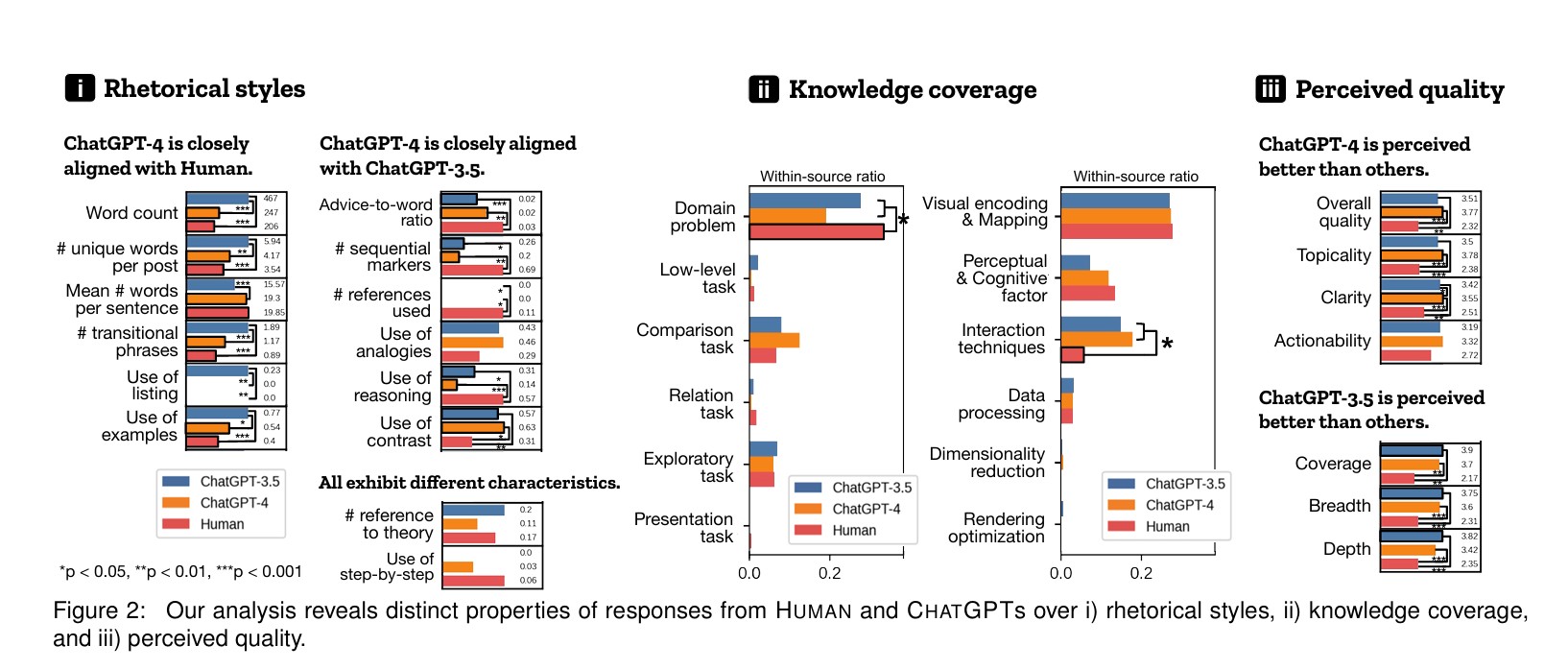

연구 결과에 따르면 ChatGPT-4는 글 쓰는 방식과 지식 범위에서 사람의 답변과 가장 비슷한 특성을 보였다. 특히 주목할 점은 ChatGPT-3.5의 답변 길이가 ChatGPT-4와 사람보다 정확히 2배 길었다는 것이다. 하지만 같은 길이로 비교했을 때는 ChatGPT-4와 사람이 더 다양한 단어와 복잡한 문장을 사용했다. 가장 흥미로운 발견은 사람의 답변이 같은 분량에서 더 많은 조언을 담고 있다는 점이었다. 연구진이 ‘조언 대비 단어 비율’을 측정한 결과, 사람이 다른 모델들보다 훨씬 높은 효율성을 보였다.

설명하는 방식에서는 두 챗GPT 모델이 사람과 다른 특징을 보였다. 사람은 더 많은 참고 자료와 정보 출처를 제시했으며, ‘첫째, 마지막으로’ 같은 순서를 나타내는 말을 독점적으로 사용했다. 반면 챗GPT 모델들은 ‘반대로, 대조적으로’ 같은 대비하는 표현을 자주 사용해 차이점을 강조했다. ChatGPT-3.5는 특히 예시나 글머리 기호를 사용한 목록 형태로 설명하는 것을 선호했다.

지식 범위에서는 사람이 데이터 이해에, AI가 기능 설명에 강함

지식의 범위를 분석한 결과, 두 챗GPT 모델은 사람과 비슷한 수준의 차트 관련 지식을 보였지만, 중요하게 생각하는 부분에서 차이를 보였다. 연구진이 카이제곱 검정이라는 통계 분석을 실시한 결과, 사람은 데이터의 특성을 이해하는 것 같은 근본적인 문제에 유의미하게 더 많은 관심을 보였다. 반면 챗GPT 모델들은 마우스를 올렸을 때 나타나는 정보창이나 세부 정보를 보여주는 드릴다운 기능 같은 실용적인 기술을 더 자주 설명했다.

연구진이 각 모델의 지식 분포를 정량적으로 측정한 결과, ChatGPT-4의 지식 패턴이 ChatGPT-3.5보다 사람에 더 가까운 것으로 나타났다. 이는 더 발전된 AI 모델일수록 사람과 비슷한 방식으로 지식을 다룬다는 점을 보여준다. 이러한 분석을 위해 연구진은 587개의 키워드로 확장된 3단계 계층 분류 체계를 사용했다.

사용자 평가에서 챗GPT가 모든 품질 지표에서 우위

210명을 대상으로 한 설문조사에서 두 챗GPT 모델 모두 사람보다 높은 점수를 받았다. 5점 만점 기준으로 모든 AI 모델이 3점 이상을 기록했으며, 특히 답변이 얼마나 포괄적인지, 얼마나 폭넓은 내용을 다루는지, 전체적인 품질에서 더 큰 차이를 보였다.

연구진은 ChatGPT-3.5와 사람, ChatGPT-4와 사람이라는 두 가지 비교 조건으로 실험을 설계했으며, 맥네마 검정이라는 통계 기법을 사용해 결과의 신뢰성을 확보했다. 참가자들은 사람 답변의 좋은 점으로 “교과서 같은 설명보다는 실제 경험담”과 “자연스러운 말투”를 꼽았지만, “깊이와 충분한 정보가 부족하다”, “번호나 목록 없이 정리가 안 되어 있다” 등의 아쉬운 점을 지적했다.

흥미롭게도 두 챗GPT 모델은 서로 다른 강점을 보였다. ChatGPT-3.5는 포괄성, 폭넓음, 깊이에서 ChatGPT-4보다 높은 평가를 받았는데, 참가자들은 “다양한 가능성을 다루고 각각의 장점을 제시한다”며 “구조화된 상세 설명을 제공한다”고 평가했다. 반면 ChatGPT-4는 주제에 집중하는 정도, 명확함, 실제로 활용할 수 있는 정도에서 더 좋은 평가를 받았다. 참가자들은 ChatGPT-4가 “주제에 집중하고 답변 구조가 더 좋아서 이해하기 훨씬 쉽다”며 “대안적 시각적 단서를 제시한다”고 말했다.

좋은 답변을 만드는 12가지 핵심 요소 발견

연구진이 엘라스틱 넷 회귀분석이라는 통계 기법을 사용해 사용자가 선호하는 답변의 12가지 핵심 요소를 찾아냈다. 이 분석 방법은 여러 요소들 간의 상관관계로 인한 오류를 줄이기 위해 선택되었다. 연구진은 전체적인 선호도를 분석하는 모델과 각 답변 제공자별 선호도를 분석하는 모델, 두 가지를 모두 실시했다.

분석 결과 답변이 얼마나 포괄적인지와 주제에 얼마나 집중하는지가 가장 중요한 요인으로 나타났다. 이는 사용자들이 질문에 대한 완전하고 정확한 피드백을 원한다는 것을 의미한다. 지식 유형별로는 서로 다른 것들을 비교하거나 발표용 자료를 만드는 것 같은 고급 수준의 조언이 더 선호되었다.

설명 방식에서는 구체적인 예시와 비유가 포함된 답변이 더 유용하다고 평가되었다. 각 답변 제공자별로 살펴보면, ChatGPT 모델들은 포괄성과 폭넓음에서 강한 연관성을 보였고, ChatGPT-4와 사람은 명확함과 깊이에서 품질과 밀접한 관련을 보였다. 흥미롭게도 일부 특성들은 통계적으로 유의미하지 않은 것으로 나타나, 모든 요소가 품질에 영향을 주는 것은 아님을 보여줬다.

FAQ

Q: 챗GPT가 데이터 시각화 조언에서 인간보다 나은 이유는 무엇인가요?

A: 챗GPT는 범위와 폭 측면에서 강점을 보이며, 기술적이고 작업 지향적인 시각화 피드백에 중점을 둡니다. 또한 일관된 구조와 명확한 설명을 제공하여 전체적인 품질이 높게 평가됩니다.

Q: ChatGPT-4와 ChatGPT-3.5의 차이점은 무엇인가요?

A: ChatGPT-4는 인간과 더 유사한 응답 스타일을 보이며, 주제성과 명확성에서 우수합니다. ChatGPT-3.5는 더 상세한 설명을 제공하여 범위와 깊이 측면에서 강점을 보입니다.

Q: 인간 전문가만의 고유한 장점은 무엇인가요?

A: 인간은 도메인별 문제 지식과 경험적 통찰력, 단계별 지침 제공, 이론적 프레임워크 참조에서 여전히 AI보다 우수한 성과를 보입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: Understanding Why ChatGPT Outperforms Humans in Visualization Design Advice

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.