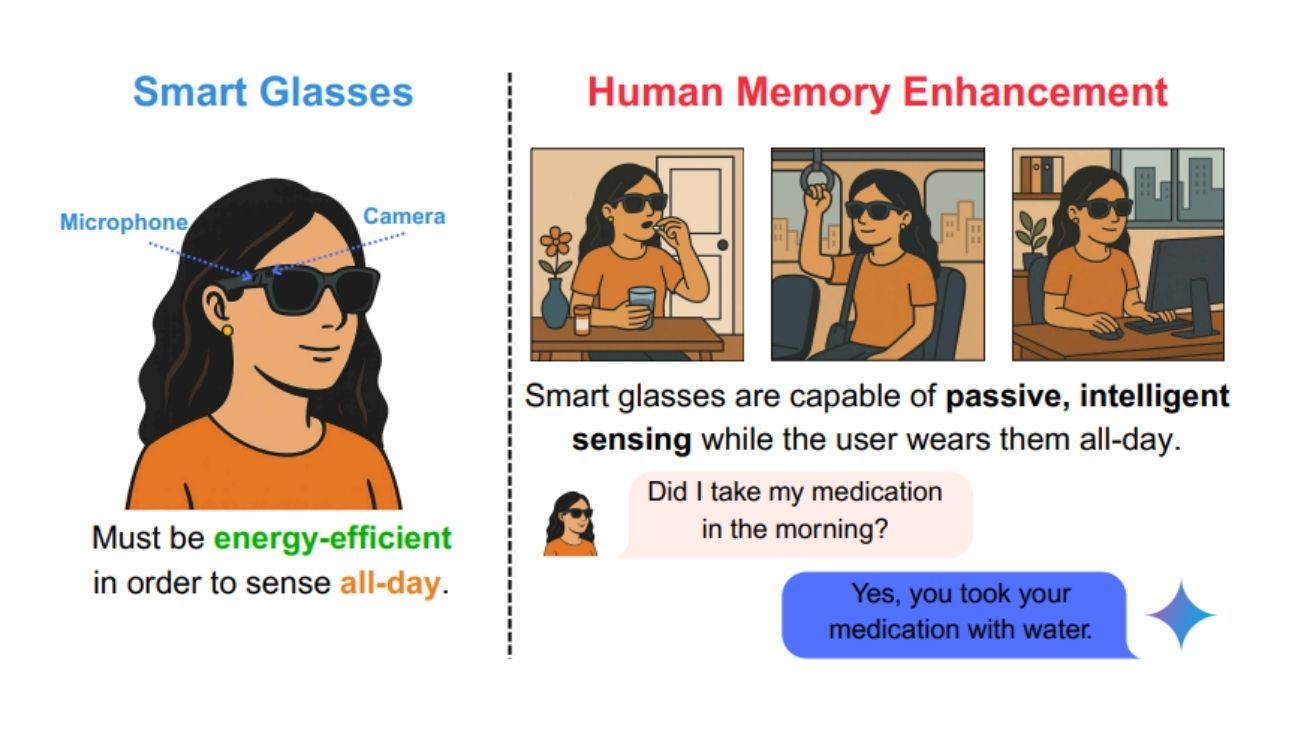

구글과 미국 노스캐롤라이나 대학교 연구진이 스마트 안경의 가장 큰 문제인 배터리 부족을 해결할 새로운 기술을 만들었다. ‘에고트리거(EgoTrigger)’라는 이름의 이 기술은 사람이 손으로 물건을 만질 때 나는 소리를 인공지능이 알아듣고, 그때만 카메라를 켜서 영상을 찍는 방식으로 작동한다. 구체적으로는 약통을 여는 소리, 서랍을 여닫는 소리, 물건을 집는 소리, 키보드를 타이핑하는 소리, 손을 씻는 소리, 종이에 글을 쓰는 소리 같은 일상적인 행동 소리를 마이크가 실시간으로 듣고 있다가 인공지능이 “지금이 중요한 순간이다”라고 판단하면 카메라가 자동으로 켜진다.

시스템은 연속적인 오디오 스트림을 짧은 구간으로 나누어 분석하며, 두 가지 제어 전략을 사용한다. 하나는 소리를 감지하면 정해진 시간 동안만 카메라를 켜는 고정 시간 방식이고, 다른 하나는 더 정교한 히스테리시스 방식으로 카메라를 제어한다. 평상시에는 카메라를 끄고 있다가 필요할 때만 작동시키기 때문에 배터리를 크게 아낄 수 있다. 이렇게 찍은 영상은 나중에 “내가 약을 먹었나?” “열쇠를 어디에 뒀지?” 같은 질문에 답해주는 기억 보조 역할을 한다.

영상 양을 절반 이상 줄여도 기억 도우미 기능은 그대로

연구진이 실험한 결과 에고트리거는 일반적인 방법보다 평균 54%나 적은 영상을 찍으면서도 사용자의 기억을 도와주는 성능은 거의 같았다. 연구진이 만든 HME-QA 실험에서 계속 영상을 찍는 방법이 77.3%의 정답률을 보인 반면, 에고트리거는 75.7%로 단 1.7%만 낮았다. 더 큰 규모의 QA-Ego4D 데이터셋에서도 41.08% 대 40.1%로 비슷한 성능을 확인했다.

기존에 사용하던 단순한 방법인 ‘일정 시간마다 영상 찍기’와 비교하면 차이가 더 확실했다. 이 방법은 79.5%의 영상을 줄였지만 정답률이 71.9%로 크게 떨어졌다. 반면 에고트리거는 적당히 영상을 줄이면서도 높은 성능을 유지했다. 특히 영상 데이터 전송량도 절반 수준으로 감소했다. HME-QA에서 기존 방식의 절반 정도인 비트레이트를 기록해 무선 전송에 드는 전력도 크게 줄일 수 있었다. 연구진은 데이터에서 손-물체 상호작용 소리가 많아 생기는 편향 문제를 해결하는 기술적 방법도 함께 적용했다.

연구진은 “손으로 물건을 만지는 순간이 우리 기억에 가장 중요한 순간”이라며 “이런 순간만 골라서 촬영하기 때문에 효율적”이라고 설명했다.

실제 기기에서 전력 사용량 17% 줄어

연구팀은 실제로 전력 소비가 얼마나 줄어드는지 확인하기 위해 작은 컴퓨터와 카메라, 마이크를 조합한 실험용 기기를 만들어 테스트했다. 그 결과 에고트리거를 사용했을 때 계속 영상을 찍는 방법보다 17.3%의 전력을 절약할 수 있었다.

구체적으로 각 구성요소별 전력 소비를 분석해보면, 시스템 전체, 마이크, 카메라 등 각 부품이 소모하는 전력을 세밀하게 측정했다. 아무것도 하지 않을 때는 2.37W, 에고트리거 사용 시 4.11W, 계속 촬영할 때는 4.97W의 전력이 필요했다. 더 중요한 것은 54%나 적은 영상 데이터로 인해 무선으로 영상을 전송할 때 드는 전력도 크게 줄일 수 있다는 점이다. 계속 무선 전송을 하면 5.51W가 필요하지만, 필요한 순간에만 전송하면 전체 전력 사용량을 훨씬 줄일 수 있다.

연구진은 또한 스마트폰 등 작은 기기에서도 쓸 수 있도록 프로그램 크기를 대폭 줄이는 모델 최적화 기술도 개발했다. 실제 스마트 안경용 전용 칩에서는 더욱 효율적으로 작동할 것으로 예상된다고 밝혔다.

새로운 실험용 영상 자료도 함께 공개

연구진은 이번 연구와 함께 ‘HME-QA’라는 새로운 실험용 영상 자료를 만들어 공개했다. 이 자료는 50개의 긴 영상과 340개의 질문-답변으로 구성되어 있다. 각 영상은 평균 12분 길이이고, 어떤 것은 30분까지 이어진다.

자료 제작 과정은 매우 까다로웠다. 처음에는 82개 영상에서 시작했지만 실제 오디오가 깨끗하게 들어있는 50개만을 최종 선별했다. 구글의 제미나이(Gemini) AI가 초기 질문-답변을 만들고, 1인칭 시점 영상 데이터 전문가가 하나하나 검토해서 품질이 낮은 것들은 제거하는 방식으로 진행됐다.

기존에 사용하던 QA-Ego4D 자료의 40%가 소리가 없어서 소리와 영상을 함께 연구하기 어려웠던 문제를 해결하기 위해, 새로운 자료는 모든 영상에 깨끗한 소리가 들어있도록 만들었다. 이렇게 해서 다른 연구자들도 소리와 영상을 함께 분석하는 연구를 할 수 있게 되었다.

FAQ

Q: 에고트리거 기술로 스마트 안경을 하루 종일 사용할 수 있나요?

A: 에고트리거는 영상을 54% 줄여서 카메라와 무선 전송에 드는 전력을 크게 아낍니다. 실제 실험에서 17.3%의 전력 절약 효과를 확인했고, 특히 무선으로 영상을 계속 보낼 때 드는 높은 전력을 대폭 줄일 수 있어서 하루 종일 쓸 수 있는 스마트 안경 개발에 도움이 될 것입니다.

Q: 손으로 물건 만지는 소리만 듣고 중요한 순간을 놓치지 않을까요?

A: 연구진 실험 결과 에고트리거는 주변 소음이 있어도 잘 작동했습니다. 다양한 환경 소음을 담은 자료로 테스트했을 때 7.1%의 낮은 오류율을 보였고, 소음이 있는 환경에서도 좋은 성능을 유지했습니다. 실제 영상에서도 1분당 평균 2.4번만 잘못 작동해서 실용적인 수준입니다.

Q: 이 기술이 실제 스마트 안경 제품에 언제쯤 들어갈 수 있나요?

A: 에고트리거는 이미 스마트폰 같은 기기에서 쓸 수 있도록 최적화되어 평균 12.29밀리초(0.01초 정도)의 빠른 속도로 작동합니다. 프로그램 크기도 86% 줄여서 23.60MB에서 3.77MB로 작아졌습니다. 스마트 안경 전용 부품에서 더 최적화하면 곧 상용화가 가능할 것으로 보입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: EgoTrigger: Toward Audio-Driven Image Capture for Human Memory Enhancement in All-Day Energy-Efficient Smart Glasses

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.