AI 챗봇이 그럴듯하게 들리지만 틀린 정보를 말하는 문제가 심각해지고 있다. 실제로 구글의 AI가 공개 시연에서 틀린 정보를 말해 회사 주가가 1000억 달러나 떨어진 사건이 있었고, 에어캐나다는 AI 챗봇이 제공한 거짓 정보 때문에 소송까지 당했다.

미국의 정보기술 기업인 IBM의 연구진이 22개국 출신 148명을 대상으로 총 592개 과제를 수행한 대규모 실험 결과, AI가 틀린 정보를 빨간색으로 표시해서 “이건 틀릴 수 있어요”라고 알려주는 것보다, 아예 그 부분을 지워버리거나 애매하게 바꿔서 말하는 것이 사용자들이 AI를 더 믿게 만든다는 사실을 발견했다. 참가자들은 소프트웨어 개발자 50명, 엔지니어 26명, 영업직 21명, 디자이너 15명 등 다양한 직업군으로 구성됐다. 이는 기존에 “투명하게 모든 정보를 공개해야 한다”는 AI 설계 원칙과는 정반대의 결과다.

평균 153단어 답변 중 43%가 틀린 정보인 상황에서 5가지 실험

연구진은 AI가 답변할 때 틀릴 수 있는 내용을 어떻게 처리하는지에 따라 5가지 방법을 비교했다. 실험에는 평균 153.5단어, 7.5문장으로 구성된 AI 답변이 사용됐고, 각 답변에는 평균 34개의 사실이 포함됐는데 이 중 14.75개(43%)가 틀린 정보였다.

첫 번째는 아무 표시 없이 그냥 답변하는 기본 방식이다. 두 번째는 틀릴 가능성이 높은 부분을 주황색으로 칠해서 “이 부분은 의심스러워요”라고 알려주는 투명 방식이다. 주황색을 선택한 이유는 사전 인터뷰에서 참가자들이 “주황색은 일반적으로 뭔가 잘못되었다는 것을 나타낸다”고 답했기 때문이다. 세 번째는 반대로 확실한 부분만 파란색으로 칠해서 강조하는 주목 방식이다. 네 번째는 틀릴 수 있는 부분을 아예 지우고 ‘[..]’ 표시만 남기는 삭제 방식이고, 다섯 번째는 틀린 내용을 애매한 표현으로 바꾸는 모호 방식이다.

실험은 기자가 인물 전기를 쓰는 상황으로 설정됐고, 참가자들에게 위키피디아를 참고 자료로 제공했다. 실험 결과 삭제 방식과 모호 방식을 쓴 그룹에서 사용자들이 AI를 가장 많이 신뢰했다.

IBM 그래나이트 모델이 최고 성능… 6가지 패턴으로 모호화 구현

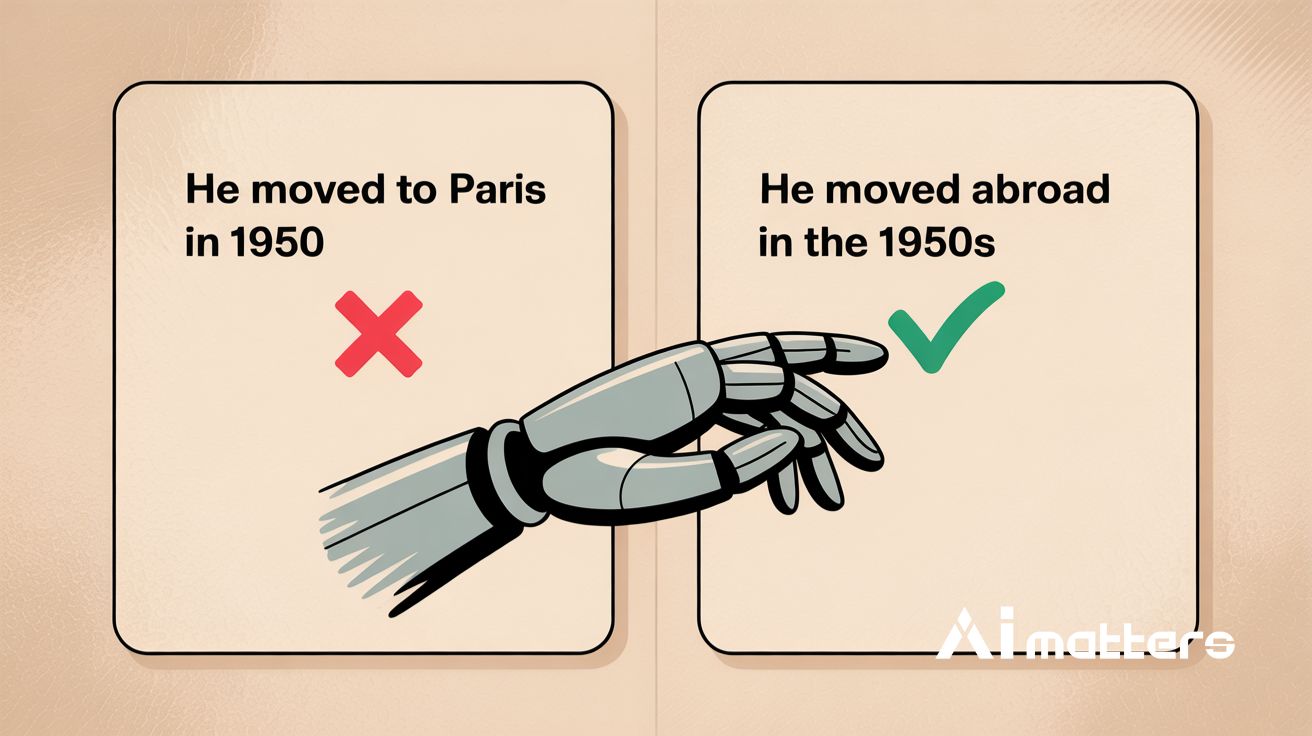

이번 연구에서 가장 주목받는 것은 ‘모호 방식’이라는 새로운 기법이다. 예를 들어 AI가 “그는 1950년에 파리로 이주했다”라고 틀린 정보를 말하려고 하면, 이를 “그는 1950년대에 다른 나라로 이주했다”로 바꿔서 말하는 것이다. 틀린 정보를 완전히 지우는 대신 틀리지 않을 정도로만 애매하게 만드는 방식이다.

연구진은 이를 위해 7개 언어모델과 5가지 프롬프트를 비교 실험했고, IBM의 그래나이트(Granite) 모델이 최고 성능을 보였다. 구현 과정은 3단계로 이뤄진다. 먼저 AI가 말하려는 내용을 작은 사실 단위로 쪼개고, 각각이 맞는지 틀리는지 판단한 다음, 틀린 부분만 애매한 표현으로 바꿔서 다시 하나의 문장으로 합치는 과정이다.

모호화 작업에는 6가지 패턴이 사용됐다. 범위 확대(뉴욕 → 미국), 불명확화(일부 사람들, 전문가들, 많은 사람들), 완곡어법(은퇴 → 물러나다), 근사치(2004년 → 2004년경, 2000년대), 수동 구문(믿어진다, 여겨진다), 부사 사용(종종, 아마도) 등이다. 기술의 불완전함 때문에 연구진이 최종 결과물을 손수 편집하는 과정도 거쳤다.

“AI가 왜 자기 실수를 강조하나”… 참가자 사전 인터뷰에서 나온 솔직한 반응

지금까지 AI 업계에서는 “사용자가 AI를 제대로 이해하려면 모든 정보를 투명하게 공개해야 한다”는 원칙이 지배적이었다. 틀릴 수 있는 정보라도 표시를 해서 사용자에게 알려주는 것이 좋다고 여겨졌다. 하지만 이번 연구는 이런 생각이 틀렸을 수 있음을 보여준다.

연구진이 6명을 대상으로 한 사전 인터뷰에서 참가자들은 “AI가 왜 자기 실수를 굳이 강조해서 보여주는지 모르겠다”며 “차라리 안 보여주는 게 낫겠다”고 답했다. 사람끼리 대화할 때도 거짓말이라고 생각하는 내용은 아예 말하지 않는 것이 신뢰 관계에 도움이 된다는 기본 원리를 AI에도 적용한 것이다.

특히 맞는 부분만 파란색으로 강조하는 주목 방식은 오히려 사용자들의 기대치를 너무 높여서 부작용을 낳는 것으로 나타났다. 과도한 강조가 사용자 인식을 조작하려는 시도로 받아들여져 부정적인 반응을 불러일으켰다. 흥미롭게도 참가자들이 위키피디아 참고 자료를 클릭하는 비율에는 5가지 방식 간에 유의미한 차이가 없었다. 이는 단순히 틀릴 수 있는 정보를 알려주는 것만으로는 사용자들이 정보를 검증하려는 행동을 하지 않는다는 의미다.

FAQ

Q: AI가 정보를 숨기면 사용자가 속는 거 아닌가요?

A: 연구진은 완전히 틀린 정보를 감추거나 애매하게 바꾸는 것이므로 사용자를 속이는 것이 아니라고 설명합니다. 오히려 확실하지 않은 세부사항을 제거해서 전체적으로 더 정확한 정보를 제공하는 방식입니다.

Q: 정보를 지우면 답변이 부실해지지 않나요?

A: 실험 결과 사용자들은 일부 정보가 지워진 답변도 완전성이나 일관성 면에서 다른 방식과 비슷하게 평가했습니다. 잘 모르는 주제에 대해서는 일부 정보가 없어도 전체 답변 품질에 큰 영향을 주지 않는다는 뜻입니다.

Q: 이런 방식을 실제 서비스에 적용할 때 주의할 점은?

A: 의료나 법률처럼 정확성이 생명인 분야에서는 신중하게 써야 합니다. 또한 AI가 정확도를 판단하는 것 자체가 완벽하지 않아서 실제로는 맞는 정보를 잘못 숨길 위험도 있습니다. 필요할 때 숨겨진 정보를 볼 수 있는 기능을 추가하는 것도 좋은 방법입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: Hide or Highlight: Understanding the Impact of Factuality Expression on User Trust

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.