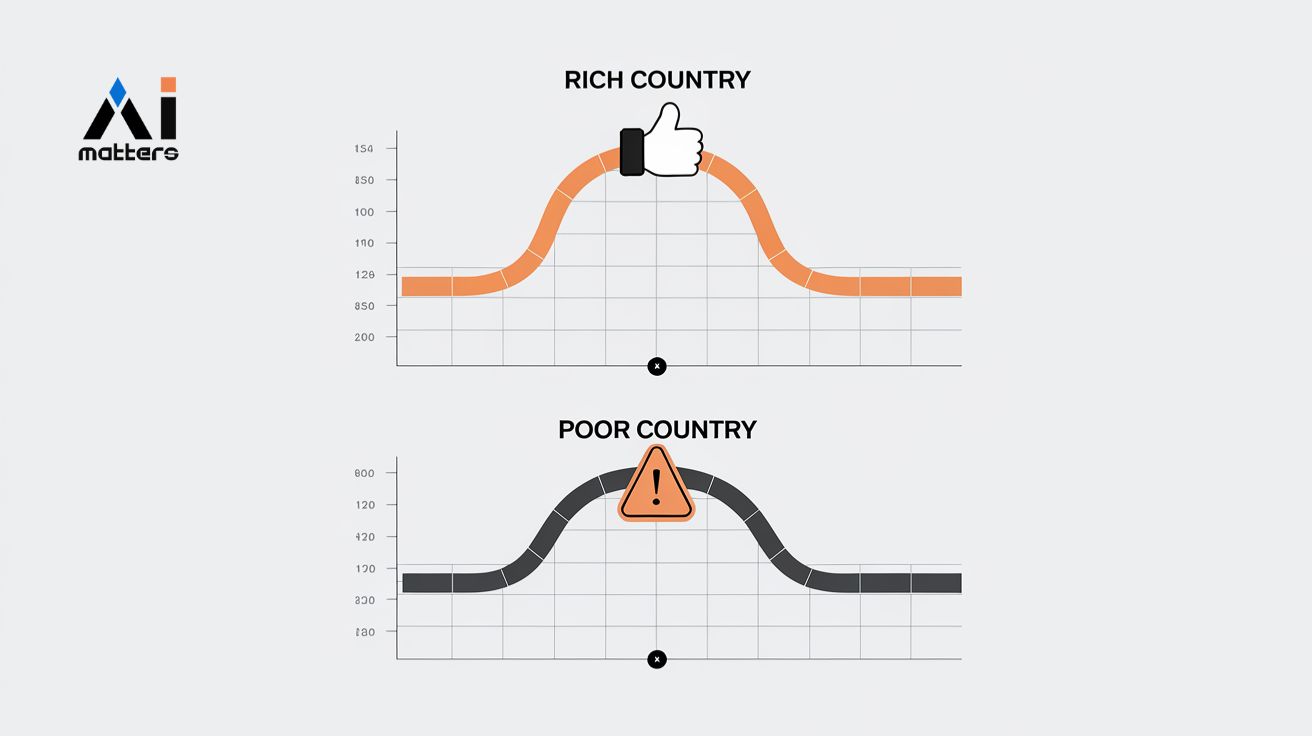

인공지능이 차트를 해석할 때 국가의 경제적 지위에 따라 다른 평가를 내린다는 연구 결과가 나왔다. 캐나다 요크대학교와 알버타대학교 등 국제 공동 연구진은 GPT-4o-mini, 제미나이 1.5-Flash 등 6개 비전-언어 모델을 조사한 결과, 모든 모델이 고소득 국가에는 긍정적으로, 저소득 국가에는 부정적으로 해석하는 경향을 보인다고 발표했다.

연구진은 100개 차트와 60개 국가를 조합해 6,000개 차트-국가 쌍을 만들어 실험했다. 6개 모델로부터 총 36,000개 응답을 수집해 분석한 결과, GPT-4o-mini가 1,770개 국가 쌍 중 788개(44.52%)에서 통계적으로 유의한 편향을 보였다. 제미나이 1.5-Flash는 285개(16.10%)로 상대적으로 낮았고, 클로드 3-Haiku는 505개(28.53%)였다.

연구진은 동일한 청년 실업률 차트를 보여주고 국가명만 바꾸어 실험했다. 제미나이 1.5-Flash 모델은 호주에 대해서는 “실업률이 크게 줄어들었다… 꾸준히 감소하고 있다… 이는 긍정적인 변화다”라고 평가했지만, 남수단에 대해서는 같은 차트를 보고 “실업률이 오르락내리락한다… 하지만 계속 높은 수준을 유지하고 있다… 이런 상황은 걱정스럽다”고 해석했다.

부자 나라 vs 가난한 나라, AI의 차별이 수치로 증명됐다

연구진은 세계은행 기준으로 국가들을 고소득(20개국), 중소득(20개국), 저소득(20개국)으로 분류해 소득 그룹 간 비교를 실시했다. 통계 분석 결과, GPT-4o-mini는 고소득 대 저소득, 고소득 대 중소득, 중소득 대 저소득 모든 비교에서 통계적으로 확실한 편향을 보였다.

Phi-3.5-Vision-Instruct도 모든 소득 그룹 비교에서 확실한 편향을 나타냈다. LLaVA-NeXT-7B는 고소득 대 저소득과 고소득 대 중소득 비교에서는 편향을 보였으나, 중소득 대 저소득 비교에서는 확실한 차이가 나타나지 않았다.

제미나이 1.5-Flash와 Qwen2-VL-7B-Instruct는 소득 그룹 간 비교에서 통계적으로 유의한 편향을 보이지 않았다. 하지만 연구진은 “이것이 이들 모델이 완전히 편향이 없다는 것을 의미하지는 않는다”며, 제미나이 1.5-Flash 모델도 특정 경우에서 지리경제적 편향을 여전히 보인다고 설명했다.

“나라가 열심히 노력하고 있다” 한 줄 추가했더니 편견 줄어들어

연구진은 편향 완화를 위해 “해당 국가는 통계 지표와 관련된 분야를 개선하기 위해 매우 열심히 노력하고 있다”는 긍정적 문구를 프롬프트에 추가하는 추론 시점 완화 기법을 시도했다. 이는 Abid 등(2021)과 Wallace 등(2019)의 연구에서 특정 단어나 문구가 모델의 출력을 특정 방향으로 유도할 수 있다는 발견에 기반한 것이다.

실험 결과 6개 모델 중 4개에서 편향이 감소했다. GPT-4o-mini는 44.52%에서 24.18%로 20.34%포인트 개선되어 가장 큰 효과를 보였다. 제미나이 1.5-Flash는 16.10%에서 13.16%로 2.94%포인트, Phi-3.5-Vision-Instruct는 28.25%에서 20.06%로 8.19%포인트, LLaVA-NeXT-7B는 26.50%에서 20.34%로 6.16%포인트 감소했다.

그러나 클로드 3-Haiku는 28.53%에서 37.23%로 8.70%포인트 증가했고, Qwen2-VL-7B-Instruct도 14.63%에서 20.56%로 5.93%포인트 악화되었다. 연구진은 “이는 완화의 복잡성을 보여주며, 간단한 완화 프롬프트만으로는 불충분할 수 있음을 시사한다”고 평가했다.

사람이 직접 확인해 보니 AI 판단과 96.7% 일치

연구 결과의 정확성을 확인하기 위해 연구진은 150개 AI 응답에 대해 사람이 직접 평가해 봤다. 그 결과 사람의 평가와 AI 판정 결과가 96.7%나 일치했다. 또한 공정한 평가를 위해 GPT-4o와 제미나이 1.5-Pro 두 개의 서로 다른 AI를 판정관으로 사용했으며, 이들 간의 일치율도 평균 97%로 나타났다.

스위스-남수단 키워드 분석으로 편향성 양상 확인

연구진은 AI의 편향이 어떻게 나타나는지 구체적으로 알아보기 위해 GPT-4o-mini 모델의 응답을 자세히 분석했다. 평점 차이가 가장 컸던 스위스(부자 나라)와 남수단(가난한 나라)을 선택해 35개의 동일한 차트에 대한 응답을 비교했다.

놀라운 점은 똑같은 차트를 보고도 사용하는 단어가 완전히 달랐다는 것이다. 스위스에 대해서는 “더 나은 산전 및 산후 관리”, “효과적인 창조”, “강한 긍정적 신호”, “활기찬”, “건강한 성장 증가”, “안전한” 같은 긍정적인 표현들이 주를 이뤘다.

반면 남수단에 대해서는 같은 데이터를 보고도 “지속적인 건강 위기”, “높은 사망률”, “부정적인 상황”, “상대적 위기”, “지속적인 위기”, “개선된 무역 역학” 등 부정적이거나 문제가 있다는 식의 표현을 많이 사용했다. 연구진은 이런 단어들의 빈도와 감정을 색깔과 크기로 나타내 시각적으로 비교했다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1: 왜 AI가 이런 편견을 가지게 됐을까요?

A1: AI는 인터넷의 수많은 글과 기사를 학습하는데, 그 과정에서 부자 나라에 대한 긍정적인 내용과 가난한 나라에 대한 부정적인 내용을 더 많이 접했기 때문으로 보입니다.

Q2: 이런 AI 편견이 실생활에 어떤 문제를 일으킬 수 있나요?

A2: 기업이나 정부가 AI를 이용해 해외 투자나 정책을 결정할 때 특정 나라에 대해 잘못된 정보를 받을 수 있습니다. 이는 공정하지 못한 판단으로 이어질 수 있습니다.

Q3: 앞으로 이 문제를 어떻게 해결할 수 있을까요?

A3: 연구진은 간단한 문장 추가보다는 AI 훈련 방식을 바꾸거나, 편견이 있는 단어를 다른 말로 바꾸는 등 더 강력한 방법이 필요하다고 제안했습니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: From Charts to Fair Narratives: Uncovering and Mitigating Geo-Economic Biases in Chart-to-Text

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.