프랑스 파리공과대학 연구소인 Hi!PARIS와 LIX, U2IS 등 3개 연구 기관 공동연구팀이 기존과 다른 새로운 가짜 영상 기술을 발견했다고 발표했다. 연구팀에 따르면 ‘페이크파츠(FakeParts)’라고 불리는 이 새 기술은 영상 전체를 새로 만드는 기존 방식과 달리 진짜 영상의 특정 부분이나 시간대만 바꾸는 방식을 사용한다.

연구 논문에 따르면, 실험 결과 이런 방식은 사람들이 가짜를 찾아내는 정확도를 기존 딥페이크 대비 30% 이상 떨어뜨리는 것으로 나타났다.

영상 일부만 조작하는 세 가지 방식 확인

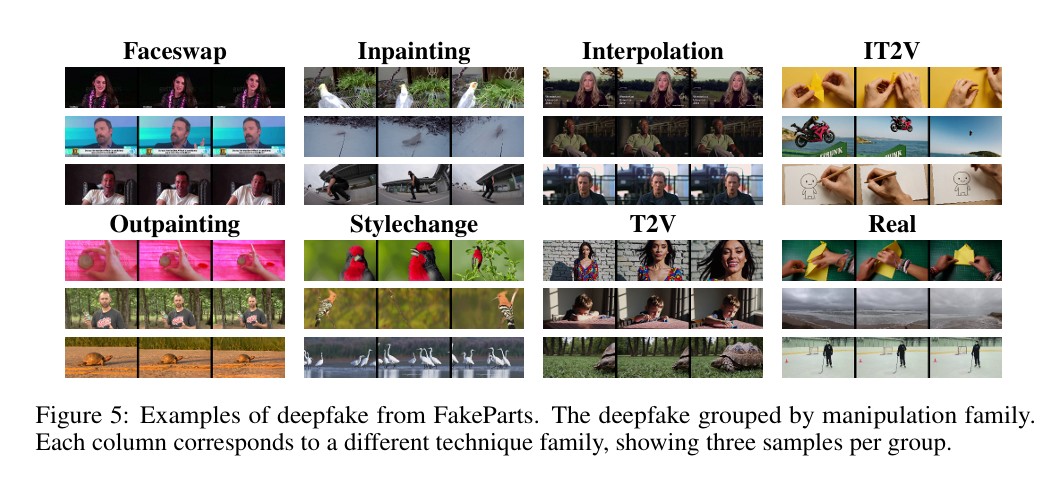

페이크파츠는 기존 딥페이크와 근본적으로 다른 접근법을 사용한다. 영상 전체를 새로 합성하는 대신 진짜 영상의 대부분을 그대로 두고 특정 부분만 미세하게 바꾼다. 연구팀은 페이크파츠를 세 종류로 분류했다.

공간적 페이크파츠는 얼굴 바꾸기, 물체 제거, 배경 확장 등 특정 영역을 조작한다. 시간적 페이크파츠는 프레임 보간을 통해 시간축을 따라 내용을 수정한다. 스타일 페이크파츠는 구조는 그대로 두고 색상이나 시각적 스타일만 변경한다.

연구팀의 사용자 실험에서는 60명 이상이 참가했고, 약 1600개의 판정 결과를 수집했다. 그 결과 사람들의 평균 정확도는 75.3%로 나타났다.

2만5천개 영상 담은 세계 첫 페이크파츠 전용 데이터

연구팀은 페이크파츠 연구를 위해 ‘페이크파츠벤치’라는 대규모 벤치마크 데이터셋을 구축했다. 이는 부분 조작 딥페이크를 다루는 세계 최초의 전용 데이터셋이다. 2만 5천개 이상의 영상과 픽셀 및 프레임 단위의 세밀한 조작 표시를 포함한다.

데이터셋에는 소라(Sora), 비오2(Veo2), 알레그로(Allegro) 등 최신 오픈소스와 상업용 모델 9개로 만든 영상들이 들어있다. 대부분 5초 이상 길이이며 고화질로 제작됐다. 진짜 영상 1만 6천개와 가짜 영상 2만 5천개로 구성됐다.

AI 탐지 프로그램들, 페이크파츠 앞에서 최대 77% 성능 저하

연구팀이 현재 최고 수준의 가짜 영상 탐지 모델들을 시험한 결과, 모든 모델이 페이크파츠에서 심각한 성능 저하를 보였다. 전체적으로 67.4%에서 99.6%까지 성능이 떨어졌다.

특히 흥미로운 점은 모델 유형별로 다른 패턴을 보였다는 것이다. CLIP 같은 파운데이션 모델 기반 탐지기들은 미세한 조작에서는 상대적으로 나은 성능을 보였지만, 고품질 완전 합성 영상에서는 어려움을 겪었다. 반면 전통적인 탐지 모델들은 완전 합성 영상은 어느 정도 찾았지만 부분 조작에서는 크게 뒤처졌다.

연구팀은 이를 ‘특성 의존성 트레이드오프’ 현상으로 설명했다. 전통적인 모델들은 저수준 주파수 인공물에 크게 의존하는데, 이런 신호는 도메인 변화나 전처리 과정에서 쉽게 사라진다. 반면 CLIP 기반 모델들은 의미적 수준 표현을 활용해 다양한 페이크파츠 카테고리에서 더 강한 성능을 보인다.

미세한 조작일수록 탐지 더 어려워

연구 결과에서 주목할 점은 조작의 미묘함과 탐지 난이도가 반비례 관계를 보인다는 것이다. 가장 작은 변화가 오히려 가장 믿을 만한 속임수를 만들어낸다. 이는 최대한의 진짜 맥락을 보존하면서 중요한 의미적 요소만 바꾸기 때문이다.

인간 실험에서도 스타일 변경처럼 명확한 변화는 98.3%의 높은 탐지율을 보인 반면, 인페인팅이나 아웃페인팅 같은 미세한 조작에서는 58.8%와 80%의 상대적으로 낮은 탐지율을 기록했다.

연구팀은 “페이크파츠는 현재 딥페이크 탐지 접근법의 심각한 취약점을 드러냈으며, 더욱 견고한 방어 기술 개발이 시급하다”고 결론지었다.

FAQ ( ※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q: 페이크파츠가 기존 딥페이크와 어떻게 다른가요?

A: 기존 딥페이크는 영상 전체를 새로 만들거나 얼굴을 통째로 바꿉니다. 페이크파츠는 진짜 영상의 특정 부분이나 시간대만 조작해서 대부분이 진짜이기 때문에 훨씬 자연스럽고 탐지하기 어렵습니다.

Q: 어떤 종류의 조작이 가장 위험한가요?

A: 연구에 따르면 미세한 조작일수록 더 위험합니다. 물체를 지우거나 배경을 늘리는 등의 작은 변화는 사람들이 58.8%-80% 정도만 구별해낼 수 있어 매우 위험합니다.

Q: 현재 AI 탐지 기술로는 이런 조작을 막을 수 있나요?

A: 연구 결과 현재 최고 수준의 AI 탐지 모델들도 페이크파츠 앞에서는 성능이 최대 99.6%까지 떨어졌습니다. 새로운 탐지 기술 개발이 시급한 상황입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문명: FakeParts: a New Family of AI-Generated DeepFakes

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.