마이크로소프트(Microsoft) 연구팀이 개발한 작은 AI 모델이 훨씬 큰 AI 모델을 이기는 놀라운 결과를 만들어냈다. 마이크로소프트 연구소의 닝 샹(Ning Shang), 이페이 리우(Yifei Liu), 이 주(Yi Zhu), 리 리나 장(Li Lyna Zhang) 등 연구진이 개발한 ‘rStar2-Agent’는 14B 크기임에도 불구하고 671B 크기의 딥시크-R1(DeepSeek-R1)보다 수학 문제를 더 잘 푸는 것으로 나타났다.

510번만 학습해도 80.6% 정답률 달성, 여러 AI 모델 제쳤다

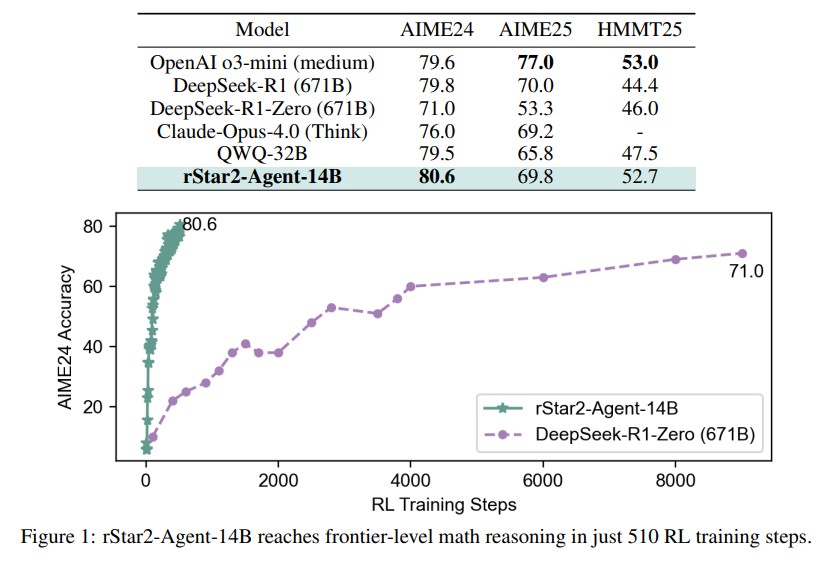

연구진이 발표한 논문에 따르면, rStar2-Agent는 수학 경시대회 문제로 유명한 AIME24에서 80.6%의 정답률을 기록했다. 이는 오픈AI의 o3-mini 79.6%보다 1.0% 높고, 딥시크-R1 79.8%보다 0.8% 높으며, 클로드 오푸스 4.0 76.0%보다 4.6% 높은 점수다. AIME25에서도 69.8%를 기록했다.

특히 학습 과정이 매우 효율적이었다. 기존 AI들이 수천 번의 학습을 거쳐야 하는 것과 달리, rStar2-Agent는 단 510번의 강화학습 단계만으로 최고 수준에 도달했다. 64개의 MI300X GPU를 사용해 1주일 만에 훈련을 마쳤다.

파이썬 프로그래밍으로 스스로 답 확인하는 새로운 학습 방법

rStar2-Agent의 가장 큰 특징은 파이썬 프로그래밍 도구를 활용해 문제를 해결한다는 점이다. 기존 AI들이 내부적인 사고 과정에만 의존했다면, 이 AI는 실제로 파이썬 코드를 작성하고 실행해 결과를 확인하며 추론한다.

연구진은 이를 “더 오래 생각하기”를 넘어 “더 똑똑하게 생각하기”라고 표현했다. AI가 파이썬의 Numpy, Scipy, SymPy 같은 과학 계산 라이브러리를 사용해 수치 계산, 과학 분석, 기호 수학을 처리할 수 있다.

AI가 문제를 풀 때는 여러 차례에 걸쳐 코드를 실행한다. 첫 번째 차례에서 초기 추론을 하고 코드를 실행한 후, 그 결과를 바탕으로 다음 차례의 추론을 진행한다. 코드 실행 중 오류가 발생하면 오류 메시지를 분석해 수정하거나 다른 접근법을 시도한다.

4만 5천 개 작업 동시 처리하는 코드 실행 환경 구축

연구진은 대규모 학습을 위해 강력한 컴퓨터 시스템을 구축했다. 하나의 학습 과정에서 수만 개의 코드가 동시에 실행되는데, 이를 처리하기 위해 최대 4만 5천 개의 동시 도구 호출을 처리할 수 있는 환경을 만들었다.

시스템은 마스터 노드에서 32개의 전송 작업자가 중앙 작업 대기열을 관리하고, 여러 작업자 노드에서 각각 1,024개의 실행 작업자가 실제 코드를 실행한다. 코드 실행 요청부터 결과 확인까지 평균 0.3초가 걸린다.

또한 각 GPU의 KV 캐시 용량에 따라 작업을 동적으로 할당하는 로드밸런싱 시스템을 개발했다. 이를 통해 GPU들이 고르게 일하도록 해서 전체 훈련 효율을 높였다.

수학 학습으로 과학 추론 능력까지 향상

rStar2-Agent는 수학 데이터로만 학습했지만 다른 분야에서도 좋은 성능을 보였다. 과학 추론 문제인 GPQA-Diamond에서 42.1%에서 60.9%로 성능이 향상돼 딥시크-V3의 59.1%를 1.8% 앞섰다.

연구진은 수학에서 배운 추론 패턴이 일반적인 과학 추론으로 효과적으로 전이된다고 분석했다. 도구 사용 평가인 BFCL v3에서도 60.8%의 성과를 기록했으며, 일반적인 정렬 작업에서는 기존 성능을 유지했다.

AI가 스스로 실수를 찾아 고치는 과정 발견

연구진이 AI의 사고 과정을 분석한 결과, 흥미로운 현상을 발견했다. AI가 어려운 판단을 내릴 때 특별한 패턴의 단어들이 나타난다는 것이다. 연구진은 이를 ‘고엔트로피 토큰’이라고 불렀는데, AI가 확신하지 못할 때 나오는 단어들이다.

이런 단어들은 주로 두 가지 상황에서 나타났다. 첫째는 AI가 스스로를 의심하고 다시 검토할 때다. “하지만”, “다시 확인해 보자” 같은 표현이 여기에 해당한다. 둘째는 코드 실행 결과를 받은 후 그 내용을 분석할 때다. 코드에서 오류가 발생하면 AI는 그 오류 메시지를 꼼꼼히 살펴보고 어떻게 고칠지 고민한다.

특히 AI가 코드 오류를 만났을 때의 행동이 인상적이었다. 단순히 포기하지 않고 오류의 원인을 분석해서 새로운 코드를 작성했다. 이는 사람이 프로그래밍할 때 오류를 디버깅하는 과정과 매우 유사했다. 연구진은 이런 행동이 기존 AI들에서는 볼 수 없었던 새로운 형태의 사고 능력이라고 평가했다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q: 작은 AI가 큰 AI보다 좋을 수 있나요?

A: AI의 성능은 단순히 크기만으로 결정되지 않습니다. rStar2-Agent는 파이썬 프로그래밍 도구를 활용해 답을 검증하고 수정하는 효율적인 방법으로 학습해서 큰 모델보다 더 정확한 답을 찾을 수 있게 됐습니다.

Q: 이 AI는 어떻게 코드를 사용해서 문제를 푸나요?

A: AI가 수학 문제를 풀 때 파이썬 코드를 작성해서 계산을 검증하고, 오류가 나면 그 결과를 분석해서 더 나은 방법을 찾습니다. 마치 사람이 계산기를 사용해서 답을 확인하는 것과 비슷합니다.

Q: 이 기술이 실제로 어떻게 활용될 수 있을까요?

A: 적은 컴퓨터 자원으로도 고성능을 낼 수 있어서 비용 효율적입니다. 특히 복잡한 수학이나 과학 계산이 필요한 분야에서 AI가 더 정확하고 효율적으로 도움을 줄 수 있을 것입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문명: rStar2-Agent: Agentic Reasoning Technical Report

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.