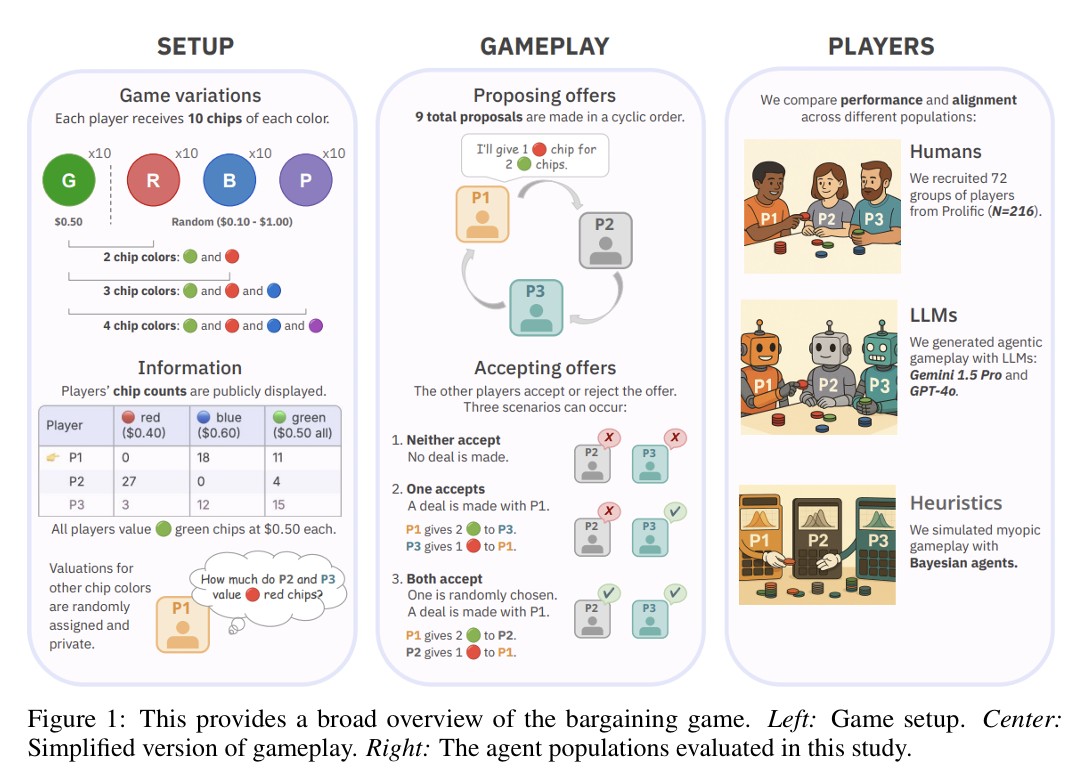

구글 딥마인드와 MIT 연구진이 AI가 인간과 대화형 AI를 상대로 거래 협상에서 뛰어난 성과를 보인다는 연구 결과를 발표했다. 수학 기반 AI인 베이지안 에이전트는 이론적 최적값의 74%에 달하는 성과를 거뒀다. 이는 인간 참가자(60%)와 챗GPT-4o(69%)보다 높은 수치다. 하지만 AI마다 전혀 다른 방식으로 거래를 진행해 실제 활용 시 고려할 점들이 드러났다.

수학 기반 AI, 모든 게임 변형에서 최고 성과

연구진이 만든 3명이 참여하는 칩 거래 게임에서 베이지안 에이전트는 게임 종류에 따라 다른 성과를 보였다. 2가지 칩 게임에서 이론적 최적값의 74%를 얻었고, 3가지 칩 게임에서는 80%, 4가지 칩 게임에서는 73%를 기록했다. 모든 게임에서 인간(60%~54%)과 챗GPT-4o(69%~54%)보다 높은 점수를 얻었다.

베이지안 에이전트는 상대방이 각 칩을 얼마나 중요하게 생각하는지 추측하고 계속 정보를 업데이트하는 방식을 사용했다. 자신에게 유리한 거래만 제안하는 가치 추출 전략을 택했다. 주는 것보다 더 많이 받으려는 거래를 선호했고, 그래서 거절당하는 경우가 많았지만 성사된 거래에서는 높은 이익을 얻었다.

챗GPT는 인간 수준, 제미나이는 낮은 성과

대화형 AI 중에서는 챗GPT-4o가 인간과 비슷한 성과를 거뒀지만 방식은 완전히 달랐다. 챗GPT-4o는 2가지 칩 게임 69%, 3가지 칩 게임 62%, 4가지 칩 게임 54%를 기록했다. 반면 구글의 제미나이 1.5 프로는 각각 42%, 42%, 37%의 성과를 보였다.

대화형 AI들은 양보적 자세를 보이며 보수적이고 위험이 적은 거래를 선호했다. 받는 것보다 더 많이 주는 거래를 자주 제안했고, 상대방이 수락하는 비율이 높았다. 하지만 이런 방식은 전략적 예측 능력 부족으로 강제된 후회 행동을 더 많이 만들었다.

일반인 216명, 균형 잡힌 거래 방식 선택

Prolific을 통해 모집된 216명의 미국 일반인은 30분 동안 2번의 게임을 했고 평균 12.24달러를 받았다. 연구진은 모집에 특별한 자격 조건을 두지 않았다고 밝혔다. 참가자들은 균형 잡힌 거래를 선호하는 패턴을 보였다. 즉, 요구하는 칩과 비슷한 수의 칩을 주는 1:1 교환을 좋아했다.

게임 후 설문조사에서 참가자들은 공정성과 협력을 거래 결정의 중요한 요소로 언급했다. 인간의 제안은 베이지안 에이전트보다 최적이 아니었지만 상대방이 받아들이는 경우가 더 많았다.

비슷한 성과 뒤에 숨은 다른 접근 방식들

연구의 핵심 발견은 비슷한 전체 결과가 완전히 다른 행동 방식을 가릴 수 있다는 점이다. 인간과 대화형 AI가 특정 조건에서 비슷한 전체 성과를 거뒀지만, 그 과정은 완전히 달랐다. 인간은 공정성을 고려한 양보를 했고, 대화형 AI는 합의 중심적인 거래를 선호했다. 베이지안 에이전트는 최적의 제안을 더 많이 했지만 동시에 가장 많이 거절당했다.

연구진은 “성과 동등성이 과정과 정렬에서의 근본적 차이를 가릴 수 있으며, 이는 실제 배치에서 중요하다”고 강조했다.

AI가 협상 테이블에 앉는 시대 올까

이번 연구는 단순한 성능 비교를 넘어 더 본질적인 질문을 던진다. AI가 공급망 계약 협상, 국제 무역 조정, 온라인 상거래 거래에서 활용되기 시작한 상황에서, 우리는 AI가 어떤 방식으로 협상하는지 제대로 알고 있었을까? 기존 AI 평가는 결과만 확인할 뿐 과정은 제대로 살펴보지 않았다. 하지만 이번 연구에서 드러났듯이 비슷한 성과 뒤에는 완전히 다른 접근 방식이 숨어있을 수 있다.

연구진은 “성과 동등성이 과정과 정렬의 근본적 차이를 가릴 수 있고, 이는 실제 배치에서 중요하다”고 강조했다. 베이지안 에이전트의 공격적 최적화, 대화형 AI의 과도한 양보, 인간의 공정성 추구는 각각 다른 상황에서 다른 결과를 가져올 수 있기 때문이다.

AI가 협상 테이블에 자리를 조금씩 차지하기 시작한 지금, 단순히 “AI가 더 나은 결과를 낸다”는 것만으로는 충분하지 않다. 어떤 방식으로 그 결과에 도달했는지, 그 과정이 우리가 받아들일 수 있는 것인지도 함께 고민해야 할 시점이다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q: 베이지안 에이전트가 가장 높은 성과를 낸 이유는 무엇인가요?

A: 이 거래 게임에 특화된 수학적 알고리즘으로 설계되어 수익 최대화에 집중했습니다. 상대방의 평가를 지속적으로 추론하고 업데이트해서 최적 거래를 찾아냈습니다.

Q: 대화형 AI가 양보적 방식을 택하는 이유는 무엇인가요?

A: 원문에서는 협력적 대화 훈련, 위험 회피 성향, 비대칭적 결과 회피 학습 등이 원인으로 분석된다고 밝혔습니다.

Q: 이 연구가 실제 AI 활용에 주는 의미는 무엇인가요?

A: AI 에이전트가 실제 협상에 사용될 때는 성과뿐만 아니라 협상 과정과 사회적 호환성도 함께 고려해야 한다는 점을 시사합니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문명: Understanding Economic Tradeoffs Between Human and AI Agents in Bargaining Games

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.