최근 몇 년 사이 인공지능(AI) 기술로 만든 ‘딥페이크(Deepfake)’ 이미지가 빠르게 퍼지고 있다. 특히 선거철이 되면 SNS를 통해 정치인을 둘러싼 가짜 사진이 확산되면서, 국민의 판단을 흐리고 사회 혼란을 일으킬 수 있다는 우려가 커지고 있다.

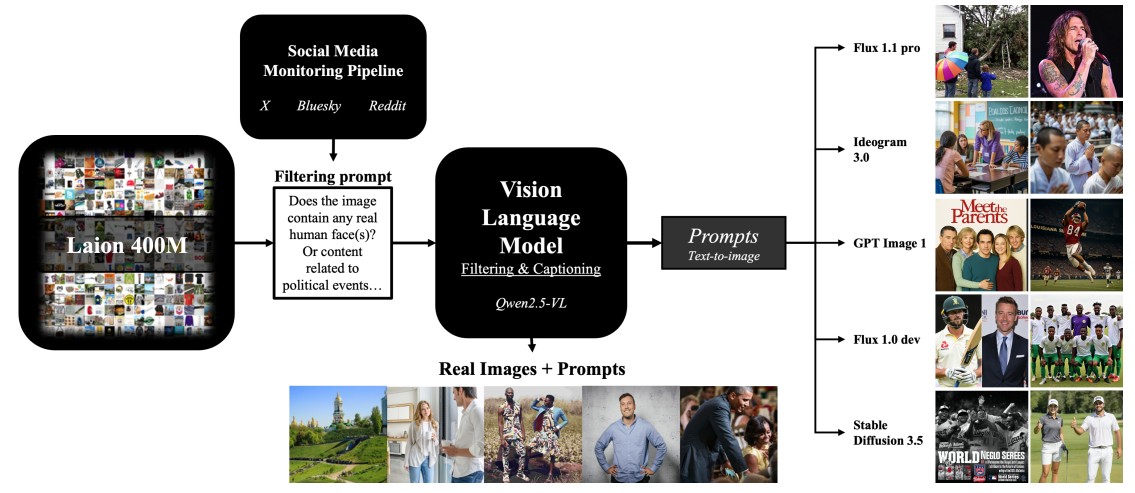

이런 상황에서 캐나다의 인공지능 연구소인 ‘밀라(Mila)’와 맥길대학교 연구진은 대규모 딥페이크 감지 데이터셋인 OPENFAKE를 공개했다. 이 데이터셋은 2025년 캐나다 총선 기간에 트위터(X), 레딧(Reddit), 블루스카이(Bluesky)에서 수집한 실제 정치 관련 사진 300만 장과, 그에 기반해 만든 가짜 이미지 96만 장을 포함하고 있다.

연구진은 실제 사진을 보고 자동으로 글을 뽑아낸 뒤, 이 문장을 AI 이미지 생성 모델에 입력해 가짜 이미지를 만들었다. 이렇게 하면 실제 상황을 흉내 낸 진짜 같은 가짜 이미지들이 만들어진다. 이 데이터를 바탕으로, 사람들이나 컴퓨터가 얼마나 가짜를 잘 구별하는지 테스트할 수 있다.

사람도 속는 가짜 이미지, AI는 더 속는다

연구진은 일반 시민 100명을 대상으로 실험을 진행했다. 참가자들은 진짜 사진 12장과 AI가 만든 가짜 이미지 12장을 보고 각각 진짜인지 가짜인지 맞히는 테스트를 받았다. 그 결과 구글의 이미지 생성 모델 ‘Imagen 3’로 만든 가짜 이미지는 사람들이 거의 절반(48.5%)만 맞히는 수준이었다. 오픈AI의 ‘GPT Image 1’ 역시 정확도가 낮아, 참가자 중 약 1/3이 가짜 이미지를 진짜로 믿었다.

특히 정치인 얼굴, 시위 현장, 재난 상황을 가짜로 표현한 이미지들이 많았는데, 일부는 시각적으로 어색했지만 여전히 사람들에게 강한 인상을 남겼다. 이처럼 실제처럼 보이는 가짜 이미지가 퍼지면, 국민은 잘못된 정보를 믿게 되고 여론이 조작될 위험이 커진다.

AI 탐지기, 구형 데이터로는 최신 가짜를 못 잡는다

연구진은 이런 가짜 이미지를 감지할 수 있는 AI 모델을 비교했다. 그 결과, 최근 데이터로 학습한 탐지 모델(SwinV2)은 최신 가짜 이미지도 거의 완벽하게 잡아냈다. 반면, 예전에 쓰이던 데이터로 학습한 모델들은 가짜를 잘 못 알아보거나, 오히려 진짜를 가짜로 착각하기도 했다.

특히 구형 AI 탐지기는 가짜 이미지가 너무 깨끗하다는 점을 보고 진짜와 구분하기도 했다. 그래서 연구진은 일부러 가짜 이미지에 화질 저하, 노이즈, 압축 등의 효과를 넣어 훈련시켰고, 그 결과 실제 상황과 유사한 환경에서도 높은 정확도를 유지했다.

누구나 참여하는 ‘딥페이크 게임’, 데이터도 계속 진화

연구진은 ‘OPENFAKE ARENA’라는 웹 플랫폼도 함께 만들었다. 이곳에서 누구나 AI로 가짜 이미지를 만든 후, AI 탐지기를 속일 수 있는지 실시간으로 도전할 수 있다. 탐지기를 속이는 데 성공하면 포인트를 얻고, 해당 이미지는 실제 데이터셋에 추가되어 AI 훈련에 사용된다. 예를 들어 한 참가자가 “폭풍이 치는 배경 앞에서 남성이 셔츠를 벗고 포즈를 취한 사진”이라는 주제로 이미지를 생성해 제출했는데, AI 탐지기가 이를 진짜로 오인해 포인트를 얻었다.

실시간 학습이 핵심인 새로운 딥페이크 탐지 패러다임

이번 연구에서 주목할 점은 딥페이크 탐지에서 ‘데이터 신선도’가 결정적 요소라는 사실이다. 구형 데이터로 학습한 모델들이 최신 가짜 이미지를 제대로 감지하지 못한 반면, 최근 데이터로 훈련한 SwinV2 모델은 거의 완벽한 성능을 보였다. 이는 딥페이크 탐지 기술이 기존의 정적인 보안 솔루션과는 다른 접근이 필요함을 시사한다. 생성 AI 모델이 빠르게 발전하는 만큼, 탐지 시스템도 지속적으로 최신 패턴을 학습해야 하는 구조가 될 것으로 보인다.

특히 OPENFAKE ARENA의 실시간 경쟁 방식은 흥미로운 접근법이다. 사용자가 탐지기를 속이는 데 성공한 이미지를 즉시 훈련 데이터로 활용하는 구조는, 탐지 모델이 실제 공격 패턴에 빠르게 적응할 수 있게 한다.

다만 이런 ‘공격과 방어의 동시 진화’ 구조는 양면성을 가진다. 탐지 기술이 발전하는 동시에 더 정교한 우회 기법도 함께 개발될 가능성이 크기 때문이다. 결국 이 분야는 지속적인 기술 경쟁이 이어질 것으로 예상되며, 단발성 솔루션보다는 지속적 업데이트가 가능한 시스템 설계가 중요해질 것으로 보인다.

FAQ

Q. 딥페이크란 무엇인가요?

A. 딥페이크는 인공지능을 이용해 만든 가짜 이미지나 영상입니다. 실제처럼 보이지만, 사실은 존재하지 않는 장면을 만들어냅니다.

Q. 사람도 진짜와 가짜를 구분 못 하나요?

A. 네, 특히 최신 AI 모델로 만든 이미지는 실제 사진처럼 자연스러워서 일반인이 구별하기 어렵습니다. 실험에서도 많은 참가자가 속았습니다.

Q. OPENFAKE는 누구나 사용할 수 있나요?

A. 네, 해당 데이터셋은 허깅페이스(Hugging Face)를 통해 공개되어 있으며, 탐지 모델을 개발하고 싶은 연구자나 개발자들이 자유롭게 활용할 수 있습니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문 명: OpenFake: An Open Dataset and Platform Toward Large-Scale Deepfake Detection

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.