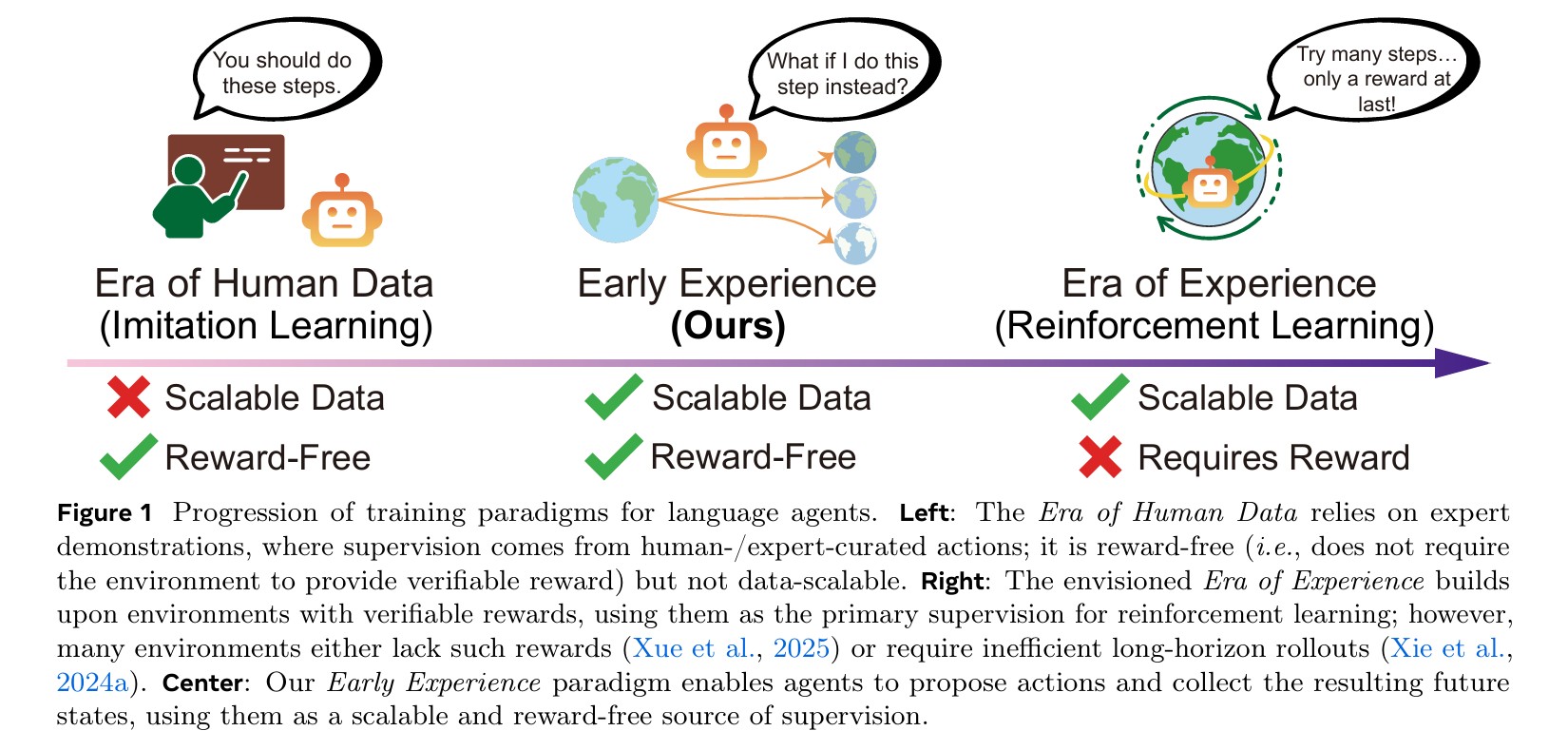

메타 슈퍼인텔리전스 랩스(Meta Superintelligence Labs), 메타 FAIR, 오하이오 주립대 공동 연구진이 AI 에이전트 학습에 새로운 접근법인 ‘초기 경험(Early Experience)’ 패러다임을 제시했다. 이 방법은 보상 신호 없이도 에이전트 자신의 행동과 결과를 학습 신호로 활용해, 기존 모방 학습(Imitation Learning)과 강화학습(Reinforcement Learning) 사이의 간극을 메우는 실용적 방안으로 주목받고 있다.

전문가 데이터만으론 부족했다, 실패 경험이 만드는 학습

현재 대부분의 언어 에이전트는 전문가가 만든 시연 데이터로 지도 학습(Supervised Fine-tuning)을 진행한다. 하지만 이 방식은 전문가 데이터가 다루는 좁은 범위의 시나리오에만 국한되며, 에이전트가 자신의 행동 결과를 관찰하지 못해 실패로부터 배우거나 의사결정을 개선할 수 없다는 한계가 있다. 게다가 고품질 인간 시연 데이터 확보는 비용이 많이 들고 확장성이 떨어진다. 한편 강화학습은 검증 가능한 보상 신호가 필요한데, 웹사이트처럼 실제 세계의 많은 환경에서는 명확한 보상을 얻기 어렵거나 장기간의 상호작용 끝에야 지연된 피드백을 받는다.

연구진이 제안한 초기 경험은 에이전트가 자신이 제안한 행동을 환경에서 실행하고, 그 결과로 얻은 미래 상태를 보상 신호 없이 학습 신호로 전환하는 방식이다. 전문가 궤적의 각 상태에서 에이전트는 여러 대안 행동을 제안하고 각 행동 실행 후 나타나는 다음 상태를 수집한다. 이렇게 모은 상호작용 데이터는 외부 보상 없이도 에이전트가 환경 역학을 이해하고 차선의 행동을 개선하는 데 활용된다.

환경 역학 내재화와 자기 성찰, 두 가지 전략으로 학습 강화

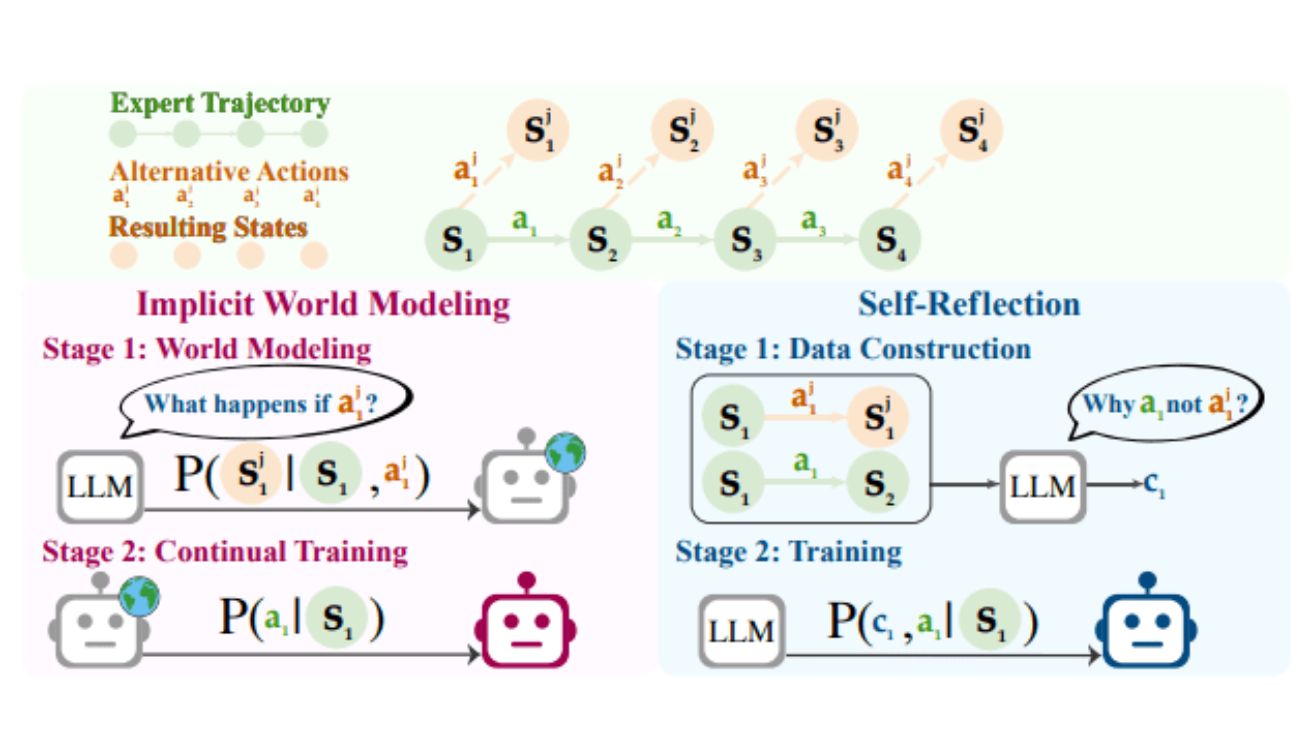

초기 경험 패러다임 하에서 연구진은 두 가지 학습 전략을 제시했다. 첫 번째는 암묵적 월드 모델링(Implicit World Modeling)으로, 에이전트가 수집한 미래 상태를 활용해 환경 역학에 대한 내부 표현을 구축하도록 한다. 구체적으로, 각 상태와 행동 쌍에 대해 결과로 나타나는 다음 상태를 예측하는 과제를 학습 목표로 삼는다. 이를 통해 에이전트는 환경 전이의 규칙성과 부작용, 잘못된 행동의 결과 등을 파악하며, 전문가 궤적에만 의존하는 것보다 다양한 비전문가 행동에도 견고해진다.

두 번째 전략인 자기 성찰(Self-Reflection)은 에이전트가 자신의 차선 행동을 전문가 시연과 비교하고, 왜 특정 결정이 최적이 아닌지 교훈을 추출해 향후 의사결정을 개선하도록 한다. 각 전문가 상태에서 전문가 행동과 여러 대안 행동을 실행한 뒤 얻은 다음 상태 간 차이를 바탕으로 언어 모델에 자연어 설명을 생성하도록 요청한다. 이렇게 생성된 사고 과정과 전문가 행동을 함께 학습 신호로 사용함으로써, 에이전트는 단순한 모방을 넘어 일반화 가능한 의사결정 원리를 습득하게 된다.

8개 환경 테스트에서 일관된 성능 향상 입증

연구진은 웹 내비게이션(WebShop, WebArena-Lite), 체화된 탐색(ALFWorld), 과학 시뮬레이션(ScienceWorld), 장기 계획(TravelPlanner), 멀티턴 도구 사용(BFCLv3, Tau-Bench, SearchQA) 등 8개 다양한 환경에서 실험을 진행했다. 실험에는 라마(Llama) 3.2-3B, 큐엔(Qwen) 2.5-7B, 라마 3.1-8B 등 여러 모델 패밀리가 사용됐다. 모든 설정에서 초기 경험 기반 방법들은 순수 모방 학습 베이스라인보다 일관되게 우수한 성과를 보였다.

특히 웹샵(WebShop) 환경에서 라마 3.2-3B 모델은 모방 학습 대비 암묵적 월드 모델링이 18.4%포인트, 자기 성찰이 10.9%포인트 향상을 기록했다. 여행 계획(TravelPlanner)에서는 자기 성찰 적용 시 라마 3.2-3B가 12.8%포인트, 큐엔 2.5-7B가 15.0%포인트 상승했다. 또한 영역 외(Out-of-Domain) 일반화 평가에서도 초기 경험은 모방 학습보다 더 견고한 성능을 보였으며, 일부 벤치마크에서는 영역 외 개선 폭이 영역 내보다 크게 나타나 에이전트 자신의 경험이 전문가 시연 범위를 넘어서는 상황에도 잘 대비시킨다는 점을 확인했다.

강화학습 초기화에도 효과적, 미래 학습 잠재력 확대

보상 신호가 제공되는 세 가지 환경(WebShop, ALFWorld, SearchQA)에서 강화학습 실험을 추가로 진행한 결과, 초기 경험으로 훈련된 체크포인트에서 시작한 강화학습이 모방 학습만으로 초기화한 경우보다 최종 성능에서 일관되게 더 높은 상한선에 도달했다. 예를 들어 웹샵에서 라마 3.2-3B는 암묵적 월드 모델링 후 강화학습 적용 시 성공률 92.2%를 달성해 모방 학습 시작점(82.0%)보다 10.2%포인트 높았다. 이는 초기 경험이 강화학습 인프라가 갖춰지기 전에도 에이전트 성능을 끌어올릴 뿐 아니라, 이후 강화학습 단계에서도 더 나은 초기 정책을 제공해 장기적 이득을 가져온다는 것을 시사한다.

연구진은 또한 전문가 데이터 양을 절반 이하로 줄여도 초기 경험이 전체 데이터로 훈련한 모방 학습과 비슷하거나 더 나은 성능을 낼 수 있음을 확인했다. 웹샵에서 라마 3.1-8B는 전체 데이터의 8분의 1만 사용해도 전체 데이터로 훈련한 모방 학습보다 높은 성공률을 기록했다. 이는 에이전트 자신의 경험이 전문가 시연만으로는 얻기 어려운 추가적인 학습 신호를 제공하기 때문이다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. 초기 경험은 기존 모방 학습과 어떻게 다른가요?

모방 학습은 전문가가 만든 시연 데이터만으로 에이전트를 훈련하기 때문에 전문가가 경험하지 않은 상황에서는 성능이 떨어질 수 있습니다. 초기 경험은 에이전트가 직접 여러 행동을 시도하고 그 결과를 관찰해 학습 신호로 활용하므로, 더 다양한 환경 상황에 대응할 수 있고 실패로부터도 배울 수 있습니다.

Q2. 초기 경험은 보상 신호가 없어도 작동하나요?

네, 초기 경험의 핵심은 보상 신호 없이도 에이전트 자신이 만든 행동의 결과인 ‘다음 상태’를 학습 신호로 사용한다는 점입니다. 이를 통해 명확한 보상을 정의하기 어려운 웹사이트 내비게이션 같은 환경에서도 효과적으로 학습할 수 있습니다.

Q3. 초기 경험은 어떤 환경에서 가장 효과적인가요?

암묵적 월드 모델링은 상태 전이가 일관되고 예측 가능한 환경(예: 웹샵, 체화된 탐색)에서 특히 효과적이며, 자기 성찰은 복잡한 제약 조건과 다단계 추론이 필요한 환경(예: 여행 계획, 과학 시뮬레이션)에서 더 큰 성능 향상을 보입니다. 전반적으로 다양한 행동 공간과 관찰 복잡도를 가진 환경에서 일관된 개선 효과가 나타났습니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문명: Agent Learning via Early Experience

이미지 출처: Meta Superintelligence Labs

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.