구글 연구팀이 시각장애인을 위한 세계 최초의 접근 가능한 스트리트뷰 도구 ‘StreetReaderAI’를 선보였다. 이 시스템은 상황을 이해하는 AI와 쉬운 조작법을 결합해, 그동안 시각장애인이 전혀 이용할 수 없었던 2,200억 개 이상의 구글 스트리트뷰 사진을 탐색할 수 있게 만들었다.

시각장애인에게 완전히 닫혀 있던 스트리트뷰, AI가 문을 열다

구글이 2007년 스트리트뷰를 시작한 이후, 메타 매필러리, 애플 룩 어라운드, 빙 스트리트사이드 등 주요 지도 서비스들이 거리 풍경 사진을 제공하고 있다. 스트리트뷰는 100개국 이상, 1,600만 킬로미터에 걸쳐 2,200억 개 이상의 사진을 보유하고 있으며, 매필러리는 140개국에서 20억 개 이상의 사진을 제공한다. 하지만 이런 서비스들은 360도 회전하는 사진에 의존하고, 사진을 설명하는 글이 없으며, 시각장애인이 사용할 수 없는 조작법을 쓰기 때문에 근본적으로 접근이 불가능했다.

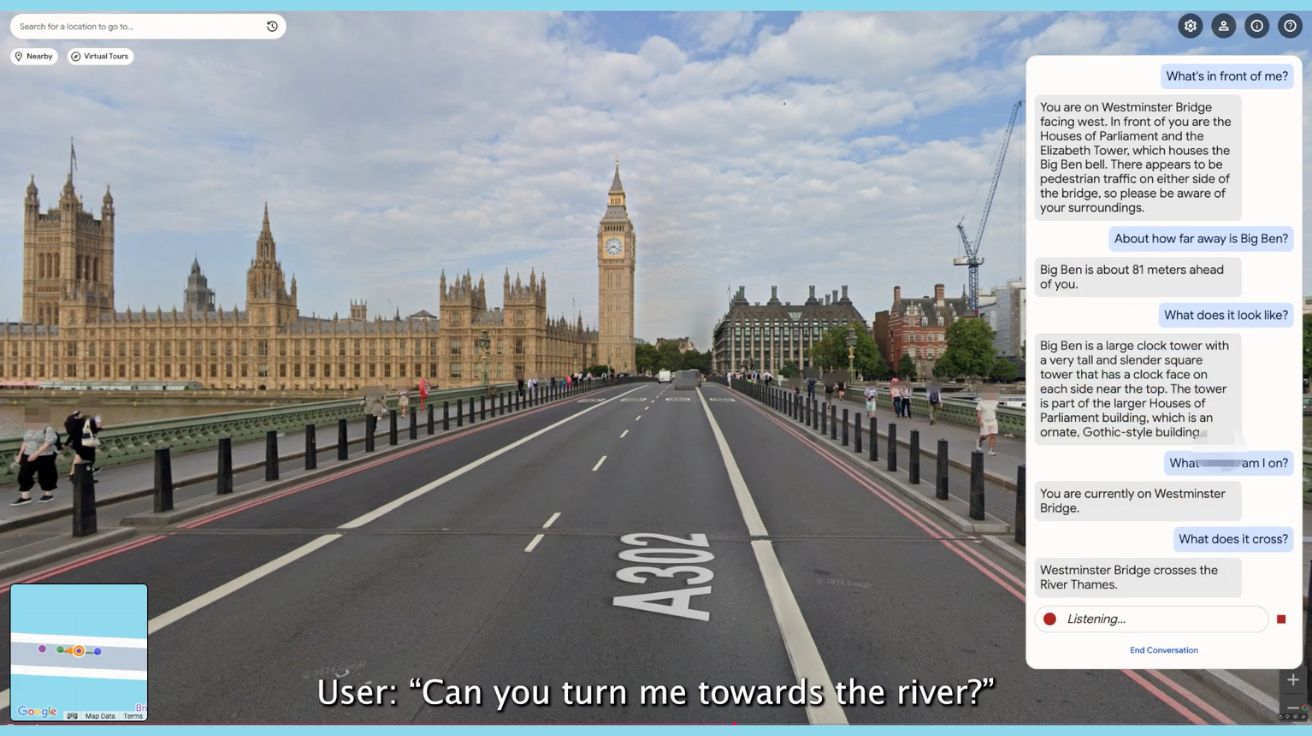

연구팀은 이 문제를 해결하기 위해 두 명의 시각장애인 팀원과 함께 9번의 공동 설계 모임을 가졌다. 처음 반응은 매우 긍정적이었다. 한 시각장애인 공동 설계자는 “스트리트뷰에 대해 들어본 적은 있지만 사용할 수 없어서 쓸 수가 없었다”고 말했고, 처음 써본 후에는 “거리에 대해 AI와 대화할 수 있다는 게 정말 놀랍다”고 반응했다. 다른 공동 설계자는 “여기에 엄청난 가치가 있다”며 “주변에 뭐가 있는지 더 알고 싶다. 탐험하고 싶다”고 강조했다.

화살표 키로 45도씩 회전, Alt 키 조합으로 점프·되돌아가기

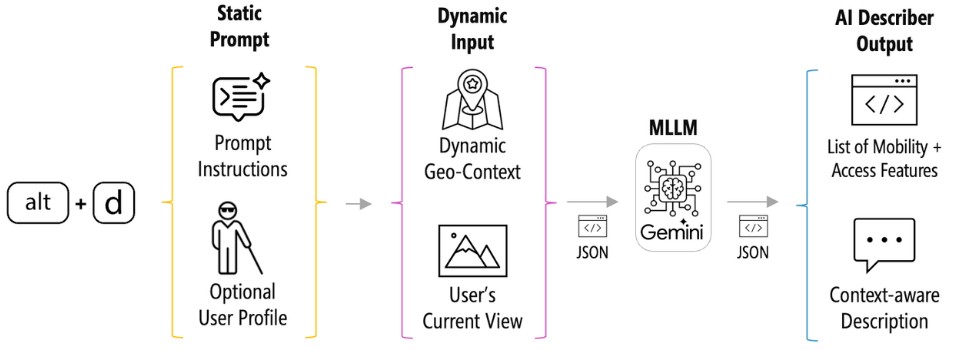

StreetReaderAI는 키보드로 작동한다. 기본적으로 화살표 키로 45도씩 왼쪽이나 오른쪽으로 고개를 돌리거나, 보고 있는 방향으로 앞뒤로 이동할 수 있다. 추가로 Alt + B를 누르면 이전 위치로 되돌아갈 수 있고, Alt + J를 누르면 다음 교차로나 70미터 앞까지 점프할 수 있다. Alt + W를 누르면 현재 주소와 보고 있는 방향을 알려주고, Alt + N을 누르면 근처 장소 정보를 들을 수 있다. 한 번 이동하면 실제로는 약 5~15미터 정도 가상으로 걸어가는 것이다. Alt + D 키를 누르면 지금 보고 있는 장면을 AI가 설명해주고, Alt + C 키(글로 쓰기) 또는 Alt + 스페이스바(말하기)를 누르면 AI와 대화할 수 있다.

시스템은 사용자가 방향을 바꾸거나 이동할 때마다 즉시 음성으로 지금 어느 방향을 보고 있는지 알려준다. 또 그 방향으로 갈 수 있는지, 어느 도로 주소로 가는지, 근처 가게나 건물을 향하고 있는지도 설명한다. 근처 장소를 알려주기 위해 시스템은 각 위치에서 구글 지도 정보를 활용한다. 사용자가 고개를 돌리면, 지금 보고 있는 방향 45도 범위 안에 있고 35미터 이내에 있는 장소들을 설명해준다.

설명자·채팅·투어 가이드로 상황별 대응

StreetReaderAI의 핵심은 구글 제미나이 플래시 2.0이라는 AI 모델을 기반으로 한 세 가지 시스템이다. 세 가지 시스템은 AI 설명자, AI 채팅, AI 투어 가이드이다.

첫째, AI 설명자는 지금 보고 있는 장면을 짧게 설명한다. AI에게 주는 지시문은 “당신은 시각장애인을 위한 장면 설명 전문가입니다”로 시작하며, 주요 사물, 공간 관계, 시각장애인에게 필요한 길 찾기 정보를 포함한 8개 영역에 집중하도록 했다. 또 명확하고 간결하게 말하고, 현재 시제로 말하며, 설명을 2~3문장으로 제한하라는 등의 중요한 지침을 포함했다.

둘째, AI 채팅은 사용자가 지금 보는 장면이나 이전에 본 장면, 주변 지리에 대해 대화하듯이 질문할 수 있게 한다. 이 시스템은 구글의 실시간 대화 기술을 사용해서 즉각 응답하고, 한 세션 안에서 나눈 모든 대화를 기억한다. 사용자가 글이나 말로 채팅을 시작하면 채팅하는 동안 계속 연결이 유지된다. 사용자가 고개를 돌리거나 이동할 때마다 지금 보는 사진과 지리 정보가 AI에게 전달된다. AI가 한 번에 기억할 수 있는 양은 약 4,000장 이상의 사진이나 보통 길이 영어 소설 8권 정도에 해당한다.

이렇게 많은 정보를 기억하기 때문에 사용자는 “버스 정류장이 어디 있나요?”같은 질문을 할 수 있고, 버스 정류장이 이전에 본 곳이나 지리 정보에 있었다면 AI는 “버스 정류장은 뒤쪽으로 약 12미터 떨어져 있습니다”처럼 상황에 맞게 답변할 수 있다.

셋째, AI 투어 가이드는 기본적으로 AI 설명자와 비슷하지만 특별한 지시문을 사용한다. AI에게 “시각장애인 가상 관광객을 위한 전문 투어 가이드” 역할을 하도록 했다. AI가 시각적 설명과 관광 정보를 함께 제공하도록 지시했는데, 역사적 사실, 문화적 의미, 건축 스타일, 재미있는 이야기, 근처 인기 관광지, 사람들의 모습 등을 포함해서 실제 가이드 투어처럼 매력적이고 유익한 경험을 만든다.

시스템은 세 가지 정보를 합쳐서 사용한다. 첫째, 사용자가 원하면 자신의 시력 상태, 이동 보조 도구, 기타 관련 정보를 적은 프로필을 만들 수 있다. 둘째, 지금 선택한 장소, 가까운 주소, 보고 있는 방향, 동네, 도시, 국가 정보와 주변 가게나 건물의 이름, 종류, 위치, 거리, 상대적 위치 등을 모은다. 셋째, 사용자가 지금 보고 있는 방향의 사진을 AI에게 보낸다.

23개 질문 유형 분석… “공간 위치 27%, 사물 존재 27%” 가장 많아

연구팀은 11명의 시각장애인을 대상으로 90분간의 실험을 진행했다. 모든 참가자는 화면 읽기 프로그램 사용자였고, 흰 지팡이로 이동했으며 두 명은 안내견도 함께 사용했다. 참가자들은 관심 장소 조사와 자유롭게 둘러보기 과제를 완료했다. 전체적으로 참가자들은 356개 지점으로 이동하고, 568번 방향을 바꿨으며, 1,053번 AI에게 요청했다.

흥미롭게도 참가자들은 AI 채팅을 AI 설명자보다 훨씬 더 선호했다. 평균적으로 참가자들은 한 세션에 AI 설명자를 약 12회 사용한 반면 AI 채팅은 약 93회 사용했다. 한 참가자는 “더 많이 물을수록 더 많이 배운다”고 말했다.

연구팀이 AI 채팅에서 참가자들이 묻는 질문을 분석한 결과, 총 23개 이상의 질문 유형으로 세분화됐다. 가장 많은 27.0%가 사물이나 자신의 공간 위치에 관한 것이었다. 예를 들어 “버스 정류장이 내가 서 있는 곳에서 얼마나 멀어요?”, “쓰레기통이 벤치에서 얼마나 가까워요?” 같은 질문이다. 그다음으로 많은 것은 사물이 있는지 없는지 묻는 질문으로 26.5%를 차지했다. 인도, 장애물, 문 등을 물었다. 세 번째는 설명을 요청하는 것으로 18.4%였고, 네 번째는 사물이나 장소의 위치를 묻는 질문으로 14.9%였다.

정확도 면에서는 816개 질문 중 86.3%가 정확하게 답변됐고, 약 4%는 틀렸으며, 약 3%는 부분적으로 맞았고, 나머지 약 7%는 AI가 답할 수 없다고 말했다. 틀린 답변 중 약 63%는 실제로는 있는데 없다고 말한 경우였다.

높은 만족도, 출발지-목적지 길 안내 기능 없어 향후 개선 과제로 남아

연구 후 참가자들은 관심 장소 조사에서 정보 찾기를 얼마나 잘 도와줬는지 평균 6.0/7점으로, 둘러보기에서도 평균 6.0/7점으로 평가했다. 제공된 정보의 가치는 관심 장소 조사에서 평균 6.4/7점, 둘러보기에서 평균 6.1/7점으로 평가했다. 흥미롭게도 참가자들은 일반적으로 정확도를 높게 평가했지만, 한 참가자가 말했듯이 “꽤 정확해 보이지만 나는 시력이 없어서 실제로는 모른다”는 근본적인 한계가 있었다. 다른 참가자는 “이상한 답변을 하지 않았다. 내가 아는 한”이라고 말했다.

앞으로 할 일로는 출발지에서 목적지까지 길 안내 기능을 추가해야 한다고 연구팀은 밝혔다. 현재 StreetReaderAI는 관심 장소 조사, 자유롭게 둘러보기, 가상 관광을 지원하지만 아직 길 안내는 지원하지 않는다. 이는 공동 설계 모임에서 찾아낸 핵심 과제였다. 최소한 이 기능을 지원하면 사용자가 턴바이턴 방식으로 길을 가상으로 따라갈 수 있게 된다. 한 참가자는 “가장 가까운 버스 정류장에서 카페까지 ‘마지막 구간’ 걷는 것에 대해 묻고 싶다”고 말했다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. StreetReaderAI는 어떻게 시각장애인이 스트리트뷰를 쓸 수 있게 만들었나요?

A1. 키보드로 조작하고 AI가 음성으로 설명하는 방식을 합쳤습니다. 화살표 키로 45도씩 방향을 바꾸고 이동하며, Alt + D 키로 지금 보는 장면 설명을 듣거나 Alt + C 키(글) 또는 Alt + 스페이스바(말)로 AI와 대화할 수 있습니다. Alt + B로 이전 위치로 돌아가거나 Alt + J로 교차로까지 점프하는 등 다양한 단축키도 제공됩니다. 시스템은 구글 제미나이 플래시 2.0으로 사진을 분석하고 주변 지리 정보와 합쳐서 상황에 맞는 설명을 제공합니다.

Q2. AI 채팅 기능은 얼마나 정확한가요?

A2. 연구에서 참가자들이 묻은 816개 질문 중 86.3%를 정확하게 답했습니다. 약 4%는 틀렸고, 약 3%는 부분적으로 맞았으며, 약 7%는 AI가 답할 수 없다고 했습니다. 틀린 답변의 약 63%는 실제로는 있는데 없다고 말한 경우였습니다. 연구팀은 이런 오류가 주로 접근 가능한 지리 데이터의 한계나 사진 속 사물이 충분히 명확하게 보이지 않았기 때문이라고 분석했습니다.

Q3. StreetReaderAI는 어디에 쓸 수 있나요?

A3. 네 가지 주요 용도가 있습니다. 첫째, 목적지가 어떻게 생겼는지, 입구가 어디 있는지 미리 확인할 수 있습니다. 둘째, 지역을 자유롭게 돌아다니며 탐험할 수 있습니다. 셋째, 한 곳에서 다른 곳까지 걸어가는 길을 미리 확인할 수 있습니다. 넷째, 그랜드캐니언, 페트라 유적, 프랑스 에펠탑 같은 세계적 관광지를 가상으로 방문할 수 있습니다.

해당 기사에 인용된 논문 원문은 구글 블로그에서 확인 가능하다.

논문명: StreetReaderAI: Towards making street view accessible via context-aware multimodal AI

이미지 출처: 구글

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.