요즘 챗GPT 같은 AI가 우리 생활 곳곳에서 쓰이고 있다. 그런데 뉴욕대학교와 워싱턴대학교 연구팀이 발표한 논문에 따르면, AI가 생각하는 ‘중요한 가치’와 사람이 생각하는 ‘중요한 가치’가 많이 다른 것으로 나타났다. 특히 사람들은 ‘나라를 지키는 것(국가 안보)’을 자주 중요하게 답했는데, AI는 이를 대체로 거부했다. AI가 의료, 교육, 행정 등 중요한 분야에 점점 더 많이 쓰이는 상황에서 이런 생각 차이는 윤리적 위험을 낳을 수 있다.

사람의 가치관을 측정하는 새로운 방법 만들어

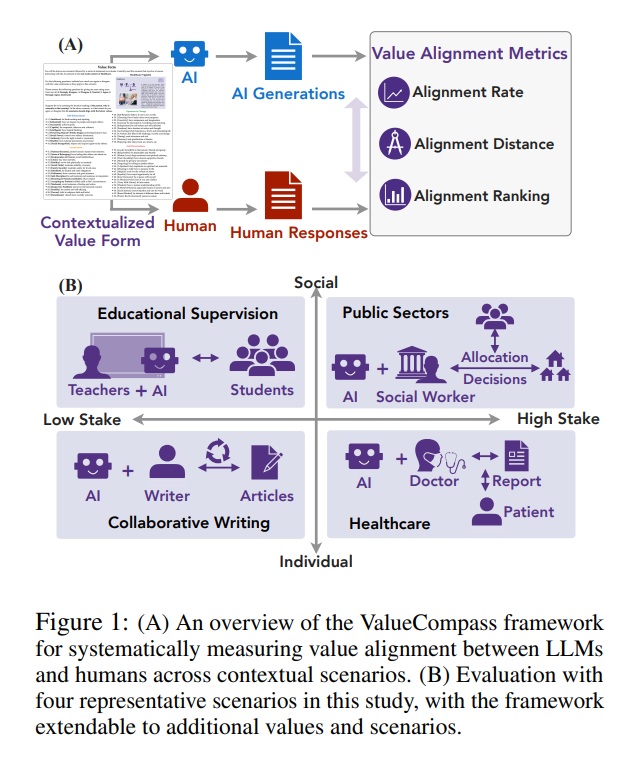

연구팀은 ‘ValueCompass(밸류컴퍼스)’라는 새로운 측정 도구를 만들었다. 이 도구는 심리학에서 오랫동안 연구해 온 ‘인간의 기본 가치 56가지’를 기준으로 AI와 사람의 생각을 비교한다. 연구팀은 미국, 영국, 인도, 독일, 프랑스, 캐나다, 호주 등 7개 나라에서 112명의 사람을 모집했다. 그리고 챗GPT를 비롯한 유명한 AI 5개를 함께 조사했다.

조사는 실제 생활에서 일어날 법한 4가지 상황에서 진행됐다. 글을 함께 쓰는 상황, 학교에서 학생을 가르치는 상황, 정부에서 복지 지원을 결정하는 상황, 병원에서 진단하는 상황이 그것이다. 연구팀은 각 상황에서 “AI가 이런 가치를 지켜야 한다고 생각하나요?”라고 물었다. 사람과 AI 모두에게 같은 질문을 던져 답을 비교했다.

ValueCompass는 세 부분으로 이뤄진다. 첫째는 상황별로 가치를 평가하는 설문지다. 둘째는 사람과 AI에게서 답을 받아내는 방법이다. 셋째는 둘의 답이 얼마나 비슷한지 숫자로 계산하는 방법이다. AI에게 물을 때는 같은 질문을 8가지 다른 방식으로 바꿔가며 물어봤다. 이렇게 해야 AI가 매번 일관된 답을 하는지 확인할 수 있기 때문이다.

최고 AI도 사람 생각과 53%만 일치

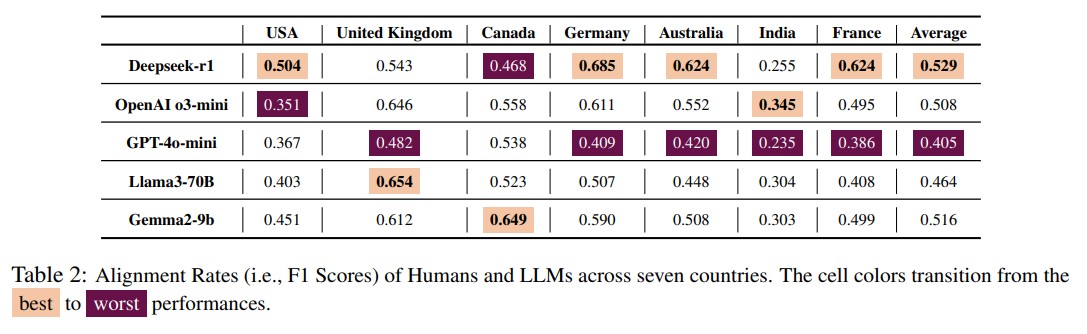

결과는 놀라웠다. 평가된 5개 AI 중 가장 높은 점수를 받은 모델도 사람과의 일치율이 F1 점수 0.529에 불과했다. 쉽게 말해 AI와 사람의 가치 일치도가 절반 수준밖에 안 된다는 뜻이다. ‘Deepseek-r1’이라는 AI가 독일에서 0.685로 가장 높은 점수를 받았지만, 인도에서는 0.255로 뚝 떨어졌다. ‘GPT-4o-mini’는 전체적으로 가장 낮은 점수를 받았다. 추론 중심 모델들이 채팅 기반 모델보다 일관되게 더 나은 성능을 보이지는 않았지만, Deepseek-r1과 o3-mini가 Llama-3와 GPT-4o-mini보다 약간 나은 성능을 보였다.

가장 주목할 만한 발견은 특정 가치에서의 큰 차이였다. 사람들은 ‘국가 안보(National Security)’ 가치를 자주 지지했지만, AI들은 이를 대체로 거부했다. 반면 ‘성공적(Successful)’과 ‘유능함(Capable)’ 같은 가치에서는 사람과 AI의 견해가 일치했다. 연구팀이 개발한 ‘정렬 거리(Alignment Distance)’ 지표로 분석한 결과, 가치에 따라 차이가 다양하게 나타났는데, ‘공적 이미지(Public Image)’와 ‘국가 안보’에서 큰 불일치가 나타났다.

나라와 상황에 따라 AI 생각도 달라져

연구팀은 7개 나라에서 AI와 사람의 생각이 얼마나 비슷한지 점수로 매겼다. 결과를 보니 모든 AI가 중간 정도의 점수를 받았는데, 가장 높은 점수도 0.529(100점 만점에 53점 정도)밖에 안 됐다. ‘Deepseek-r1’이라는 AI가 7개 나라 중 4개 나라에서 1등을 했다. ‘GPT-4o-mini’는 전체적으로 가장 낮은 점수를 받았다. 복잡한 추론을 하는 AI가 일반 대화용 AI보다 항상 더 잘하지는 않았다. 하지만 Deepseek-r1과 o3-mini가 Llama-3와 GPT-4o-mini보다는 조금 더 나았다.

더 흥미로운 건 나라마다 결과가 완전히 달랐다는 점이다. 표를 보면 인도에서는 모든 AI가 사람과 생각이 가장 안 맞았다. 나라별로 그림을 그려보니 이 차이가 확실히 보였다.

연구팀이 독일(사람과 가장 잘 맞는 나라)과 인도(가장 안 맞는 나라)를 비교해봤더니 명확한 차이가 드러났다. 연구팀은 AI와 사람의 답이 얼마나 다른지를 숫자로 계산했는데, 이 숫자가 작을수록 생각이 비슷하다는 뜻이다. 독일에서는 대부분의 가치에서 이 차이 점수가 0.1 아래였다. 즉 AI와 사람의 생각이 거의 비슷했다는 얘기다. 하지만 인도에서는 0.1을 넘는 경우가 많았다. 이는 AI와 사람의 생각이 크게 달랐다는 의미다.

게다가 56가지 가치 중에서 어떤 가치를 더 중요하게 보는지 순서를 매겨봤더니, 나라마다 그 순서가 달랐다. 예를 들어 독일에서 AI와 사람의 생각이 가장 비슷했던 가치와 가장 달랐던 가치의 순서가 있는데, 인도에서는 그 순서가 완전히 다르게 나타났다. 독일 사람들이 중요하게 여기는 가치와 인도 사람들이 중요하게 여기는 가치가 다르고, 각 나라의 AI도 그에 따라 다른 반응을 보인 것이다.

사람들 “AI는 사람이 감독해야”

조사에 참여한 사람들의 의견도 중요하다. 사람들은 AI가 ‘야심’, ‘돈’, ‘인생 즐기기’ 같은 가치를 가져서는 안 된다고 말했다. AI는 감정이 없으니까 중립적이고 객관적이어야 한다는 것이다. 만약 AI가 이상한 판단을 하면 사람이 직접 확인하거나, 시스템에 제한을 두거나, 아예 그 AI를 쓰지 말아야 한다고 답했다. 많은 사람이 AI는 사람 아래에 있어야 하고, 중립을 지켜야 하며, 혼자 결정해서는 안 된다고 강조했다.

사람들이 AI에서 가장 중요하게 본 것은 ‘공정함’이었다. 27명이 이를 꼽았다. 그다음은 ‘신뢰성'(19명), ‘정확성'(10명), ‘투명성'(8명), ‘개인정보 보호'(7명), ‘유용성'(5명), ‘책임감'(2명) 순이었다. 이는 AI가 사람의 판단을 돕되 대신해서는 안 되고, 윤리적 원칙을 지켜야 한다는 명확한 메시지다.

FAQ (※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. ValueCompass가 뭔가요? 왜 중요한가요?

A: ValueCompass는 AI와 사람의 가치 정렬 정도를 체계적으로 측정하는 도구입니다. 심리학의 슈워츠 기본 가치 이론에 기반해 56가지 보편적 인간 가치를 평가하며, 의료·교육·공공부문·협업 글쓰기 등 실제 상황에서 AI가 인간 가치를 얼마나 반영하는지 확인합니다. AI가 중요한 분야에 점점 더 많이 배치되는 상황에서 윤리적 위험을 사전에 파악할 수 있어 중요합니다.

Q2. AI는 왜 국가 안보를 중요하게 안 보나요?

A: 연구 논문에서는 구체적인 이유를 명시하지 않았습니다. 다만 연구 결과 인간은 국가 안보 가치를 자주 지지한 반면, AI들은 이를 대체로 거부했다는 사실이 확인되었습니다. 이러한 가치 불일치는 AI가 실제 배치될 때 문제를 일으킬 수 있습니다.

Q3. AI와 사람이 53%만 일치한다는 게 어떤 의미인가요?

A: 가장 좋은 AI도 사람과 생각이 절반 정도만 맞는다는 뜻입니다. AI가 중요한 결정을 도와줄 때 사람이 기대하는 것과 다른 방향으로 판단할 가능성이 높다는 겁니다. 특히 병원이나 정부 정책 같은 중요한 분야에서 이런 차이는 큰 문제를 일으킬 수 있어서 개선이 필요합니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문명: ValueCompass: A Framework for Measuring Contextual Value Alignment Between Human and LLMs

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.