멀티모달 AI 영상 분석 솔루션 기업 PIA-SPACE가 구글의 인공지능 ‘제미나이’를 활용해 CCTV에서 폭력 상황을 실시간으로 찾아내는 기술을 개발했다. 해당 연구 논문에 따르면, 정확도는 95.25%에 달한다. 기존 방식이 5~30초 길이의 영상을 통째로 학습했다면, 이 기술은 폭력이 실제로 일어나는 짧은 순간만 집중적으로 학습해 정확도를 크게 높였다. 영상을 1~2초 단위로 잘게 쪼개 분석하는 것이다.

0초 영상 대신 1~2초로 잘게 쪼개 학습… “순간 포착”이 핵심

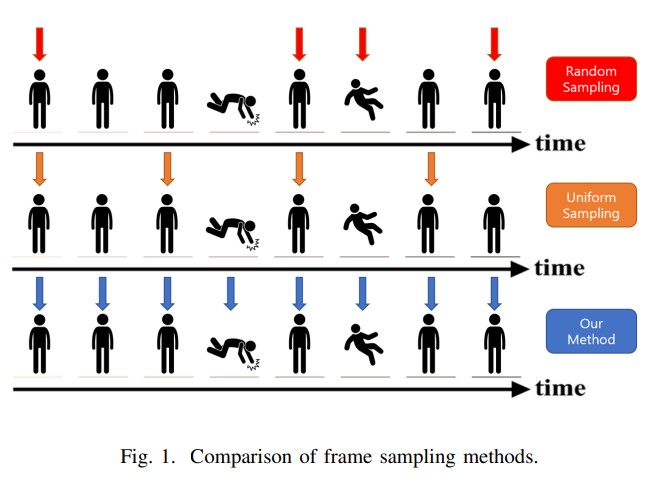

기존의 CCTV 폭력 감지 AI는 5~30초 길이의 영상을 학습 자료로 사용했다. 하지만 실제 폭력 행위는 그중 1~2초 정도의 짧은 순간에만 일어난다. 긴 영상에서 중요한 장면을 골라내는 방식으로는 순간적인 폭력 행위를 제대로 포착하기 어려웠다. 또한 계산량이 많아 실시간으로 작동하기에도 부적합했다.

연구진이 개발한 ‘짧은 윈도우 슬라이딩 러닝’ 방식은 이런 문제를 해결했다. 긴 영상을 1~2초 단위의 짧은 영상으로 잘라낸 뒤, 영상마다 구글의 제미나이가 자동으로 설명을 붙인다. 예를 들어 “사람들이 서로 밀치는 장면” 또는 “주먹을 들어 올리는 행동” 같은 문장으로 표현하는 식이다. 이렇게 만들어진 설명은 크게 ‘폭력’과 ‘비폭력’으로 나뉘고, 다시 ‘주먹질’, ‘발차기’, ‘밀기’, ‘쫓기’ 등으로 세분화된다.

제미나이가 자동으로 만든 설명은 3명의 전문가가 40시간씩, 총 120시간 동안 검토해 오류를 바로잡는다. 이 과정을 거쳐 정확도 높은 학습 자료가 완성된다. 이 방식은 기존의 긴 영상 중심 학습에서 벗어나 실시간 감시에 적합한 새로운 방법을 제시한다.

영상의 모든 장면 활용해 정보 손실 막는다… 비전-언어 AI 모델 사용

기존 방식은 긴 영상에서 일정 간격으로 몇 장면만 뽑아 학습했다. 이 과정에서 중요한 정보가 빠질 수 있었다. 반면 이 연구는 1~2초의 짧은 영상 안에 있는 모든 장면을 학습에 사용한다. 덕분에 시간의 흐름에 따른 정보를 빠짐없이 담아낼 수 있다.

학습에는 InternVL3라는 AI 모델을 사용했다. 이 모델은 영상과 글을 함께 이해하는 ‘비전-언어 모델’이다. 영상을 분석하는 부분과 글을 이해하는 부분이 따로 있고, 이 둘을 연결해 영상 속 행동의 의미까지 파악한다. 12~15장의 화면을 입력받아 제미나이가 만든 설명과 함께 학습하기 때문에, 단순히 화면만 보는 게 아니라 그 행동이 무엇을 뜻하는지도 배운다.

실제 CCTV에서 사용할 때는 15장의 화면 단위로 계속 입력 받아 실시간으로 폭력 여부를 판단한다. 이런 구조 덕분에 찰나의 순간에 벌어지는 폭력 상황도 놓치지 않고 잡아낼 수 있다.

실제 CCTV 영상 데이터로 테스트… 기존 최고 기술 넘어섰다

연구진은 실제 CCTV 환경에서 촬영된 폭력·비폭력 영상 2,000개로 구성된 ‘RWF-2000’ 데이터로 실험했다. 그 결과 95.25%의 정확도를 기록했다. 이는 2025년에 나온 기존 최고 기술인 ‘MSTFDet’의 95.20%를 근소하게 앞선 수치다. 특히 복잡한 구조 없이 짧은 영상 학습만으로 최고 수준의 성능을 냈다는 점에서, 시간의 흐름을 포착하는 방식이 효과적임을 증명했다.

2023~2024년에 발표된 다른 폭력 감지 기술들과 비교해도 우수했다. CUE-Net(94.00%), Violence 4D(94.67%), Structured Keypoint Pooling(93.40%) 등을 모두 앞질렀다. 복잡한 방법보다 짧은 시간 단위를 세밀하게 학습하는 게 더 좋은 결과를 낸다는 것을 보여준다.

영상 길이 줄였더니 정확도 27.5%p 껑충… 데이터 구성 방식이 성능 좌우

연구진은 여러 종류의 데이터로 추가 실험을 진행했다. 가장 눈에 띄는 결과는 ‘UCF-Crime’ 데이터를 사용한 실험이었다. 이 데이터는 원래 수 분 길이의 긴 영상으로 구성돼 있다. 이를 그대로 학습에 사용하자 정확도가 55.75%에 불과했다. 하지만 같은 데이터를 1~2초 단위로 잘라 자동 라벨링한 뒤 학습하니 83.25%로 27.5%포인트나 높아졌다.

여러 출처의 짧은 영상 데이터를 함께 사용한 실험에서는 95.25%로 가장 높은 정확도를 기록했다. AI Hub CCTV 데이터(실내외 감시 상황 영상), SCVD 데이터(보행자·군중·이상 상황 영상), RWF-2000 등을 결합한 결과다. 서로 다른 종류의 짧은 영상 데이터를 섞을수록 성능이 좋아진다는 사실을 확인했다.

영상 AI의 새로운 방향과 풀어야 할 과제

이 연구는 ‘데이터를 어떻게 나누느냐’가 AI 성능을 크게 좌우한다는 사실을 보여준다. 같은 UCF-Crime 데이터를 긴 영상 그대로 쓸 때와 짧게 자른 뒤 쓸 때 정확도가 27.5%포인트나 차이 났다. 단순히 데이터를 많이 모으거나 복잡한 모델을 만드는 것보다, 데이터를 어떤 단위로 구성하느냐가 더 중요할 수 있다는 뜻이다. 영상 AI 연구에서 화면 추출 방식, 영상 길이, 시간 단위 설정 등을 다시 살펴봐야 한다는 시사점을 준다.

또한, 실시간 감시 시스템이 발전할수록 안전과 사생활 보호 사이의 균형 문제가 중요하기 때문에 기술 상용화에는 주의가 필요해 보인다. 95% 이상의 정확도로 폭력을 실시간 감지한다는 것은 기술적으로 진보지만, 감시 범위가 무분별하게 넓어질 우려도 있다. 연구진은 향후 “공포, 절도, 자살 시도” 등 더 복잡한 상황으로 기술을 확장할 계획이라고 밝혔다. 기술 발전과 함께 명확한 사용 기준과 투명한 운영 방식을 마련해야 할 것이다.

마지막으로, 이 연구는 과학기술정보통신부와 정보통신산업진흥원(NIPA)의 2025년 지역 디지털 기초체력 지원사업으로 진행됐다. ‘비전-언어 모델 기반 자동 이상 감지 실시간 영상 분석 AI 솔루션’의 고도화와 해외 진출이 목표다. 생성형 AI 시대에 특정 분야에서 독자적인 방법과 경쟁력을 확보할 수 있는 가능성을 보여준다.

FAQ ( ※ 이 FAQ는 본지가 리포트를 참고해 자체 작성한 내용입니다.)

Q1. 짧은 윈도우 슬라이딩 러닝이란 무엇인가요?

A. 긴 영상을 1~2초씩 잘라서 학습하는 방법입니다. 기존에는 긴 영상에서 몇 장면만 골라 학습했다면, 이 방법은 짧게 자른 영상의 모든 장면을 빠짐없이 학습합니다. 덕분에 순식간에 벌어지는 폭력 행위를 더 정확하게 찾아낼 수 있습니다.

Q2. 제미나이는 어떻게 영상에 설명을 붙이나요?

A. 구글의 제미나이가 1~2초 길이 영상을 보고 “주먹을 들어 올리는 행동”처럼 문장으로 설명합니다. 이렇게 만든 설명을 ‘폭력’과 ‘비폭력’으로 먼저 나누고, 다시 ‘주먹질’, ‘발차기’ 등으로 세분화합니다. 사람이 최종 검토해서 틀린 부분을 고칩니다.

Q3. 실제 CCTV에서는 어떻게 작동하나요?

A. CCTV 영상을 15장의 화면 단위로 계속 받아들이면서 실시간으로 폭력 여부를 판단합니다. 1~2초 안에 일어나는 폭력 행위를 빠르고 정확하게 포착할 수 있어 실시간 감시 시스템에 효과적입니다.

해당 기사에 인용된 논문 원문은 arvix에서 확인 가능하다.

논문명: Short-Window Sliding Learning for Real-Time Violence Detection via LLM-based Auto-Labeling

이미지 출처: 이디오그램 생성

해당 기사는 챗GPT와 클로드를 활용해 작성되었습니다.