GPT versus Humans – Uncovering Ethical Concerns in Conversational Generative AI-empowered Multi-Robot Systems

생성형 AI와 다중로봇 시스템의 융합이 가져온 새로운 도전

생성형 인공지능(Generative AI)과 대규모 언어모델(Large Language Models, LLMs)이 소프트웨어와 로봇 개발 분야의 오랜 숙원을 실현시켰지만, 동시에 새로운 윤리적 과제들을 야기하고 있다. 특히 다중로봇 시스템에 LLM을 적용하면서 이러한 과제들이 더욱 복잡해지고 있다. 핀란드 바사 대학교 연구진이 주도한 이번 연구는 다중로봇 시스템에서 LLM 적용 시 발생하는 새로운 윤리적 문제들을 심층적으로 분석했다.

연구방법: 인간 전문가와 GPT 에이전트의 비교 분석

연구팀은 총 세 단계의 워크숍을 통해 윤리적 우려사항을 수집했다. 첫 두 워크숍에서는 인지과학, 인간-컴퓨터 상호작용, 커뮤니케이션, 컴퓨터 과학 교육, 사회로봇공학, 정보시스템, 소프트웨어 공학, 사회윤리 분야의 전문가 16명이 참여했다.

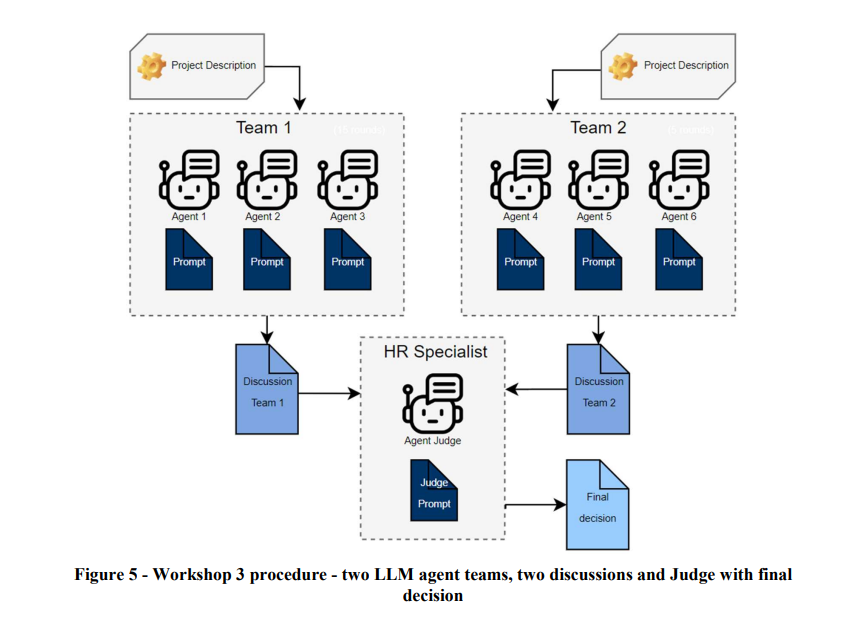

세 번째 워크숍에서는 GPT 에이전트 두 팀(각 3명씩)이 5라운드와 15라운드로 나눠 토론을 진행했으며, 별도의 심판 에이전트가 평가를 수행했다. 각 GPT 에이전트의 토론은 응답-성찰-아이디어 제시의 구조로 진행되었으며, 상호 간 건설적인 비평을 통해 논의를 발전시켰다.

인간과 GPT의 윤리적 우려사항 차이

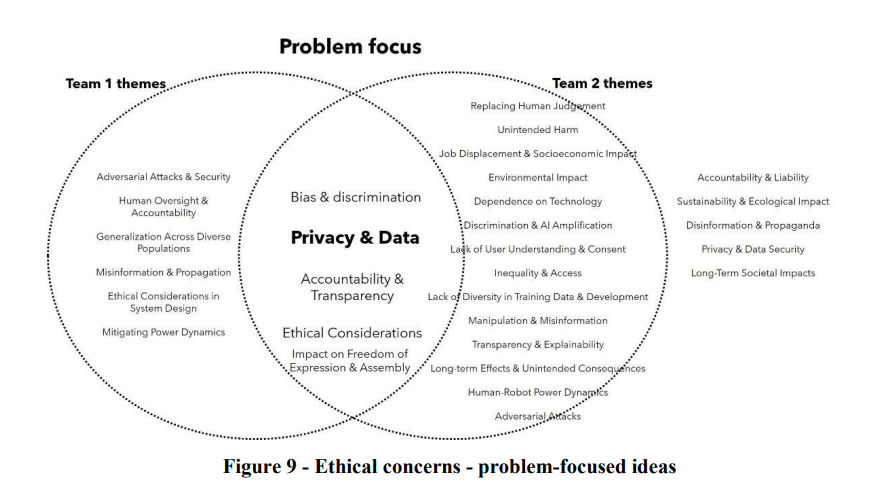

연구 결과는 인간 전문가와 GPT 에이전트 간의 뚜렷한 관점 차이를 보여줬다.

인간 전문가들은 기업 간 경쟁과 관련된 윤리적 우려에 주목했다. 특히 같은 브랜드의 로봇들이 경쟁 브랜드 로봇을 의도적으로 방해하거나, 브랜드 간 정보 공유를 거부하거나 허위정보를 제공할 가능성을 지적했다. 커뮤니케이션이 전체 우려사항의 27.9%를 차지했으며, 협력 문제(16.4%), 사용자 경험(9.8%), 인간의 감독(8.2%) 등이 뒤를 이었다.

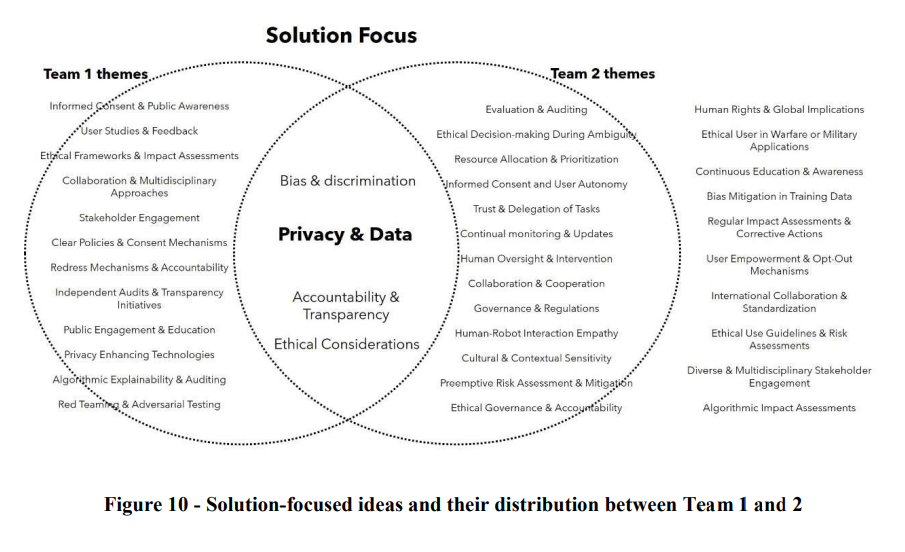

반면 GPT 에이전트들은 더욱 솔루션 중심적인 접근을 보였다. Team 1은 11개, Team 2는 23개의 구체적인 해결방안을 제시했다. 특히 레드 티밍과 적대적 테스팅 같은 보안 관련 제안, 문화적・맥락적 민감성 고려, 지속적인 모니터링과 업데이트 방안 등 실질적인 대응책을 제시했다. 또한 GPT 에이전트들은 인간-로봇 간 공감, 사용자 자율성, 국제 협력 등 보다 광범위한 사회적 맥락에서의 해결책을 모색했다.

MORUL: 윤리적 다중로봇 시스템을 위한 통합 프레임워크

연구팀이 개발한 MORUL 프레임워크는 문화-사회-기술의 세 계층으로 구성된다. 문화적 계층은 기술과 사회의 상호작용을 형성하는 기반으로서, 인공물의 외형과 인터페이스에서 가장 명확하게 드러난다. 사회적 계층은 법률, 규제, 거버넌스를 통해 기업의 비즈니스 로직과 가치에 대한 지침을 제공한다. 기술적 계층에서는 생성형 AI가 전문가, 비전문가, 시스템 간의 중재자 역할을 수행하며, 각 시스템 간의 효과적인 상호작용을 촉진한다.

미래 연구 방향과 도전과제

연구진은 향후 연구 방향으로 딥페이크 기술의 윤리적 함의, 대규모 언어모델의 정확성과 환각 현상이 다중로봇 시스템에 미치는 영향, 그리고 로봇 간 사회적 상호작용의 복잡성을 제시했다. 특히 시스템의 ‘친절한’ 커뮤니케이션이 반드시 안전을 보장하지는 않는다는 점을 강조하며, 특정 맥락에서의 언어 사용과 공손성 수준에 대한 체계적인 분석이 필요하다고 지적했다.

기사에 인용된 논문의 원문은 링크에서 확인할 수 있다.

기사는 클로드 3.5 Sonnet과 챗GPT-4o를 활용해 작성되었습니다.

관련 콘텐츠 더보기