AI위험관리

美 직장인 4명 중 1명, AI에 민감정보 무분별 입력… “보안 사각지대 심각”

챗GPT와 제미나이 같은 생성형 AI 도구가 직장에서 필수 도구로 자리 잡았지만, 많은 직장인들이 회사의 민감한 데이터를 무심코 AI에 입력하며 보안 위험을 키우고 있다는 조사…

‘연간 1000억달러 손실’… 생성형 AI 비용 90% 급락하며 가짜정보 홍수

홍콩중문대학교 장위쿤(Zhang Yukun) 교수와 마카오대학교 장톈양(Zhang Tianyang) 교수 연구팀이 AI 시대 정보 오염 문제를 경제학적으로 분석한 연구 결과를 발표했다. 연구진에 따르면 대형 언어 모델(LLM)의…

AI가 폭주할 때 확실히 막는 방법 나왔다… 中 연구진, AI 통제 시스템 개발

중국 난카이대학교 인공지능학과 왕 동린(Donglin Wang) 교수와 중국 전자 정보 기술 연구원이 공동으로 AI가 위험한 행동을 할 때 확실히 막을 수 있는 새로운 방법을…

“AI 때문에 회사 기밀 유출?” 생성형 AI 안전하게 쓰는 5가지 방법

요즘 챗GPT(ChatGPT) 같은 AI가 엄청난 인기를 끌고 있다. 챗GPT는 출시한 지 단 2개월 만에 사용자가 1억 명을 넘어서며 역사상 가장 빨리 퍼진 앱이 되었다.…

“아니야, 그 명령은 위험해” AI가 인간의 명령을 거부해야만 하는 이유

Artificial Intelligent Disobedience: Rethinking the Agency of Our Artificial Teammates 텍사스 대학교 오스틴 캠퍼스의 루스 미르스키(Reuth Mirsky) 연구진이 발표한 연구에 따르면, 협력형 AI 시스템이…

뉴욕주, AI 재해 방지법 통과… “AI 안전 사고 보고 안 하면, 최대 409억 처벌”

뉴욕주 의회가 오픈AI(OpenAI), 구글(Google), 앤트로픽(Anthropic) 등 거대 AI 기업들의 최첨단 AI 모델로 인한 재해를 방지하는 법안을 통과시켰다고 테크크런치(TechCrunch)가 13일(현지 시간) 보도했다. ‘RAISE Act’로 불리는…

메타의 AI 모델 훈련에 올림픽 수영장 1/4 채울 물 소비… 생성형 AI 환경 영향 심각

Artificial Intelligence: Generative AI’s Environmental and Human Effects 생성형 AI, 전력 소비량 급증으로 미국 전체 전력의 6%까지 차지할 전망 생성형 인공지능(Generative AI)이 산업 전반에…

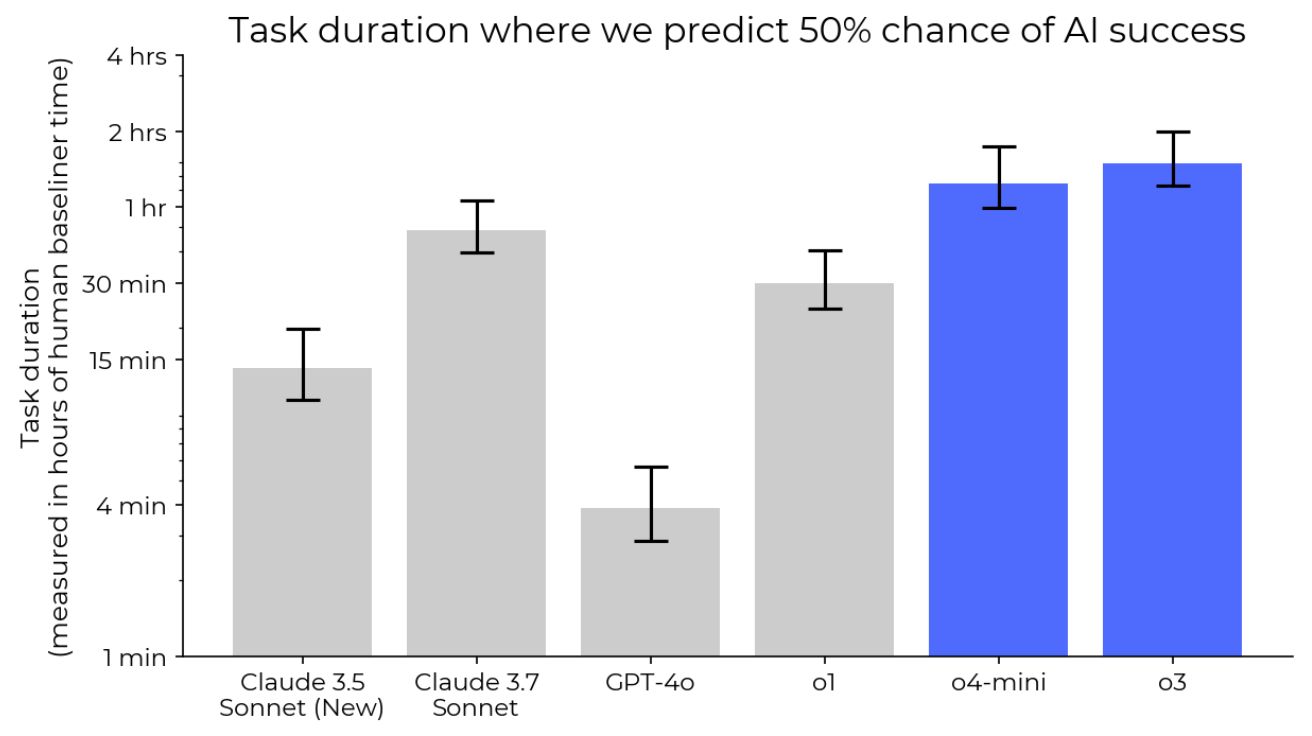

오픈AI, 신모델 ‘o3’ 사전 안전 검증 시간 부족해… 조작 가능성 우려

오픈AI(OpenAI)가 자사의 새로운 고성능 AI 모델인 o3의 테스트를 위해 파트너 기관에 충분한 시간을 제공하지 않았다는 주장이 제기됐다. 테크크런치가 16일(현지 시간) 보도한 내용에 따르면, 미터(Metr)는…

앤트로픽, 바이든 때의 ‘백악관 AI 자발적 약속’ 기록 삭제 논란

앤트로픽(Anthropic)이 자사 웹사이트 ‘투명성 허브(Transparency Hub)’에서 백악관의 AI 자발적 약속 관련 내용을 삭제해 논란이 일고 있다. 이에 대해 앤트로픽 측은 “실질적인 내용 변화는 없으며,…

오픈AI, AI 안전성 및 조정에 대한 접근법 공개… “AGI 지능 자체만으로는 긍정적 변화 보장 못해”

오픈AI가 6일(현지 시간) 자사 웹페이지를 통해, 최근 인공지능 발전에 따른 안전성과 조정에 관한 접근법을 공개했다. 공개된 내용에 따르면, 인류 전체에 혜택을 주는 AGI 개발을…

EU, AI법 책임성 강화해야…”현행 규제안으론 AI 위험 통제 역부족”

유럽연합(EU)의 인공지능(AI) 규제가 현실적 실효성을 확보하지 못하고 있다는 비판적 분석이 제기됐다. 옥스포드 인터넷연구소의 산드라 바흐터(Sandra Wachter) 교수는 최근 예일대 법학기술저널에 발표한 논문을 통해 “EU의…

2024 맥킨지 리포트: 기업들, AI로 실질적 성과 창출

이미지 출처: 미드저니 생성 2024년 초 생성형 AI(Generative AI) 도입이 급격히 증가하면서 기업들이 실질적인 가치를 창출하기 시작했다. McKinsey가 최근 실시한 글로벌 AI 설문조사에 따르면,…