AI 공정성

“AI가 잘못 판단하면 누구 책임?”… 800년 전 마그나카르타가 제시한 해법

미국 뉴햄프셔대학교(University of New Hampshire) 앤드류 쿤 교수가 발표한 논문에 따르면, AI의 힘이 빠르게 강해지는 지금 우리는 중대한 기로에 서 있다. AI가 우리 삶에…

“챗GPT 써도 될까?” 대학생 인식 조사해보니… 남학생, 고학년이 더 관대

미국 노트르담 대학교 연구팀이 대학생 297명을 대상으로 챗GPT 같은 AI 도구 사용에 대해 조사했더니, 많은 학생들이 “대학에서 AI를 어떻게 써야 하는지 모르겠다”고 답했다. 연구팀은…

AI에게 장애인 차별 댓글 감별하게 했더니… 미국 AI는 너무 예민하고, 인도 AI는 너무 둔감해

미국 코넬 대학교 연구팀이 놀라운 사실을 발견했다. 미국에서 개발된 AI들이 장애인 차별을 판단할 때 지나치게 예민하게 반응한다는 것이다. 연구팀은 미국산 AI 4개(GPT-4, 제미나이, 클로드,…

구글 “AI 이미지 안전 검사 완전히 틀렸다”… 타인과 나에게 다른 잣대 들이대

구글이 발표한 연구 결과가 충격적이다. 현재 AI가 만든 이미지가 안전한지 판단하는 방식에 큰 허점이 있다는 것이다. 구글 연구진은 637명의 다양한 사람들이 AI 이미지를 보고…

오픈AI, 500명 넘는 시민들과 직접 인터뷰해 봤더니 “경제 격차 해소 필요”

OpenAI 비영리 법인 자문 위원회가 발표한 보고서에서 인공지능이 모든 인류에게 도움이 되려면 시민사회가 적극 참여하고 민주적으로 관리되어야 한다고 강조했다. 이 보고서는 AI 업계에서 처음으로…

AI가 내 이력서를 공정하게 평가할 수 있을까? 편견은 없을까?

Evaluating the Promise and Pitfalls of LLMs in Hiring Decisions 에이트폴드(Eightfold.ai) 연구팀이 GPT-4o, 클로드(Claude), 제미나이(Gemini) 등 주요 생성형 AI 모델들의 채용 과정에서의 정확성과 편향성을…

“챗GPT야, 승진시킬 사람 골라줘”… 美 회사 절반이 AI 챗봇에게 인사결정 물어봐

미국 기업의 관리자들이 인공지능을 활용해 직원들의 승진, 해고, 급여 인상 등 중요한 인사결정을 내리는 비율이 급속히 증가하고 있는 것으로 나타났다. AI 기반의 온라인 이력서…

“10대는 이기적, 노인은 친절?” AI 모델 10개의 나이·성별·인종 편견 분석

The Biased Samaritan: LLM biases in Perceived Kindness 대형 언어모델(Large Language Models, LLMs)이 다양한 분야에서 널리 활용되면서, 이들 모델이 가진 편향성에 대한 우려가 커지고…

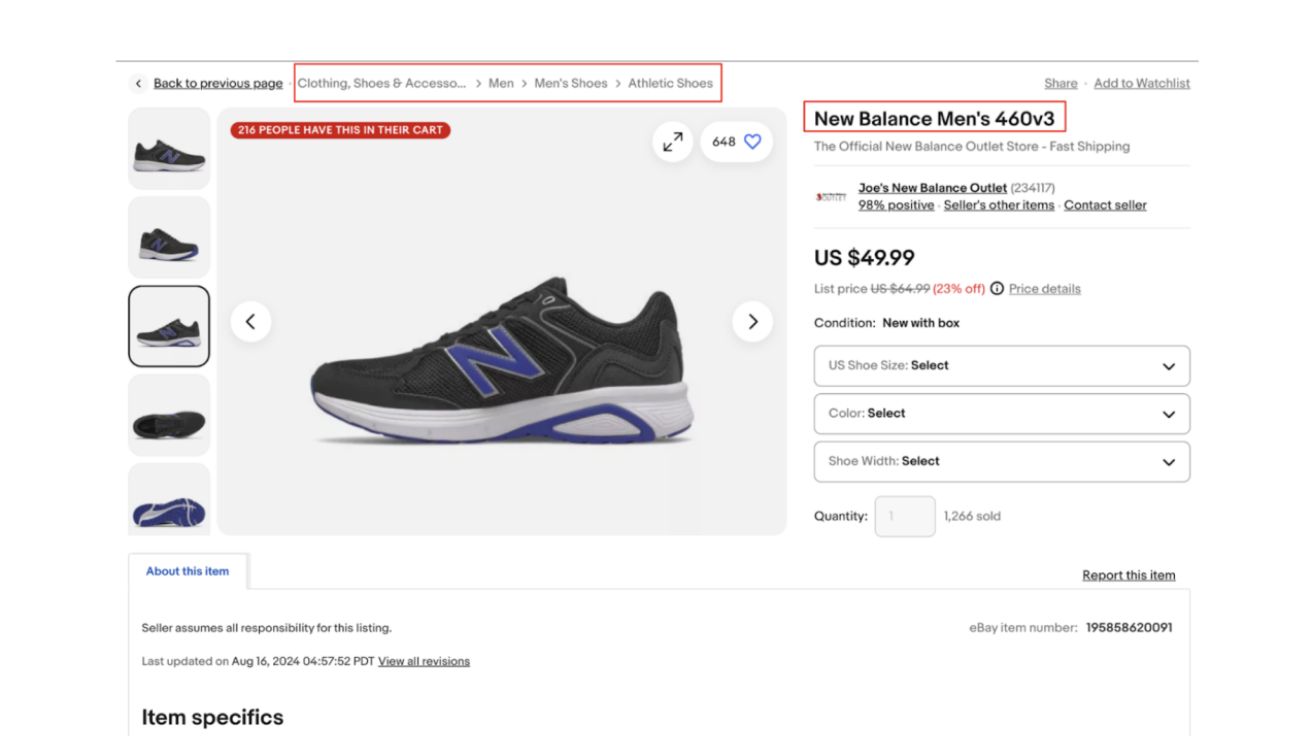

“여성은 곡선미, 남성은 편안함” AI 상품소개서 속 숨겨진 차별

Understanding Gender Bias in AI-Generated Product Descriptions “사이즈4는 대부분에게 완벽” – 의류 설명 14%에서 발견된 체형 배제 언어 대형 언어 모델(LLM)이 이커머스 분야에서 상품…

구글, AI 검색 위해 웹사이트 데이터 무단 사용 결정… “AI 학습 거부하면 검색 결과에서 제외할 것”

구글(Google)이 인공지능 기반 검색 서비스에서 웹 퍼블리셔들에게 참여 여부를 선택할 수 있는 옵션을 제공하지 않기로 결정했다는 내부 문서가 공개됐다. 블룸버그가 19일(현지 시간) 보도한 내용에…

AI 사고 13배 급증, 기업들은 어떻게 대응하고 있나? 오픈AI·구글부터 국내 기업까지

AI 신뢰성 및 윤리 제도 연구 AI 사고 1년간 13배 급증, 공익적·경제적 피해 대부분…기업들 신뢰성 확보 총력전 소프트웨어정책연구소가 발표한 보고서에 따르면, 생성형 AI의 급속한…

AI 모델 평가 ‘크라우드소싱 벤치마크’에 전문가들 문제 제기… “과장된 결과 홍보 위해 악용돼”

테크크런치가 22일(현지 시간) 보도한 내용에 따르면, 테크 업계에서 인공지능 모델의 성능을 평가하는 크라우드소싱 벤치마크 플랫폼에 대한 우려의 목소리가 커지고 있다. 오픈AI(OpenAI), 구글(Google), 메타(Meta) 등…

AI 신뢰도가 기업 성패 가른다… 76%의 기업이 말하는 ‘책임 있는 AI’의 경쟁 우위

Implementing responsible AI in the generative age ‘책임 있는 AI’ 원칙, 기업 경쟁력의 핵심 요소로 자리매김 MIT 테크놀로지 리뷰 인사이트(MIT Technology Review Insights)가 250명의…

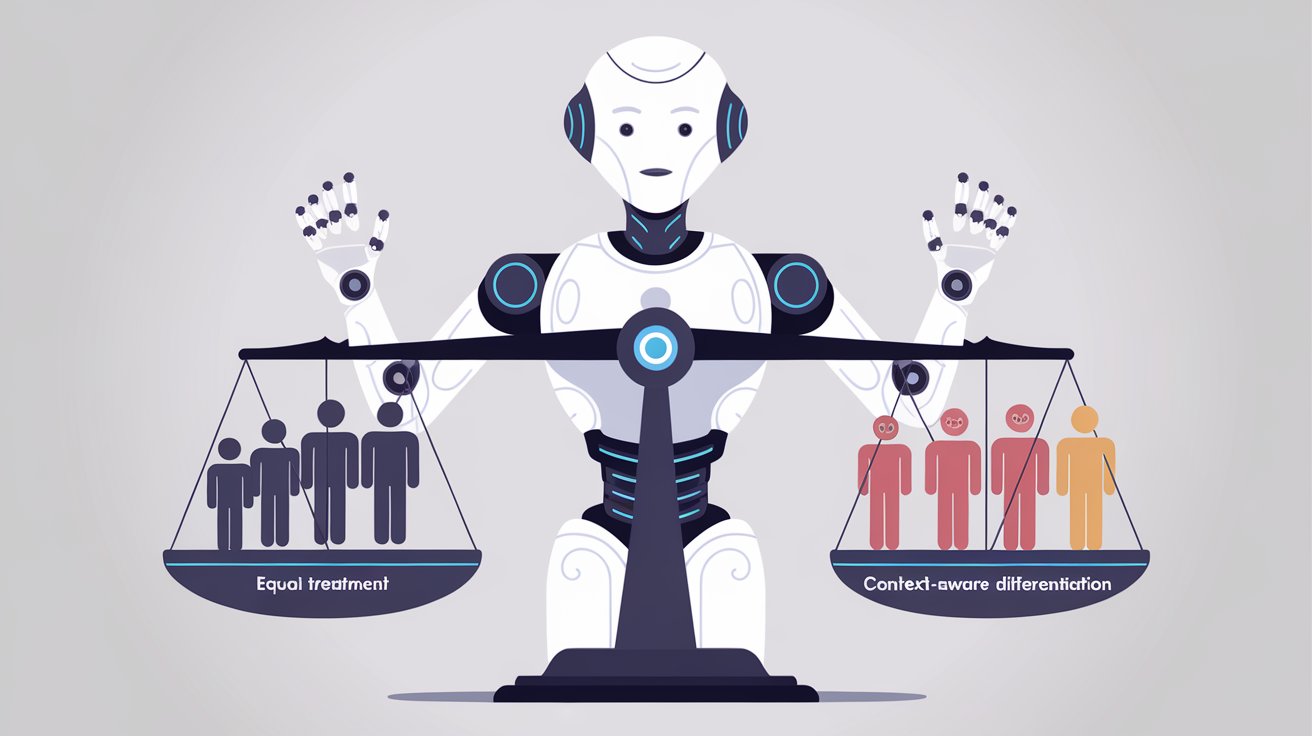

모든 차별이 나쁜가?… AI 공정성에 대한 스탠포드 연구진의 새로운 제안

Fairness through Difference Awareness: Measuring Desired Group Discrimination in LLMs 스탠포드 대학교 연구진이 발표한 논문 “차이를 인식하는 공정성: LLM에서 집단 간 차별의 측정”에 따르면,…

AI 챗봇 평가 플랫폼의 치명적 결함 발견… 수백 번의 투표로 순위 조작 가능해

Improving Your Model Ranking on Chatbot Arena by Vote Rigging 170만 건의 투표 데이터로 입증된 챗봇 아레나의 취약점 홍콩과학기술대학교와 Sea AI Lab 연구진이 공개한…

AI 돌봄로봇 도입의 성패, 윤리적 가이드라인에 달렸다

Trust and acceptance of AI caregiving robots: The role of ethics and self-efficacy AI 의료·돌봄 시장의 폭발적 성장과 과제 대만 가오슝대학교 정보관리학과 연구진의 최신…

일반인도 AI 편향성 유발 가능? 생성형 AI의 숨겨진 한계와 전략 분석

생성형 AI(Generative AI)의 기술이 발전하고 대중화되면서, 편향적 결과물을 생성할 가능성은 윤리적 논의의 핵심으로 자리 잡고 있다. 펜실베이니아주립대학교에서 진행된 연구는 일반 사용자들이 어떤 방식으로 AI의…

오픈AI, 생성형 AI 챗봇의 공정성 평가 위한 연구 진행

OpenAI 연구팀은 ChatGPT와 같은 생성형 AI 챗봇의 공정성을 평가하기 위해 대규모 연구를 수행했다. 이 연구는 챗봇이 사용자 이름에 따라 다른 응답을 생성하는지 분석했으며, 이를…

OpenAI, 챗봇의 ‘일인칭 공정성’ 연구 결과 발표 – 이름 기반 편향 평가 방법론 제시

OpenAI 연구진이 ChatGPT와 같은 대화형 AI 시스템에서 사용자 간 공정성을 평가하고 개선하기 위한 새로운 방법론을 제시했다. ‘일인칭 공정성(First-Person Fairness)’이라 명명된 이 접근법은 챗봇과 직접…

AI, 과학 출판 “공정성과 효율성 높일 것”

AI가 의료 분야를 넘어 학술 출판 영역에서도 중요한 역할을 할 것으로 전망된다. 보스턴 대학교 의과대학의 하워드 바우크너(Howard Bauchner) 교수는 European Journal of Emergency Medicine…

생성형 AI 모델, 의료 분야 데이터 불균형 문제 해결에 기여

의료 분야에서 인공지능(AI) 모델의 활용이 늘어나고 있지만, 데이터 불균형 문제로 인해 특정 집단에 대한 진단 정확도가 낮아지는 문제가 지속되어 왔다. 최근 구글 딥마인드(Google DeepMind)…